Explore Any Narratives

Discover and contribute to detailed historical accounts and cultural stories. Share your knowledge and engage with enthusiasts worldwide.

Le 7 janvier 2026, le hall central du Las Vegas Convention Center bourdonnait d’une énergie particulière. Ce n’était plus le fracas habituel des jeux vidéo ou le clinquant des écrans géants. Une tension presque intellectuelle régnait. Sur les stands de Lenovo, HP et Asus, les présentateurs ne parlaient plus de mégahertz ni de cœurs de processeur. Ils parlaient de TOPS – Tera Operations Per Second – et de NPU. Ils démontraient des ordinateurs qui résumaient silencieusement des réunions, effaçaient des arrière-plans en temps réel sans effort processeur, et traduisaient des appels vidéo en direct. Un changement tectonique, silencieux mais total, venait de s’achever. Le PC personnel était mort. Vive le PC personnel intelligent.

Cette intelligence n’est pas une application que vous lancez. Elle est la fondation même de la machine. Elle est tissée dans le silicium du Neural Processing Unit (NPU), dans les lignes de code de Windows 11 et des Chromebooks Plus, dans la conception même des ventilateurs et des châssis. Nous ne nous connectons plus à l’IA. Nous nous asseyons à l’intérieur d’elle. Et cette transformation radicale, qui redéfinit notre outil de travail le plus fondamental, est moins le fruit d’une révolution soudaine que l’aboutissement d’une pression économique implacable et d’une course technologique dont les racines plongent dans la pandémie.

Pour comprendre la frénésie actuelle autour du PC IA, il faut revenir à la fin de l'année 2025. Les données de TechInsights étaient sans appel : la vague monumentale de renouvellement du parc déclenchée par le télétravail pendant la COVID-19 était terminée. Les cycles de remplacement s’allongeaient, atteignant des creux historiques. L’industrie se dirigeait droit vers une période de stagnation. Le consommateur et l’entreprise n’avaient plus de raison impérieuse de changer un portable qui, objectivement, fonctionnait encore très bien pour la suite Office et la navigation web.

Le marché était à la croisée des chemins. Nous sortions d'un cycle de croissance exceptionnel et entrions dans une phase de maturité où la performance brute ne suffisait plus à justifier un achat. Il nous fallait une nouvelle proposition de valeur, un changement de paradigme. L'IA embarquée, l'on-device AI, est devenue cette proposition.

Cette analyse, partagée en off par un cadre marketing d'un grand constructeur, résume le calcul froid derrière la chaleur des présentations. Les fabricants avaient besoin d’un nouvel argument, et cet argument devait être systémique, impossible à rétrofitter sur une machine vieille de trois ans. Ainsi est née la notion d’« AI PC », un terme que le cabinet d'analyse IDC a rapidement cadré par une définition matérielle stricte : tout PC doté d'un NPU dédié. Microsoft a surenchéri avec sa certification Copilot+ PC, exigeant au minimum 16 Go de RAM et une puissance NPU spécifique pour faire tourner des modèles de langage localement. Le cadre était posé. La course était lancée.

Au centre de cette mutation se trouve une puce spécialisée : le NPU. Ce n'est pas le CPU, le cerveau généraliste. Ce n'est pas le GPU, le muscle graphique. Le NPU est un accélérateur neuromorphique, conçu pour une seule famille de tâches : les opérations matricielles massivement parallèles qui sous-tendent l'intelligence artificielle. Sa présence transforme l'architecture matérielle. Prenons l'exemple du Asus Vivobook S14 présenté au CES 2026. Son argument principal n'est pas son processeur Intel Core Ultra Series 3, mais la capacité de son NPU à atteindre 50 TOPS. C'est cette puissance dédiée qui permet à la webcam d'appliquer un flou d'arrière-plan en temps réel sans pénaliser les performances, ou à l'application de conférence de générer un compte-rendu en direct.

Les effets sont concrets, quotidiens. La réduction active du bruit lors d'un appel Zoom cesse d'être une fonction logicielle gourmande pour devenir une opération native, économe en énergie. La transcription et la traduction simultanée d'une réunion internationale deviennent possibles sans envoyer un seul octet de données audio vers le cloud. Cette exécution locale n'est pas qu'une question de performance ; c'est une promesse de confidentialité et de réactivité. L'IA quitte la sphère lointaine et abstraite des data centers pour s'incarner dans la machine posée sur vos genoux.

Avant, l'IA était un outil auquel on se connectait, comme un site web. Désormais, c'est quelque chose qui est simplement là, comme l'électricité. Elle alimente des fonctions que vous ne voyez même plus, mais qui fluidifient chaque interaction. Le matériel a enfin rattrapé l'ambition logicielle.

Cette observation d'un analyste de Trafera pointe vers un changement profond d'expérience utilisateur. L'intelligence n'est plus une destination, mais le chemin lui-même.

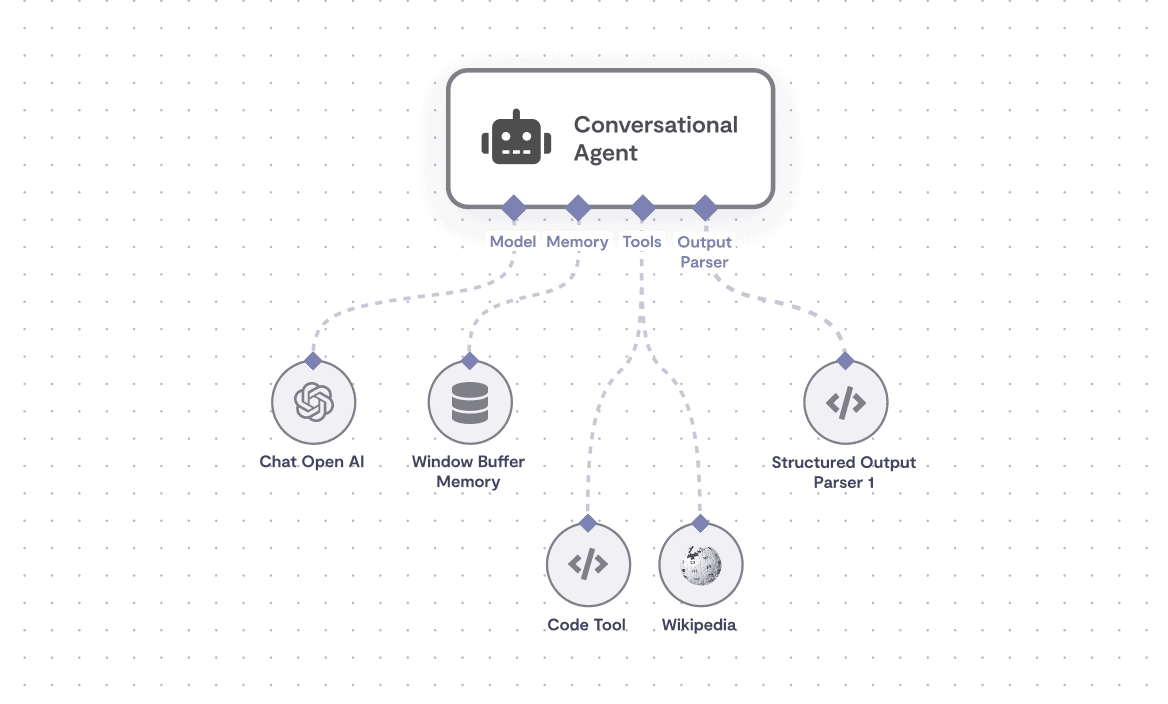

Si le NPU est le cœur, l'agent personnel en est l'âme. Et sur ce front, Lenovo a, en janvier 2026, posé un jalon significatif avec le dévoilement de Lenovo Qira. Présenté comme un « personal AI super agent », Qira n'est pas une simple application. C'est une entité logicielle persistante, conçue pour maintenir le contexte de vos activités à travers vos appareils – PC, tablette, smartphone. Son architecture est hybride : certaines tâches s'exécutent en local sur le NPU du PC pour la rapidité et la confidentialité, d'autres, plus lourdes, peuvent déborder sur le cloud.

Imaginez commencer la rédaction d'un rapport sur votre ThinkPad au bureau. Sur le chemin du retour, vous consultez des données complémentaires sur votre tablette. Qira maintient le fil. Le lendemain, en ouvrant votre portable personnel, il peut vous proposer de reprendre là où vous vous étiez arrêté, avec le contexte préservé. Ce n'est pas de la synchronisation de fichiers. C'est de la continuité cognitive assistée. Lenovo insiste sur une approche « privacy-first », un argument crucial pour les entreprises et les utilisateurs méfiants vis-à-vis de l'externalisation de leurs données de travail.

La matérialisation de cette ambition a nécessité une refonte physique. Les nouveaux ThinkPad X1 Carbon Gen 14 Aura Edition et X1 2-in-1 Gen 11 Aura Edition intègrent un châssis révolutionnaire dit Space Frame. La carte mère n'est plus un plateau unique ; les composants sont répartis des deux côtés, comme un sandwich technologique. Cette conception, selon Lenovo, améliore le refroidissement – essentiel pour maintenir les performances soutenues du NPU – et simplifie la maintenance. Les ports USB, la batterie, le clavier, les haut-parleurs et les ventilateurs deviennent remplaçables par l'utilisateur. Le PC, devenu plus intelligent, redevient aussi, paradoxalement, plus accessible et réparable.

Cette philosophie se prolonge dans les tours de travail. Le ThinkCentre X Tower est conçu explicitement pour les workflows IA lourds en local, avec des options à double GPU et un logiciel, AI Fusion, permettant de faire du fine-tuning (affinage) de modèles de langage atteignant jusqu'à 70 milliards de paramètres sans quitter la machine. Nous ne sommes plus dans l'inférence simple (utiliser un modèle), mais dans l'entraînement léger et la personnalisation profonde. Le PC redevient une station de travail souveraine, capable de digérer et d'adapter l'intelligence à des besoins métiers très spécifiques, qu'il s'agisse d'analyse juridique, de recherche médicale ou de création de contenu marketing.

Le paysage qui se dessine n'est donc pas unifié. Il se segmente entre l'agent personnel ubiquitaire et discret (Qira) et la puissance de calcul IA focalisée et experte (ThinkCentre X Tower). Deux visages d'une même révolution, répondant à deux angoisses modernes : la fragmentation de notre attention et la complexité croissante des données à maîtriser.

Pourtant, un obstacle de taille se dresse sur la route de cette utopie informatique : la mémoire. La promesse de faire tourner des modèles d'IA localement a un coût matériel exorbitant en RAM. Les 16 Go minimum de la certification Copilot+ de Microsoft ne sont qu'un point de départ. Pour des modèles plus grands, plus performants, pour un multitâche fluide avec ces agents toujours actifs, 32 Go, voire 64 Go, deviendront la norme pour les machines haut de gamme. Or, début 2026, IDC a tiré la sonnette d'alarme sur une pénurie mondiale de mémoire DRAM et NAND. Cette tension sur la supply chain menace directement le récit de croissance du PC IA. Construire une machine intelligente nécessite des ressources, et la plus fondamentale d'entre elles vient à manquer.

Alors que la première partie de cette transformation se joue sous nos yeux – la standardisation du NPU, l'émergence des agents – les prochains chapitres s'annoncent plus tumultueux. Ils impliqueront une guerre des architectures entre x86, Arm et RISC-V, une reconfiguration totale de la chaîne d'approvisionnement, et des questions éthiques brûlantes sur la nature de cette intelligence que nous invitons au plus près de nos pensées numériques. La course pour l'IA embarquée a démarré. Mais la piste est bien plus longue et accidentée que les lumières du CES ne pouvaient le laisser paraître.

Derrière le miroitement des stands et les promesses de productivité révolutionnaire, l'industrie du PC IA marche sur une corde raide. D'un côté, des prévisions de croissance vertigineuses. De l'autre, une réalité matérielle brutale qui menace de faire dérailler l'ensemble du récit. En décembre 2025, le rapport de The Futurum Group, cité par CIO Dive, a jeté un pavé dans la mare de l'optimisme. Il prévoyait que 55% du marché total du PC en 2026 serait composé de machines dotées d'un NPU. Sur cinq ans, le segment devrait croître à un CAGR de 38%, avec un scénario optimiste tablant sur un marché de presque 350 milliards de dollars d'ici 2030. Des chiffres qui justifient l'investissement frénétique de tous les acteurs.

"Eventually, AI PCs will replace most, if not all, traditional PCs." — Olivier Blanchard, Research Director, The Futurum Group

Mais cette trajectoire de fusée se heurte immédiatement à un mur de briques. Le même rapport tempérait l'enthousiasme en pointant les limites actuelles. Les premiers PC IA, ceux de 2024 et 2025, offrent des capacités on-device souvent anecdotiques. La majorité des fonctions dites « intelligentes » reposent encore sur une connexion cloud. Olivier Blanchard l'admettait : "Many of the AI PCs available in the market today have limited capabilities, particularly for enterprise use." Le matériel a devancé le logiciel. Les fondeurs ont livré des NPU puissants, mais les développeurs peinent à créer des applications qui exploitent pleinement cette puissance localement, en dehors de quelques démonstrations techniques.

La frustration des utilisateurs monte. Elle n'est pas anecdotique. Une analyse de Tom's Hardware fin 2025 a capté ce mécontentement sourd. "The AI PC marketing push has not produced the growth vendors hoped for," notaient-ils. "User enthusiasm has been muted, and frustration with the rapid, often forced integration of AI features — particularly in Windows 11 — is increasingly visible." On reproche à ces fonctions d'être intrusives, mal calibrées, ou simplement inutiles. Le raccourci clavier pour Copilot, activé par défaut, est devenu le symbole de cette imposition. L'industrie a cru que la technologie créerait le besoin. Elle découvre, douloureusement, que l'inverse est toujours vrai.

Pendant que le marketing vante les TOPS, les directeurs d'approvisionnement des OEM suent à grosses gouttes. La crise est systémique. IDC l'a formalisée dans un rapport glaçant fin 2025 sur la pénurie mondiale de mémoire. La demande explosive des data centers pour l'IA, avides de DRAM haut de gamme et de HBM (High Bandwidth Memory), a siphonné les capacités de production. Les fondeurs de puces mémoire, attirés par des marges bien plus juteuses, ont réalloué leurs lignes. Résultat : une pénurie sévère et une flambée des prix pour la mémoire standard DDR5, celle qui équipe les PC.

"These AI workloads require large amounts of memory, and the shortage, in part, is driven by a reallocation of manufacturing capacity (…) toward memory used in AI data centers." — IDC, Global Memory Shortage Crisis Report

L'ironie est cruelle. Pour faire tourner l'IA localement et réaliser la promesse d'autonomie vis-à-vis du cloud, il faut de la RAM. Beaucoup de RAM. Les exigences minimales de Microsoft pour les Copilot+ PC ont placé la barre à 16 Go. Mais pour des modèles de langage plus performants et un multitâche fluide, 32 Go deviennent la cible sur le haut de gamme. Or, ce sont précisément ces composants qui deviennent rares et chers. IDC a modélisé l'impact : une contraction du marché global du PC entre 4,9% et 8,9% en 2026 directement imputable à cette tension. L'industrie est prise à son propre piège. Elle pousse un produit qui nécessite le composant qu'elle a elle-même rendu inaccessible.

Les conséquences sont déjà visibles. Consumer Reports a alerté en janvier 2026 sur un phénomène de dé-spécification silencieuse. Pour maintenir des prix attractifs face au coût de la mémoire, les constructeurs rognent sur d'autres composants : écrans de résolution inférieure, batteries plus petites, chassis en plastique. Le PC IA « milieu de gamme » risque de devenir une machine boiteuse, intelligente sur le papier mais limitée dans son expérience globale. La segmentation du marché va s'exacerber. D'un côté, des machines élitistes à 32 ou 64 Go de RAM, réservées aux professionnels et aux passionnés aisés. De l'autre, une masse de portables estampillés « AI PC » mais incapables de livrer la magie promise, creusant encore le fossé de la frustration.

Alors que l'industrie tente de résoudre l'équation mémoire, une guerre plus fondamentale se joue dans le silicium. Le règne sans partage de l'architecture x86 (Intel, AMD) sur le PC est contesté comme jamais. L'exigence d'efficacité énergétique des workloads d'IA – plus de performances par watt, moins de chaleur, plus d'autonomie – joue en faveur des architectures alternatives. Arm, porté par le succès fracassant d'Apple avec ses puces M-series, entre sur le terrain de chasse traditionnel de Windows. Les Snapdragon X d'Qualcomm, conçus explicitement pour les PC Windows on Arm, embarquent des NPU rivalisant avec les meilleures offres x86.

Les chiffres du terrain sont éloquents. Au quatrième trimestre 2025, HP a révélé que les PC IA représentaient déjà 30% de ses expéditions totales. Une part significative de ces machines, notamment dans les segments ultraportables et à longue autonomie, repose sur du silicium Arm. Dell, de son côté, a relevé ses prévisions de revenus liés à l'IA – PCs et serveurs confondus – à 25 milliards de dollars pour son exercice 2026, soit une augmentation stupéfiante de 150% sur un an. Cet argent irrigue la recherche et développement pour des machines hybrides, capables de jongler avec différents types de cœurs de calcul.

Mais la vraie disruption pourrait venir d'ailleurs. Des OEM chinois, face aux restrictions technologiques, expérimentent activement des puces HiSilicon Kirin et explorent l'architecture open-source RISC-V. Cette dernière, libre de redevances et hautement modulable, présente un potentiel énorme pour créer des accélérateurs IA spécialisés et low-cost. TechInsights anticipe que cette diversification architecturale, poussée par des considérations géopolitiques autant que techniques, va s'accélérer d'ici 2026-2027. Le paysage du silicium pour PC, monolithique pendant des décennies, se fragmente. Pour le consommateur, cela pourrait se traduire par une plus grande variété de choix et une spécialisation des machines. Pour les développeurs de logiciels et de pilotes, c'est un cauchemar de compatibilité qui commence.

"IDC defines an AI PC simply as a system with an NPU." — IDC, Market Analysis Report

Cette définition minimaliste, aussi pragmatique soit-elle, masque une réalité complexe. Un NPU Arm de 45 TOPS n'est pas l'équivalent fonctionnel d'un NPU x86 de 50 TOPS. Les logiciels doivent être compilés spécifiquement, les bibliothèques d'optimisation diffèrent. La promesse d'une expérience IA transparente se brise sur le mur de la diversité matérielle. Microsoft tente de jouer les arbitres avec sa plateforme Pluton et ses exigences Copilot+, mais la tâche est herculéenne. L'écosystème Windows, déjà fragmenté, risque de se diviser en sous-écosystèmes architecturaux parallèles.

Au cœur de cette tourmente se trouve Microsoft, architecte en chef de l'expérience PC IA avec Windows 11 et Copilot. Sa stratégie est claire : faire du PC le hub central de l'IA personnelle et professionnelle. Pourtant, un paradoxe frappant émerge des données de janvier 2026. Sur le front du web, terrain de bataille le plus visible de l'IA grand public, Copilot est à la traîne. Selon Windows Latest, sa part de marché web stagnait autour de 1,1%, face aux 64,5% de ChatGPT et 21% de Gemini.

Ce décalage est riche d'enseignements. Il révèle que la domination sur le desktop ne garantit pas la victoire dans l'esprit des utilisateurs. L'assistant intégré à Windows est perçu comme une fonctionnalité parmi d'autres, souvent intrusive, rarement indispensable. Son succès est conditionné à la qualité de l'intégration native, à sa capacité à comprendre le contexte local de l'utilisateur – ses fichiers, ses emails, son agenda – sans violer sa vie privée. C'est là que le pari du « on-device » prend tout son sens. Mais c'est aussi là que les limites des premiers PC IA, pointées par Olivier Blanchard, se font le plus sentir : "That will change over time, as software vendors bring more on-device AI functionality to market." Le temps, justement, est une ressource que Microsoft ne possède pas en abondance. La concurrence web évolue à une vitesse folle.

"Microsoft’s Copilot+ requirements alone set a 16GB floor, and many premium designs are targeting 32GB or more." — IDC, Global Memory Shortage Crisis Report

L'optimisme financier lié à l'IA, qui a propulsé le Dow Jones à un record historique lors du CES 2026 selon Mexico Business News, repose sur une foi dans la matérialisation future des bénéfices. Une étude citée par Nasdaq révèle que 68% des PDG prévoient d'augmenter leurs dépenses en IA en 2026. Pourtant, moins de la moitié des projets IA actuels sont considérés comme rentables. C'est toute la dynamique du secteur : un investissement massif basé sur une conviction, contredit par des résultats commerciaux encore timides et une chaîne d'approvisionnement en crise.

Alors, l'engouement pour le PC IA est-il un bubble prêt à éclater ? La question n'est pas incongrue. Les signaux contradictoires s'accumulent. D'un côté, une demande structurelle pour une informatique plus proactive et sécurisée. De l'autre, des coûts prohibitifs, une utilité immédiate discutable, et une complexité technique croissante. La réponse se nichera dans la capacité de l'industrie à dépasser le stade de la démonstration pour entrer dans celui de l'utilité quotidienne et invisible. Le prochain chapitre ne se jouera pas sur les stands des salons, mais dans les open spaces des entreprises et sur les bureaux des particuliers, où la magie devra, enfin, justifier son prix et ses inconvénients.

La signification profonde de l’émergence du PC IA transcende largement les arguments marketing sur la productivité. Elle marque un changement de paradigme dans notre relation à la machine. Pendant des décennies, l’ordinateur personnel a été un outil, essentiellement passif. Il exécutait des commandes. L’ère du PC IA inaugure celle de l’ordinateur comme partenaire, doté d’une capacité d’anticipation et d’initiative. Cette transition n’est pas anodine ; elle redéfinit les frontières de l’intimité numérique. Lorsque l’agent IA, comme Lenovo Qira, maintient le contexte de votre travail à travers vos appareils, il devient le dépositaire de votre flux de conscience professionnel. La promesse d’une exécution locale, « privacy-first », n’est pas qu’un argument technique. C’est une tentative de réconciliation entre l’intelligence ambiante et la souveraineté individuelle sur les données.

L’impact industriel est tout aussi radical. Il sonne le glas du modèle unique. La standardisation x86 qui a régné sur le PC pendant quarante ans vole en éclats sous la pression des architectures Arm et de l’émergence de RISC-V. L’efficacité énergétique, et non plus la fréquence brute, devient la métrique reine. Cette diversification forcée pourrait, à terme, bénéficier au consommateur en offrant des machines plus spécialisées et adaptées à des usages précis. Mais elle impose aussi une fragmentation douloureuse pour les développeurs et une complexité accrue pour les acheteurs. Le marché se segmente entre les machines grand public « IA light » et les stations de travail expertes capables de fine-tuning local, comme le ThinkCentre X Tower et ses modèles de 70 milliards de paramètres. La démocratisation de l’IA a un prix : la fin de l’universalité du PC.

"Une majorité des applications IA sont encore basées sur le navigateur. Il n'y a pas besoin que tous les nouveaux PC soient à la pointe des capacités IA on-device pour le moment." — Olivier Blanchard, The Futurum Group

Cette remarque, lucide, rappelle que la révolution est encore en phase de déploiement logiciel. L’infrastructure est prête, mais les usages transformateurs se font attendre. La véritable mesure du succès ne sera pas le nombre de TOPS vendus, mais l’émergence d’applications qui rendront inconcevable le retour en arrière. Des applications qui ne se contenteront pas de paraphraser des emails, mais qui orchestreront des workflows complexes, généreront des insights à partir de données privées, ou co-créeront du contenu de manière véritablement symbiotique.

Derrière le vernis futuriste, des failles critiques apparaissent. La première est économique. La pénurie de mémoire, couplée à la course aux spécifications, rend ces machines inaccessibles à une large part du marché. Le risque est de créer une fracture numérique d’un nouveau genre : non plus entre ceux qui ont un ordinateur et ceux qui n’en ont pas, mais entre ceux qui possèdent une IA locale performante et ceux qui doivent se contenter d’une IA cloud, plus lente, moins personnalisée et soumise aux aléas des connexions et des politiques de confidentialité des géants technologiques. L’idéal d’une intelligence décentralisée et émancipatrice pourrait n’être, en réalité, qu’un privilège de plus.

La deuxième faille concerne l’utilité réelle. La frustration des utilisateurs, rapportée par Tom’s Hardware, n’est pas un épiphénomène. Elle est le symptôme d’une technologie en quête de problème à résoudre. Trop de fonctionnalités IA actuelles ressemblent à des solutions en recherche d’un besoin : la suppression de bruit était déjà acceptable, le flou d’arrière-plan est souvent un gadget, et la génération de texte reste perfectible. Le danger est que cette surenchère de « features » alourdisse les interfaces, complexifie les logiciels et distraie l’utilisateur plus qu’elle ne l’assiste. L’industrie doit éviter le piège de l’IA pour l’IA.

Enfin, il y a le risque de la dépendance. En intégrant l’intelligence au cœur du système d’exploitation, Microsoft, Google et Apple créent des écosystèmes fermés. Votre agent personnel Lenovo Qira fonctionnera-t-il aussi bien sur un Dell ? Les modèles d’IA optimisés pour les NPU Intel seront-ils compatibles avec les puces AMD ou Qualcomm ? La bataille des standards, qui a fait rage à l’ère des navigateurs web, se rejoue aujourd’hui sur le terrain de l’intelligence embarquée. Le consommateur pourrait se retrouver enfermé dans un silo matériel et logiciel encore plus contraignant qu’auparavant.

La question de la sécurité prend aussi une dimension nouvelle. Un NPU est un composant opaque. Son fonctionnement interne est souvent un secret commercial. Que se passe-t-il si une vulnérabilité y est découverte ? Comment auditer les décisions prises par un modèle d’IA tournant en local ? La confiance, pierre angulaire de cette nouvelle ère, est fragile.

L’optimisme des PDG, dont 68% prévoient d’augmenter leurs dépenses en IA selon Nasdaq, repose sur une vision à long terme. Mais la route est semée d’embûches techniques, économiques et éthiques. L’industrie a souvent surestimé l’adoption immédiate de nouvelles technologies – on se souvient de la réalité virtuelle – tout en sous-estimant leurs impacts à long terme – comme avec les réseaux sociaux. Le PC IA se situe précisément à cette intersection périlleuse.

Les prochains mois seront déterminants. La seconde moitié de 2026 verra l’arrivée des premières machines de seconde génération, intégrant les leçons des lancements parfois précipités de 2025. Les développeurs de logiciels, ayant désormais un parc installé significatif de machines dotées de NPU, commenceront enfin à publier des applications qui en exploitent pleinement le potentiel. La pression sur les prix de la mémoire pourrait, selon certains analystes, commencer à se relâcher fin 2026 avec l’entrée en production de nouvelles usines.

Mais le test ultime aura lieu en silence, loin des salons et des communiqués de presse. Il se jouera à 22h, lorsque l’utilisateur fatigué demandera à sa machine de finaliser une présentation en s’inspirant de ses notes éparses. Il se jouera dans une salle de réunion où la traduction temps réel permettra une collaboration authentique, sans friction. Il se jouera dans la capacité de cette intelligence à se faire oublier, à devenir une extension fluide de l’intention humaine, et non une distraction de plus.

Le hall du CES 2026 était bruyant de promesses. L’avenir dira si ces machines, plus intelligentes, sauront aussi se montrer plus sages. La question n’est plus de savoir si votre prochain portable sera intelligent, mais s’il saura vraiment vous comprendre, et à quel prix.

Your personal space to curate, organize, and share knowledge with the world.

Discover and contribute to detailed historical accounts and cultural stories. Share your knowledge and engage with enthusiasts worldwide.

Connect with others who share your interests. Create and participate in themed boards about any topic you have in mind.

Contribute your knowledge and insights. Create engaging content and participate in meaningful discussions across multiple languages.

Already have an account? Sign in here

TSMC domine le marché des puces IA avec des revenus records de 3 809 milliards de dollars taïwanais en 2025, mais sa dép...

View Board

La Corée du Sud parie 500 millions sur FuriosaAI pour défier Nvidia avec sa puce Renegade, 40% plus économe en énergie p...

View Board

L'ère du silicium spécialisé s'ouvre avec l'ascension des ASIC et des puces modulaires, défiant l'hégémonie des GPU et r...

View Board

Deepgram lève 130 M$ en Série C pour dominer l'IA vocale mondiale, étend Nova-3 à 10 langues et acquiert OfOne.

View Board

AMD lance Helios, un rack IA de 3 exaflops, défiant Nvidia avec 72 GPU MI455X et un partenariat clé avec OpenAI.

View Board

Google LiteRT révolutionne l'IA embarquée en permettant l'exécution de modèles sur microcontrôleurs avec seulement 16 Ko...

View Board

Le TinyML révolutionne l'électronique en intégrant une IA ultra-frugale dans les objets du quotidien, transformant therm...

View Board

Spot, le robot quadrupède de Boston Dynamics, redéfinit les interventions à risque en devenant un partenaire opérationne...

View Board

En 2026, les nouvelles lois tech en Californie et au Texas entrent en conflit avec un ordre fédéral, créant une bataille...

View Board

L'écran et l'âme : le dilemme numérique de la santé mentale Mars 2024. Dans un cabinet parisien, une patiente décrit à ...

View Board

La cryptographie derrière la machine Enigma : comment des mathématiciens ont brisé le code nazi et changé l'histoire.

View Board

Meta mise 2 milliards de dollars sur Manus, une startup d'IA rentable, pour dominer le marché des agents intelligents et...

View Board

La chute d'iRobot : comment le pionnier américain des robots domestiques, symbole d'innovation, a succombé sous les tari...

View Board

Découvrez comment les lunettes IA génératives deviennent des assistants mains libres discrets, traduisant en temps réel,...

View Board

Découvrez comment l'IA devient un collègue de travail en 2026, transformant les usines, les bureaux et les vignobles ave...

View Board

L'IA en 2026 : révolution silencieuse ou tournant critique ? Le 12 mars 2024, un agent d’intelligence artificielle a, d...

View Board

L'IA crée en quelques minutes des milliers de molécules ciblées, diminue de dix le délai pré‑clinique et valide rapideme...

View Board

L'IA révolutionne la découverte de médicaments, compressant des années de recherche en mois, réduisant les coûts et ouvr...

View Board

Google LiteRT redefine IA em dispositivos pequenos, com execução local, baixa latência e eficiência energética em smartp...

View Board

KI findet 25 neue Magnete für die nächste Generation der Elektromobilität Der Motor eines Elektroautos surrt fast unhör...

View Board

Comments