Explore Any Narratives

Discover and contribute to detailed historical accounts and cultural stories. Share your knowledge and engage with enthusiasts worldwide.

Le 18 mars 2025, AMD a dévoilé son MI400, une solution d’accélération occupant un baie entière. L’annonce était technique, dense. Elle a aussi marqué un point de rupture. L’hégémonie incontestée de NVIDIA sur le silicium de l’intelligence artificielle, forgée sur la polyvalence des GPU, commence à se fissurer sous une pression architecturale et économique implacable.

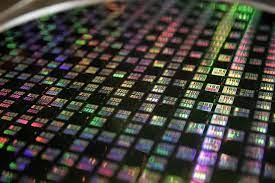

Nous entrons dans l’ère du silicium spécialisé. La course n’est plus seulement à la puissance brute, mais à l’efficacité extrême, à la modularité, et à la distribution du calcul. Alors que les modèles d’IA migrent des centres de données vers la périphérie du réseau – les caméras, les véhicules, les robots d’usine – le matériel qui les exécute doit se réinventer. Deux concepts, jadis confinés aux laboratoires de R&D, sont désormais au cœur de cette révolution : les ASIC (Circuits Intégrés Spécifiques à une Application) et les puces modulaires (chiplets).

Pendant plus d’une décennie, le GPU a été le cheval de bataille de l’IA. Conçu à l’origine pour le rendu graphique, son architecture massivement parallèle s’est avérée providentielle pour les opérations matricielles de l’apprentissage profond. Mais cette polyvalence a un coût : une consommation énergétique élevée et une surface de silicium gaspillée pour des fonctions non utilisées. Pour une tâche unique et répétitive comme l’inférence d’un modèle de vision par ordinateur dans une caméra de surveillance, le GPU est un marteau-pilon pour écraser un clou.

L’ASIC, lui, est le scalpel. Conçu dès le départ pour exécuter un ensemble d’opérations très spécifiques – souvent celles d’un modèle d’IA particulier – il atteint des niveaux d’efficacité énergétique et de performance par watt inaccessibles aux architectures généralistes. Il fait une chose, mais il la fait avec une économie de moyens radicale. Cette spécialisation est devenue un impératif économique. Le marché du calcul pour les centres de données devrait dépasser 600 milliards de dollars d’ici 2030. Dans cette ruée vers l’or, les géants du cloud ne veulent plus être des acheteurs passifs. Ils deviennent des fondeurs.

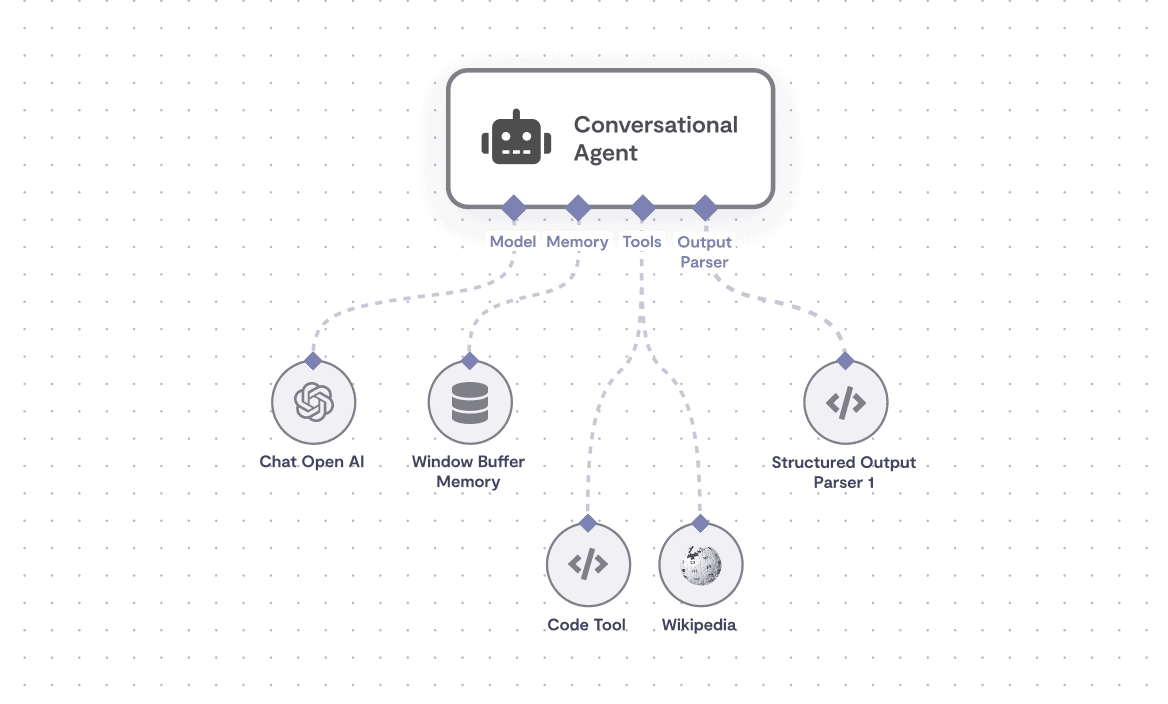

La dynamique du marché a basculé d’une économie du hardware à une économie de l’écosystème de calcul. La valeur ne réside plus seulement dans la puce, mais dans la pile logicielle, les outils de développement et l’optimisation extrême pour des charges de travail hyper-spécifiques.

Google a ouvert la voie avec son Unité de Traitement Tensoriel (TPU), un ASIC maison. Aujourd’hui, en Amérique du Nord comme en Chine, les développements internes s’accélèrent. Les pressions géopolitiques sur l’approvisionnement en semi-conducteurs ne font qu’accentuer cette tendance. En mars 2025, l’entreprise néerlandaise Axelera a reçu 61,6 millions d’euros de l’entreprise commune EuroHPC spécifiquement pour le développement de sa plateforme basée sur des puces modulaires pour l’IA en périphérie. Le signal est clair : l’avenir ne sera pas monolithique.

Imaginez construire un processeur comme vous assemblez les pièces d’un Lego. C’est l’essence de l’architecture modulaire. Au lieu de graver une unique et gigantesque pastille de silicium (une approche dite « monolithique ») regroupant cœurs de calcul, mémoire et entrées/sorties, on fabrique de petites puces spécialisées – les « briques » – que l’on assemble ensuite physiquement dans un même package. Une brique peut être fabriquée avec la technologie de gravure la plus avancée (2 nm) pour les cœurs de calcul, une autre avec un procédé plus ancien et moins coûteux pour la gestion de l’alimentation.

Les avantages sont multiples. Le rendement de fabrication augmente (une petite puce a moins de risque de défaut qu’une grande). La flexibilité explose : un concepteur peut mélanger et assortir des briques de différents fournisseurs. Le temps de développement et les coûts chutent. On peut réutiliser une brique de connexion éprouvée sur plusieurs générations de produits. Cette approche n’est plus théorique. Elle devient la nouvelle norme industrielle, poussée par des standards ouverts qui garantissent l’interopérabilité entre les briques de différents fabricants.

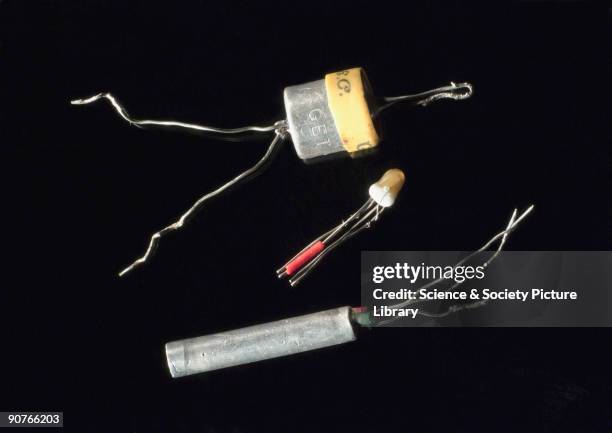

Nous assistons à une transition fondamentale, comparable au passage des circuits intégrés simples aux microprocesseurs. La puce modulaire permet de contourner les limites physiques et économiques de la loi de Moore. Elle n’est pas une simple évolution d’emballage ; c’est une refonte complète de la manière dont nous concevons les systèmes électroniques.

Pour l’IA en périphérie, cette modularité est une bénédiction. Un fabricant de drones peut intégrer une brique d’accélération neuronale ultra-efficace à côté d’un processeur de contrôle existant, sans tout redessiner. Un constructeur automobile peut ajouter un module de vision par ordinateur dans son architecture existante. Cette agilité est indispensable car le paysage de l’IA en périphérie est d’une diversité vertigineuse. Comparez les besoins d’un assistant vocal intelligent dans un haut-parleur, qui fonctionne sur batterie, avec ceux d’une station de tri robotisée dans un entrepôt Amazon, branchée sur le secteur. Un même GPU ne peut pas servir les deux de manière optimale.

Le terme « edge computing » évoquait il y a peu de simples passerelles collectant des données pour les envoyer vers le cloud. En 2026, la périphérie devient un nœud de calcul autonome. L’inférence – le processus d’exécution d’un modèle d’IA sur de nouvelles données – s’y déroule en temps réel. L’apprentissage continu, où le modèle s’ajuste localement aux données qu’il rencontre, devient une fonction standard. Cette migration est rendue possible par la conjonction d’avancées logicielles, comme la quantification des modèles (qui réduit leur précision numérique pour les alléger), et de ce nouveau matériel hyper-spécialisé.

Les bénéfices sont tangibles : une latence réduite à presque zéro pour la prise de décision, une bande passante réseau préservée, une confidentialité améliorée puisque les données sensibles ne quittent plus l’appareil. Et une robustesse accrue : une ligne de production ne s’arrête pas si la connexion cloud tombe. D’ici 2028-2030, le nombre de déploiements d’IA en périphérie devrait dépasser de très loin celui des déploiements dans les centres de données. La masse critique est atteinte.

Regardez les étagères des développeurs aujourd’hui. Elles ne sont plus peuplées uniquement de cartes NVIDIA Jetson. On y trouve le Google Coral Dev Board, le Hailo-8, les modules système Kria d’AMD Xilinx, le Rockchip RK3588. Chacun propose un équilibre différent entre performance, consommation et coût, chacun cible un créneau spécifique de la myriade d’applications de l’IA embarquée. Cette diversité est le symptôme le plus visible d’un marché en pleine maturation et en pleine fragmentation. L’âge de la solution unique et universelle est révolu. L’âge de la spécialisation, de la modularité et de l’efficacité extrême a commencé. Et il ne fait que commencer.

Alors que la périphérie s'éveille à l'intelligence artificielle, les géants du semi-conducteur redéfinissent leurs stratégies, non sans bousculer les hiérarchies établies. AMD, longtemps dans l'ombre de NVIDIA sur le segment de l'IA, a frappé un grand coup lors du CES 2026 en dévoilant la gamme complète de ses accélérateurs Instinct MI400 Series. Ce n'était pas une simple mise à jour ; c'était une déclaration de guerre architecturale, un plan détaillé pour s'emparer d'une part significative du marché du calcul IA, tant dans le cloud qu'à la périphérie. Mais cette ambition, aussi audacieuse soit-elle, ne vient pas sans ses propres défis.

L'annonce phare fut sans conteste la plateforme Helios, un rack complet capable d'atteindre la puissance stupéfiante de 3 exaFLOPS en IA par rack. Pour être précis, il s'agit de 2,9 exaFLOPS en FP4 pour l'inférence et de 1,4 exaFLOPS en FP8 pour l'entraînement. Cette bête de course embarque 72 accélérateurs MI455X, épaulés par 31 téraoctets de mémoire HBM4 et une bande passante mémoire colossale de 1,4 pétaoctets par seconde. Ces chiffres, révélés en janvier 2026, ne sont pas seulement impressionnants ; ils redessinent les frontières de ce qui est possible en termes de calcul intensif. Ils exigent cependant une infrastructure de centre de données à la pointe, notamment pour le refroidissement et l'alimentation, ce qui limite leur déploiement aux acteurs les plus robustes de l'industrie.

« Helios représente bien plus qu'un simple ensemble de puces ; c'est un plan pour le calcul à l'échelle du yotta, offrant jusqu'à 3 exaFLOPS d'IA dans un seul rack. » — AMD, Déclaration officielle lors du CES 2026

Cette déclaration, bien que technique, souligne l'ambition démesurée d'AMD. Mais est-ce suffisant pour ébranler la position dominante de NVIDIA, dont les GPU H100 et B100 sont déjà ancrés dans les infrastructures mondiales ? La véritable innovation du MI400 réside dans son architecture. Il adopte une approche radicalement modulaire, utilisant des chiplets compute gravés sur le procédé TSMC N2 (2 nm). C'est historique : ce sont les premiers GPU à utiliser ce nœud de gravure ultra-fin. Le package massif intègre 12 mémoires HBM4 et 12 dies compute/IO, combinant des procédés de 2 nm et 3 nm. Cette conception permet une optimisation sans précédent pour les basses précisions (FP4, FP8, BF16), cruciales pour l'efficacité silicium en IA.

La stratégie des chiplets, si elle offre une flexibilité et une efficacité remarquables, n'est pas sans risques. La complexité de l'intégration de multiples dies sur un même package, la gestion de la chaleur et la synchronisation des données entre ces composants sont des défis techniques majeurs. AMD semble avoir maîtrisé ces aspects avec des dies de base d'environ 220 mm² et des dies de calcul estimés entre 140 et 160 mm². Le MI430X, par exemple, vise spécifiquement l'IA souveraine et le calcul haute performance (HPC) avec un support renforcé pour les précisions FP32 et FP64, tandis que les MI440X et MI455X se concentrent sur les basses précisions pour maximiser l'efficacité énergétique et réduire les coûts. Cette segmentation fine du marché est une réponse directe à la polyvalence, parfois excessive, des GPU traditionnels.

Le MI440X, avec sa conception compacte à 8 GPU, est conçu pour des déploiements sur site, permettant l'entraînement, le fine-tuning et l'inférence. Il représente une tentative audacieuse de démocratiser l'IA de pointe en la rendant accessible aux entreprises qui ne peuvent pas ou ne veulent pas dépendre entièrement des infrastructures cloud. Mais la question demeure : ces solutions, aussi puissantes soient-elles, peuvent-elles réellement concurrencer les écosystèmes logiciels et les parts de marché déjà établies par les concurrents ?

« Les MI400 Series, par leur conception modulaire et leur optimisation pour des tâches spécifiques, éliminent la logique redondante des GPU polyvalents, réduisant ainsi la consommation d'énergie et les coûts, un facteur clé pour l'adoption massive de l'IA en périphérie. » — Analyse d'experts, Tom's Hardware, janvier 2026

L'élimination de la logique redondante n'est pas qu'une prouesse technique ; c'est une nécessité économique. Dans un contexte où chaque watt et chaque centime comptent, surtout pour les déploiements massifs à la périphérie, la capacité à fournir une performance ciblée avec une efficacité maximale est un avantage concurrentiel indéniable. C'est une vision pragmatique de l'IA, axée sur l'optimisation des ressources plutôt que sur la puissance brute à tout prix. Mais est-ce que les développeurs, habitués à la flexibilité des GPU, s'adapteront à cette nouvelle ère de spécialisation matérielle ?

Au-delà des centres de données, AMD s'attaque également à la périphérie et au marché embarqué avec une détermination nouvelle. La série Ryzen AI Embedded P100/X100, basée sur l'architecture Zen 5, RDNA 3.5 et surtout la NPU XDNA 2, promet jusqu'à 50 TOPS d'IA par puce. Cela représente une performance IA 3 fois supérieure et un GPU 35% plus rapide pour le traitement vidéo 4K/8K en temps réel. Ces puces sont destinées aux marchés automobiles, industriels et autonomes, des secteurs où la fiabilité et l'efficacité à la périphérie sont primordiales. Imaginez des véhicules autonomes qui prennent des décisions en une fraction de seconde sans dépendre d'une connexion cloud, ou des usines où les robots de vision détectent les défauts avec une précision immédiate. C'est la promesse de cette nouvelle génération de silicium.

En parallèle, les processeurs Ryzen AI 400/PRO 400, également équipés de la NPU XDNA 2, délivrent 60 TOPS et ont commencé à être expédiés en janvier 2026. Ces puces sont au cœur des nouveaux PC Copilot+ et des appareils embarqués, marquant une décentralisation significative du calcul IA. L'IA ne réside plus uniquement dans le cloud ; elle est désormais intégrée directement dans nos appareils quotidiens. Ce mouvement est soutenu par un investissement d'AMD de 150 millions de dollars dans l'éducation à l'IA, démontrant une volonté de former la prochaine génération d'ingénieurs à ces nouvelles architectures. C'est une stratégie à long terme, reconnaissant que le matériel seul ne suffit pas sans un écosystème de développeurs compétents.

« L'ascension des ASIC et des chiplets, avec les premiers GPU à 2 nm de TSMC et les NPUs XDNA 2 atteignant jusqu'à 60 TOPS, accélère la décentralisation de l'IA, transformant les PC et les systèmes embarqués en véritables centres de décision autonomes. » — HWBusters, Analyse des tendances technologiques, janvier 2026

La question du prix reste en suspens, car AMD n'a pas divulgué de tarifs publics pour ses nouvelles gammes, ce qui rend difficile une comparaison directe avec les offres de NVIDIA. Cependant, l'accent mis sur l'efficacité et la modularité suggère une tentative de proposer des solutions plus rentables à long terme, en particulier pour les déploiements à grande échelle. L'architecture CDNA 5, utilisée dans les MI400, est conçue pour des sous-ensembles optimisés pour des tâches spécifiques, privilégiant l'efficacité à la puissance brute universelle. Cela contraste avec l'approche plus généraliste de NVIDIA, qui mise sur la flexibilité de ses architectures CUDA pour couvrir un large éventail d'applications. Chaque approche a ses mérites, mais le marché de l'IA est en pleine mutation, et la spécialisation pourrait bien être la clé du succès pour les prochaines années.

L'avenir, incarné par les MI500 Series prévus pour 2027, promet des performances IA 1 000 fois supérieures à celles du MI300X (lancé en 2023), grâce à l'architecture CDNA 6, au procédé 2 nm et à la mémoire HBM4E. C'est une feuille de route agressive, qui témoigne de la confiance d'AMD dans sa capacité à innover et à rivaliser. Mais la vitesse de développement dans le domaine de l'IA est telle qu'une promesse pour 2027 est une éternité. Les concurrents de NVIDIA ne sont pas les seuls à innover. La véritable question est de savoir si AMD pourra maintenir ce rythme effréné d'innovation et convertir ces avancées techniques en parts de marché tangibles, ou si, comme d'autres avant elle, elle se heurtera aux murs d'un écosystème déjà solidement établi. L'histoire des semi-conducteurs est pleine de promesses non tenues. L'IA en périphérie, avec ses exigences uniques, pourrait bien être le terrain de jeu où cette nouvelle bataille se jouera.

La montée des ASIC et des puces modulaires pour l'IA en périphérie ne se résume pas à une simple bataille pour les parts de marché entre AMD et NVIDIA. C'est un changement tectonique dans la philosophie même du calcul. Pendant des décennies, l'industrie a poursuivi un objectif unique : créer des processeurs universels, plus rapides, plus polyvalents, capables de tout exécuter. L'ère de l'IA, et particulièrement son déploiement massif à la périphérie du réseau, a brisé ce paradigme. L'efficacité, la latence, la consommation énergétique et le coût total de possession sont devenus les véritables métriques de succès, reléguant la puissance brute universelle au second plan.

Cela redéfinit la chaîne de valeur. Les fournisseurs de cloud, autrefois simples acheteurs de matériel, deviennent des concepteurs de silicium. Les fabricants d'appareils, des voitures aux capteurs industriels, peuvent désormais intégrer une intelligence de pointe spécifiquement adaptée à leur besoin, plutôt que de se contenter d'un composant générique. Cette spécialisation crée une nouvelle couche dans l'écosystème technologique : un marché de composants d'IA modulaires et interopérables, où la valeur réside dans l'optimisation extrême pour une tâche donnée. La plateforme Helios d'AMD, avec ses 3 exaFLOPS par rack, n'est pas seulement un produit ; c'est le symbole de cette nouvelle ère où l'infrastructure de calcul est conçue de bout en bout pour une charge de travail unique.

« La migration vers des ASIC et des architectures modulaires représente la plus grande révolution dans la conception des semi-conducteurs depuis l'invention du microprocesseur. Nous ne construisons plus des machines à calculer généralistes, mais des systèmes de perception et de décision spécialisés, intégrés dans le tissu même de notre environnement physique. » — Analyse industrielleL'impact culturel est subtil mais profond. L'IA cesse d'être une entité abstraite, « dans le cloud », pour devenir une fonctionnalité tangible et locale de nos objets. Une caméra de sécurité qui analyse les visages sans envoyer de flux vidéo sur Internet, un tracteur qui optimise sa trajectoire en temps réel sans connexion satellite : ces scénarios impliquent un transfert de souveraineté. Le contrôle et la confidentialité des données se déplacent vers le point de collecte. Les puces Ryzen AI Embedded, avec leurs 50 TOPS intégrés, sont les pierres angulaires de ce monde décentralisé. La promesse d'AMD d'investir 150 millions de dollars dans l'éducation à l'IA est un aveu de cette transformation : l'avenir n'appartiendra pas seulement à ceux qui possèdent les meilleures usines de silicium, mais à ceux qui sauront penser et concevoir pour cette nouvelle réalité distribuée.

Les fissures dans l'armure : les défis de la spécialisation

Pourtant, cette révolution n'est pas sans écueils. La spécialisation extrême crée une fragmentation du marché et un risque d'obsolescence accélérée. Un ASIC optimisé pour un modèle de vision par ordinateur de 2026 pourrait devenir inutile face à une nouvelle architecture de réseau neuronal émergente en 2027. La flexibilité des GPU, souvent critiquée pour son inefficacité, est aussi sa plus grande force : elle permet l'expérimentation et l'évolution rapide des algorithmes. En verrouillant le matériel sur des tâches spécifiques, on risque de brider l'innovation logicielle.

La complexité de l'intégration des puces modulaires est un autre point faible. L'assemblage de multiples chiplets provenant de différents fournisseurs, bien que facilité par des standards ouverts, introduit de nouveaux points de défaillance potentiels – problèmes d'interopérabilité, de gestion thermique hétérogène, de latence de communication entre dies. Les performances théoriques du MI455X sont spectaculaires, mais sa dépendance à une infrastructure de refroidissement et d'alimentation de pointe le rend inaccessible à la grande majorité des entreprises, renforçant paradoxalement la concentration du pouvoir de calcul entre les mains des hyperscalers capables de se payer de telles installations.

Enfin, la guerre des brevets et la course aux nœuds de gravure les plus fins, comme le 2 nm, créent une barrière à l'entrée quasi infranchissable pour les nouveaux acteurs. L'annonce des MI500 Series pour 2027, promettant une augmentation de performance de 1 000x, illustre cette course effrénée qui consomme des capitaux colossaux. Cette dynamique pourrait étouffer l'innovation de niche et conduire à une situation où seuls deux ou trois géants contrôlent l'ensemble de la pile technologique, de la fonderie au logiciel d'optimisation, reproduisant sous une nouvelle forme la domination que l'on prétendait combattre.

Alors, que verrons-nous dans les prochains mois ? Les regards se tourneront vers les salons professionnels de la seconde moitié de 2026, où les premiers benchmarks indépendants des systèmes Helios et des accélérateurs MI400 Series seront scrutés à la loupe. La réponse du marché à la plateforme MI440X à 8 GPU pour les déploiements sur site sera un indicateur crucial de la demande réelle pour l'IA décentralisée en entreprise. Du côté de la périphérie, l'adoption massive des processeurs Ryzen AI 400 dans les PC et les systèmes embarqués à partir de ce second semestre 2026 nous dira si les consommateurs et les industriels sont prêts à faire confiance à une intelligence véritablement locale.

La feuille de route est tracée, mais elle est semée d'embûches. Les promesses de janvier 2026 devront être tenues dans les data centers et les usines du monde réel. La bataille ne se jouera pas seulement sur le papier blanc des fiches techniques, mais dans la chaleur étouffante des salles serveurs et dans la frugalité énergétique des capteurs autonomes. L'ère du silicium spécialisé a commencé, portée par la nécessité impérieuse de rendre l'intelligence artificielle non seulement plus puissante, mais plus discrète, plus efficiente, et finalement, plus intégrée à la matière même de notre monde. Le GPU généraliste n'est pas mort, mais il voit désormais son territoire rogné, mètre par mètre, par une armée de spécialistes ultra-efficaces. La question qui demeure, alors que les premiers racks Helios s'allument quelque part dans le monde, est de savoir si cette nouvelle efficacité nous conduira vers un écosystème plus ouvert et diversifié, ou si elle ne fera que forger des chaînes plus solides et plus spécialisées.

Your personal space to curate, organize, and share knowledge with the world.

Discover and contribute to detailed historical accounts and cultural stories. Share your knowledge and engage with enthusiasts worldwide.

Connect with others who share your interests. Create and participate in themed boards about any topic you have in mind.

Contribute your knowledge and insights. Create engaging content and participate in meaningful discussions across multiple languages.

Already have an account? Sign in here

La Corée du Sud parie 500 millions sur FuriosaAI pour défier Nvidia avec sa puce Renegade, 40% plus économe en énergie p...

View Board

TSMC domine le marché des puces IA avec des revenus records de 3 809 milliards de dollars taïwanais en 2025, mais sa dép...

View Board

Découvrez comment les PC IA, équipés de NPU dédiés, transforment nos ordinateurs en partenaires intelligents, redéfiniss...

View Board

Deepgram lève 130 M$ en Série C pour dominer l'IA vocale mondiale, étend Nova-3 à 10 langues et acquiert OfOne.

View Board

Google LiteRT révolutionne l'IA embarquée en permettant l'exécution de modèles sur microcontrôleurs avec seulement 16 Ko...

View Board

AMD lance Helios, un rack IA de 3 exaflops, défiant Nvidia avec 72 GPU MI455X et un partenariat clé avec OpenAI.

View Board

Le TinyML révolutionne l'électronique en intégrant une IA ultra-frugale dans les objets du quotidien, transformant therm...

View Board

Spot, le robot quadrupède de Boston Dynamics, redéfinit les interventions à risque en devenant un partenaire opérationne...

View Board

L'écran et l'âme : le dilemme numérique de la santé mentale Mars 2024. Dans un cabinet parisien, une patiente décrit à ...

View Board

Meta mise 2 milliards de dollars sur Manus, une startup d'IA rentable, pour dominer le marché des agents intelligents et...

View Board

La chute d'iRobot : comment le pionnier américain des robots domestiques, symbole d'innovation, a succombé sous les tari...

View Board

Découvrez Walter Brattain, co-inventeur du transistor et pionnier de l'ère des semi-conducteurs. Explorez sa vie, son tr...

View Board

Découvrez comment les lunettes IA génératives deviennent des assistants mains libres discrets, traduisant en temps réel,...

View Board

Découvrez TRON (TRX), une blockchain haute performance pour DApps, DeFi, et plus encore. Explorez ses avantages, son jet...

View Board

Découvrez comment l'IA devient un collègue de travail en 2026, transformant les usines, les bureaux et les vignobles ave...

View Board

L'IA en 2026 : révolution silencieuse ou tournant critique ? Le 12 mars 2024, un agent d’intelligence artificielle a, d...

View Board

En 2026, les nouvelles lois tech en Californie et au Texas entrent en conflit avec un ordre fédéral, créant une bataille...

View Board

L'IA révolutionne la découverte de médicaments, compressant des années de recherche en mois, réduisant les coûts et ouvr...

View Board

Vor 50 Jahren gründeten zwei Studienabbrecher in einer Garage ein Unternehmen, das die Welt veränderte – die Geschichte ...

View Board

Bis 2026 werden 80% der Unternehmen Physical AI nutzen – autonome Systeme, die nicht nur denken, sondern in Lagerhallen,...

View Board

Comments