Explore Any Narratives

Discover and contribute to detailed historical accounts and cultural stories. Share your knowledge and engage with enthusiasts worldwide.

Imaginez un réveil qui comprend non seulement votre cycle de sommeil, mais aussi votre toux nocturne. Un thermostat qui sent l’humidité avant que la moisissure n’apparaisse. Une brosse à dents qui détecte une inflammation gingivale. Cette intelligence discrète, omniprésente et privée n’est plus de la science-fiction. Elle a un nom : TinyML. Et elle est en train de bouleverser silencieusement notre rapport à la technologie, en injectant une dose d’artificialité intelligente dans les objets les plus banals.

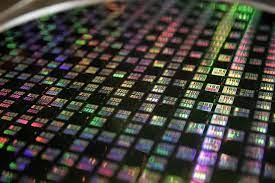

Le défi était colossal. Comment faire tenir la puissance de calcul nécessaire à l’intelligence artificielle dans des appareils fonctionnant sur une pile bouton pendant des années ? La réponse est venue d’une approche radicale : au lieu de faire remonter les données vers le nuage, c’est l’IA elle-même qui se miniaturise pour vivre directement sur la puce électronique. Un véritable tour de force d’ingénierie et de design logiciel.

Le cœur du sujet tient en un chiffre : moins d’un milliwatt. C’est la consommation électrique typique des systèmes TinyML. Pour donner un ordre d’idée, une ampoule LED classique consomme environ 10 000 fois plus. Cette frugalité extrême n’est pas un détail technique, c’est la condition sine qua non pour une nouvelle forme d’expérience utilisateur. Elle permet l’autonomie, la discrétion et une diffusion à l’échelle planétaire de capteurs intelligents.

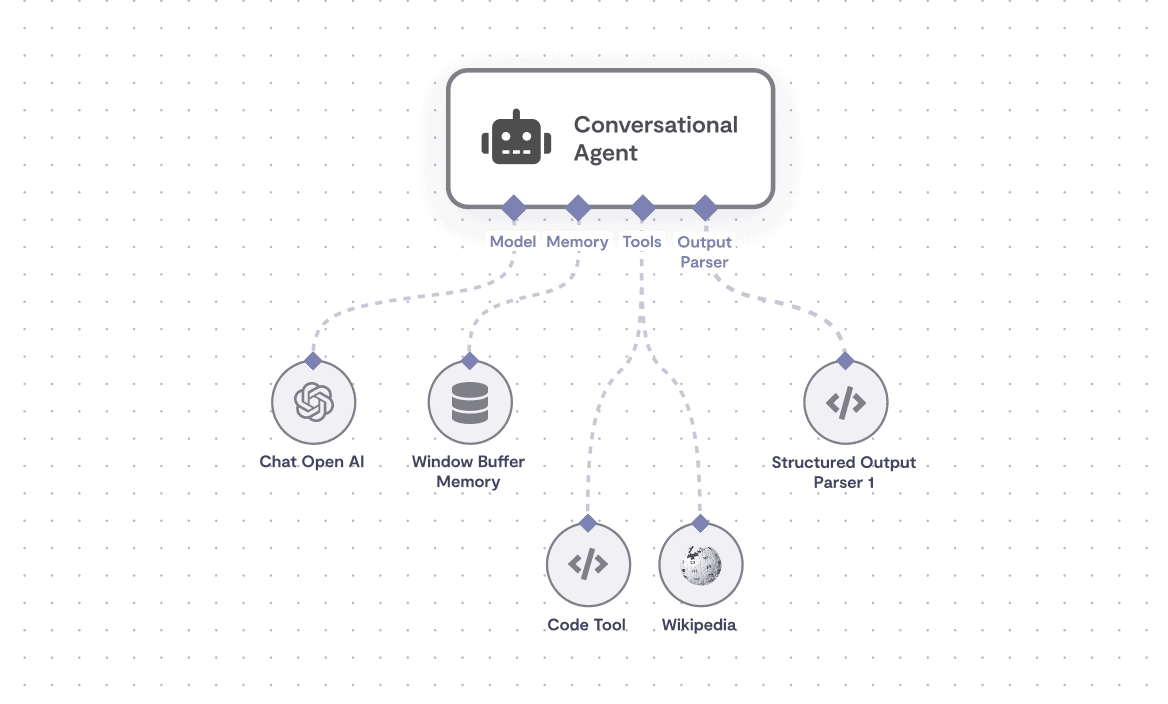

Le TinyML opère sur des microcontrôleurs, les cerveaux électroniques rudimentaires que l’on trouve dans tout, des télécommandes aux machines à café. Des puces avec une mémoire flash inférieure à 1 mégaoctet et une fréquence d’horloge modeste. Y faire tourner un modèle d’apprentissage automatique relève du paradoxe. L’astuce ? Un processus en deux temps. L’entraînement, gourmand en ressources, a lieu sur des serveurs puissants. Puis le modèle est comprimé, élagué, quantifié – un régime draconien – jusqu’à atteindre une taille minuscule pour être gravé dans la mémoire du microcontrôleur. L’appareil ne apprend plus, il applique en permanence ce qu’il a appris. C’est l’inférence à l’état pur.

Selon les définitions académiques du domaine, le TinyML est "un champ en pleine croissance de technologies et d'applications de machine learning incluant le matériel, les algorithmes et les logiciels capables d'effectuer l'analyse de données de capteurs sur l'appareil lui-même avec une consommation d'énergie extrêmement faible, typiquement dans la gamme du milliwatt et en-dessous."

Cette contrainte technique forge son esthétique propre. L’IA n’est plus un service distant, une boîte noire consultée via une connexion internet. Elle devient une caractéristique intrinsèque de l’objet, comme sa couleur ou son poids. La latence tombe à quelques millisecondes. La confidentialité des données est préservée, car rien ne quitte l’appareil. Pour le grand public, cela se traduit par une magie nouvelle : des objets qui semblent dotés d’un instinct primitif, réagissant à leur environnement de manière pertinente, immédiate et sans jamais nécessiter de recharge.

L’industrie du divertissement et du bien-être a été la première à saisir le potentiel narratif et expérientiel du TinyML. Les montres connectées et les bracelets fitness en sont les ambassadeurs les plus visibles. Ils ne se contentent plus de compter vos pas. Un algorithme TinyML, fonctionnant en permanence sur la puce dédiée du wearable, analyse en temps réel les signaux électriques de votre cœur.

Il recherche des motifs subtils, des irrégularités spécifiques comme la fibrillation atriale. L’alerte est instantanée, locale, et votre électrocardiogramme personnel ne quitte jamais votre poignet. C’est une révolution dans la narration de la santé personnelle : l’appareil passe du statut de compteur à celui de garde du corps vigilant.

Dans la maison, le changement est tout aussi palpable. Les caméras de vidéosurveillance et les sonnettes intelligentes équipées de TinyML peuvent désormais distinguer un humain d’un animal, ou reconnaître un visage familier, sans envoyer le flux vidéo vers un serveur Amazon ou Google. Le traitement a lieu dans le boîtier. Pour l’utilisateur, le bénéfice est double : une réponse plus rapide ("Ding dong, c’est le livreur !") et un sentiment retrouvé de contrôle sur sa vie privée. L’intelligence est logée dans le dispositif, pas dans le cloud.

Un rapport sectoriel de Tredence souligne que "le TinyML comble un manque critique dans le déploiement de l'IA en la rendant praticable dans des environnements où le traitement cloud n'est pas viable". L'impact culturel est profond : il démocratise l'IA en la rendant locale, abordable et indépendante des infrastructures réseau.

Et que dire des écouteurs sans fil ? Les modèles haut de gamme utilisent désormais le TinyML pour un ajustement actif du bruit annulé. Le microcontrôleur analyse le son ambiant et génère une onde antagoniste en quelques microsecondes. Une performance audio qui serait impossible avec la latence d’un aller-retour vers le cloud. L’expérience artistique – écouter un album dans une bulle de silence – est directement sculptée par cette intelligence embarquée.

Ces applications ne sont que les prémices. La véritable histoire que raconte le TinyML est celle d’une fusion entre le monde numérique et le monde physique. L’IA quitte les écrans pour habiter les murs, les vêtements, les outils. Elle devient environnementale. Cette discrétion même pose question : jusqu’où voulons-nous que l’intelligence, même minuscule, s’immisce dans le tissu de notre quotidien ? La suite de cette enquête, dans notre prochaine partie, explorera les coulisses de cette révolution, ses artisans méconnus et les ombres portées par cette promesse d’intelligence omniprésente.

Derrière la magie apparente du TinyML se cache un travail de bénédictin, un mélange d'ingénierie de précision et de renoncements créatifs. L'enjeu n'est pas d'ajouter de la puissance, mais de la soustraire. L'objectif : faire tenir un éléphant dans une boîte d'allumettes sans que l'éléphant ne semble étouffer. Cette quête de l'essentiel définit l'esthétique et les limites de tout le domaine.

Prenez la quantification. Cette technique, reine de l'optimisation TinyML, est un pari artistique sur la perception. Elle réduit la précision numérique des modèles, passant par exemple de calculs en virgule flottante 32 bits à des entiers 8 bits. C'est l'équivalent numérique de réduire une palette de 16 millions de couleurs à 256 teintes pour peindre un portrait. Le résultat peut être fidèle, mais la texture change. Les ingénieurs jouent avec cette marge.

"La réduction de la précision numérique rend les modèles beaucoup plus légers. Cette technique diminue significativement l'utilisation mémoire et la charge computationnelle tout en maintenant une performance proche de l'original." — Analyse technique MoogleLabs, spécialiste en systèmes embarqués

L'écosystème matériel, lui, explose de manière chaotique. Aux microcontrôleurs classiques s'ajoutent des circuits intégrés spécialisés (ASIC) et des accélérateurs dédiés. La plateforme SiWx917 de Silicon Labs, présentée lors de ses Tech Talks sur les technologies sans fil en 2025, intègre directement un accélérateur IA/ML. C'est le signe d'une maturation : le TinyML n'est plus une fonction greffée, mais une caractéristique architecturale native. Le matériel et le logiciel co-évoluent pour servir cette intelligence minimaliste.

Cette course à la frugalité pose une question fondamentale aux développeurs : jusqu'où simplifier sans trahir ? Les modèles privilégiés, comme les réseaux de neurones convolutifs (CNN) pour la vision ou les LSTM pour les séquences temporelles, doivent être radicalement réinventés pour ce nouveau milieu. On ne transpose pas, on réécrit. Chaque neurone, chaque connexion est pesée, jugée, éventuellement sacrifiée sur l'autel du kilooctet de mémoire flash.

Le processus crée une tension créative fascinante. D'un côté, la recherche académique, symbolisée par des publications comme celles de l'ACM Digital Library, continue de pousser les limites de ce qui est possible sur du matériel contraint. De l'autre, l'industrie exige des solutions stables, reproductibles à des millions d'exemplaires pour quelques dollars par unité. Le TinyML est à la croisée de ces deux mondes, un terrain d'expérimentation où la beauté mathématique doit impérativement se traduire en efficacité économique.

Mais cet impératif de légèreté a un coût culturel. La diversité des modèles d'IA se réduit. Les architectures les plus élégantes mais gourmandes sont écartées. Le paysage algorithmique risque de s'uniformiser autour de quelques champions, ceux qui passent le mieux l'épreuve de la miniaturisation. Quelle place reste-t-il pour l'expérimentation hasardeuse, pour le modèle inefficace mais génial, dans un monde où chaque octet compte ?

Alors que les grands modèles linguistiques font la une des journaux, le TinyML opère sa conquête en silence, secteur par secteur. Son récit n'est pas celui d'un big bang médiatique, mais d'une infiltration systématique. Chaque domaine d'application écrit un chapitre différent de la même histoire : celle de l'autonomie retrouvée.

Dans l'agriculture de précision, des capteurs enterrés analysent l'humidité du sol et la salinité. Un modèle TinyML identifie les zones de stress hydrique et commande localement l'irrigation goutte-à-goutte. Aucune latence réseau, aucun aller-retour vers le cloud. La décision est prise sur place, par la terre, pour la terre. L'autonomie énergétique est telle que ces sentinelles silencieuses peuvent veiller pendant une saison entière sur une simple pile. L'agriculteur ne gère plus des données, il délègue à un réseau neuronal distribué dans son champ.

"Les appareils IoT embarquant TinyML sur leurs microcontrôleurs nécessitent moins d'accès aux services cloud, réduisant les coûts énergétiques et les dépenses, tout en augmentant la sécurité et la confidentialité des données." — Étude ACM sur les systèmes de machine learning

Le secteur industriel est transformé par la détection d'anomalies embarquée. Une pompe vibrante sur une chaîne de production intègre un accélérateur TinyML. Elle apprend son propre bruit de fond, la symphonie de son fonctionnement normal. Dès qu'une note dissonante apparaît – une fréquence anormale précurseur d'une panne – elle alerte, sans avoir à streamer en continu des téraoctets de données vibratoires vers un centre de contrôle. La maintenance devient prédictive et locale. L'objet acquiert une forme de conscience de soi mécanique.

La santé portable vit sa seconde révolution. Après le comptage de pas, voici le diagnostic continu. Des patchs cutanés surveillent l'électrocardiogramme en cherchant des motifs subtils de fibrillation atriale. L'analyse a lieu sur le patch. Seule une alerte, un résumé épuré, peut éventuellement être transmis. Le corps reste le souverain de ses données biométriques. Cette intimate technologique change le rapport au soin : le patient n'est plus un sujet passif dont les données sont siphonnées, mais le propriétaire d'un système de veille personnelle.

"Les modèles TinyML peuvent fonctionner pendant des mois sur une pile bouton. Cette capacité transforme les applications en agriculture, logistique, surveillance à distance et réseaux de capteurs distribués." — Expertise MoogleLabs

Pourtant, cette dispersion même est une faiblesse. Le TinyML manque d'un récit fédérateur, d'une application "killer" grand public aussi évidente que le smartphone l'a été pour l'internet mobile. Ses succès sont nichés, spécialisés, presque invisibles. Est-ce le signe d'une technologie véritablement mature, qui se fond dans le décor, ou d'une niche qui peine à trouver sa dimension culturelle ?

L'enthousiasme pour cette démocratisation de l'IA ne doit pas occulter les zones d'ombre critiques. Le TinyML, par sa nature même, soulève des questions épineuses sur la transparence, la responsabilité et l'impact environnemental à grande échelle.

Premier point noir : l'opacité des décisions. Quand un modèle de plusieurs centaines de kilooctets, quantifié et comprimé, décide qu'un battement de cœur est irrégulier ou qu'une vibration de machine est anormale, qui peut expliquer son raisonnement ? Les techniques d'IA explicable (XAI) sont encore plus difficiles à implémenter sur ces plateformes contraintes. Nous construisons un monde peuplé de millions de juges minuscules et inscrutables. Le risque est celui d'une autorité algorithmique distribuée et non contestable.

Ensuite, la question de la maintenance logicielle. Un réseau de 50 000 capteurs agricoles embarquant un modèle TinyML est déployé. Deux ans plus tard, une faille de classification est découverte, ou une meilleure version du modèle est disponible. Comment mettre à jour ce parc ? La logistique de la mise à jour Over-The-Air (OTA) de microprogrammes sur des appareils à très faible consommation, parfois endormis la plupart du temps, est un cauchemar d'ingénierie. Nous risquons de créer une planète rouillée d'intelligences obsolètes, figées dans leur version initiale.

"Avec l'avancée des appareils IoT, mobiles et portables, la nécessité de compresser et optimiser ces réseaux pour les rendre compatibles avec du matériel contraint aux ressources limitées s'est imposée." — Recherche ACM sur l'évolution des réseaux de neurones

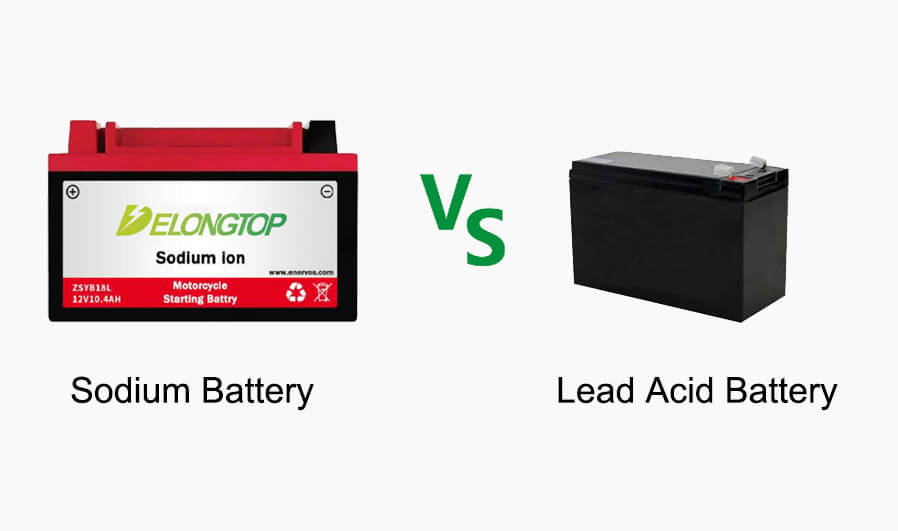

Enfin, le mirage de l'écologie. Un dispositif TinyML individuel est vertueux : moins d'un milliwatt. Mais le modèle économique repose sur la diffusion de milliards d'unités. L'impact environnemental de la fabrication, de la distribution et, ultimement, du recyclage de ces milliards de puces et de leurs batteries bouton est colossal. La frugalité à l'usage masque-t-elle une voracité à l'échelle ? Le récit de l'efficacité doit être confronté à la dure loi des nombres absolus.

Le plus grand défi culturel reste celui de la perception. Le TinyML est l'anti-GPT. Il n'est pas loquace, il est silencieux. Il ne génère pas de contenu, il prend des micro-décisions. Il est utilitaire, pas conversationnel. Dans une époque fascinée par les IA génératives spectaculaires, sa valeur subtile et infrastructurelle peine à capturer l'imagination du grand public. Sa réussite se mesurera peut-être à sa capacité à rester invisible, à ce que nous oublions totalement qu'il est là. Mais peut-on célébrer une révolution que personne ne voit ?

La véritable signification du TinyML dépasse largement la prouesse technique. Elle signe un changement de paradigme dans notre rapport à l’intelligence artificielle. Après une décennie de centralisation massive dans les data centers des géants technologiques, l’IA se diffuse, s’atomise, reprend une dimension locale. Ce n’est pas un simple transfert de calcul, c’est un retour de la souveraineté décisionnelle vers la périphérie, vers l’objet, vers l’individu. Culturellement, cela contredit la narration dominante d’une IA omnipotente et lointaine. Le pouvoir de décision, même modeste, est restitué à l’objet du quotidien.

L’impact historique du TinyML pourrait se révéler comparable à celui du microprocesseur dans les années 1970. Le microprocesseur a démocratisé le calcul, le TinyML démocratise le jugement contextuel. Il transforme l’internet des objets, souvent critiqué pour sa passivité de collecteur de données, en un réseau de neurones distribués. Chaque capteur devient un nœud non seulement de perception, mais d’interprétation. La conséquence est une architecture informatique radicalement différente, moins pyramidale, plus résiliente, et intrinsèquement plus privée. Son héritage ne sera pas un produit phare, mais un principe de design : l’intelligence comme fonction native, frugale et discrète.

"Le TinyML comble un manque critique dans le déploiement de l'IA en la rendant praticable dans des environnements où le traitement cloud n'est pas viable." — Analyse sectorielle Tredence

Dans l’industrie du divertissement, cette influence est déjà palpable. Les accessoires de jeu vidéo, les casques de réalité virtuelle, les systèmes de son spatialisé intègrent des puces TinyML pour l’adaptation haptique ou audio en temps réel. L’immersion artistique gagne en réactivité biologique, répondant aux micro-mouvements du joueur ou de l’auditeur. L’expérience culturelle n’est plus seulement consommée, elle est co-créée par des réactions algorithmiques embarquées, faisant de l’utilisateur un interprète actif sans même qu’il en ait conscience.

Pourtant, il serait irresponsable de céder à un angélisme technologique. Le TinyML porte en lui les germes de nouvelles problématiques, peut-être plus insidieuses que celles des grands modèles centralisés. La première faille est démocratique. La miniaturisation et la diffusion massive rendent la régulation et l’audit quasiment impossibles. Qui supervise les décisions prises par le thermostat, la brosse à dents, le capteur de pollution de quartier ? Une norme de construction biaisée, gravée dans le silicium de millions d’appareils, devient un fait établi, une vérité infrastructurelle inattaquable.

La deuxième faiblesse est écologique, et elle est contraire au récit marketing. Si un dispositif consomme un milliwatt, un milliard de dispositifs consomment un mégawatt. L’économie à l’échelle unitaire est anéantie par la multiplication. L’empreinte carbone de la production de milliards de microcontrôleurs supplémentaires, de leurs batteries, de leur collecte en fin de vie, pourrait annuler tous les bénéfices de leur faible consommation. Nous risquons de créer une pollution matérielle massive au nom de l’efficacité énergétique.

Enfin, il y a un risque d’appauvrissement algorithmique. La tyrannie de la contrainte extrême – mémoire, calcul, énergie – pourrait standardiser l’intelligence embarquée autour de quelques modèles éprouvés, étouffant l’innovation exploratoire. La diversité des approches en intelligence artificielle, source de sa richesse, se heurte au mur impitoyable du kilooctet. Le futur de l’IA à la périphérie pourrait être étonnamment uniforme.

L’évolution ne sera pas spéculative. Elle est déjà tracée dans les feuilles de route des fabricants de semi-conducteurs. La conférence TinyML Summit de mars 2025 à San José a placé l’accent sur les frameworks de développement unifiés, une réponse directe à la fragmentation actuelle du domaine. L’objectif est de passer du bricolage d’expert à un processus industriel reproductible. Parallèlement, le déploiement de la norme de communication sans fil Matter 1.3 prévu pour le second semestre 2025 intégrera nativement des profils pour les calculs TinyML, permettant à des appareils domestiques de différentes marques de partager non seulement des données, mais des conclusions intelligentes, localement.

Les prochaines batailles ne se livreront pas sur la taille des modèles, mais sur leur agilité. La recherche, comme celle menée au MIT publiée en février 2025, explore le « micro-learning » incrémental, permettant à un dispositif de raffiner localement son modèle à partir de nouvelles données, sans repartir de zéro. Cela briserait le dogme de l’appareil statique. L’objet pourrait discrètement s’adapter à son utilisateur, à son environnement, évoluant dans les limites étroites de ses ressources. Votre montre ne se contenterait plus de détecter une arythmie générique ; elle apprendrait la signature unique de votre propre cœur.

Le test ultime aura lieu dans les villes. Les projets de « smart cities » de seconde génération, comme celui annoncé par la métropole de Lyon pour un déploiement pilote à l’été 2025, reposent sur des capteurs TinyML autonomes pour la gestion du trafic, l’éclairage adaptatif et la mesure de la qualité de l’air. Leur promesse : une intelligence urbaine qui ne dépend pas d’un flux constant vers un data center municipal, une ville capable de réagir par réflexes locaux.

La vraie question n’est plus de savoir si le TinyML va envahir notre environnement. C’est déjà le cas. La question est de savoir si nous saurons percevoir, et ensuite guider, cette myriade de petites lumières intelligentes qui s’allument dans l’ombre de nos objets. Allons-nous construire un écosystème résilient et transparent, ou une forêt impénétrable de boîtes noires minuscules ? La réponse se joue maintenant, dans le silence des laboratoires et le choix des architectures, bien avant que cette intelligence diffuse ne devienne le bruit de fond inévitable de notre monde.

Your personal space to curate, organize, and share knowledge with the world.

Discover and contribute to detailed historical accounts and cultural stories. Share your knowledge and engage with enthusiasts worldwide.

Connect with others who share your interests. Create and participate in themed boards about any topic you have in mind.

Contribute your knowledge and insights. Create engaging content and participate in meaningful discussions across multiple languages.

Already have an account? Sign in here

Google LiteRT révolutionne l'IA embarquée en permettant l'exécution de modèles sur microcontrôleurs avec seulement 16 Ko...

View Board

Spot, le robot quadrupède de Boston Dynamics, redéfinit les interventions à risque en devenant un partenaire opérationne...

View Board

La Corée du Sud parie 500 millions sur FuriosaAI pour défier Nvidia avec sa puce Renegade, 40% plus économe en énergie p...

View Board

Deepgram lève 130 M$ en Série C pour dominer l'IA vocale mondiale, étend Nova-3 à 10 langues et acquiert OfOne.

View Board

L'ère du silicium spécialisé s'ouvre avec l'ascension des ASIC et des puces modulaires, défiant l'hégémonie des GPU et r...

View Board

Découvrez comment l'IA devient un collègue de travail en 2026, transformant les usines, les bureaux et les vignobles ave...

View Board

TSMC domine le marché des puces IA avec des revenus records de 3 809 milliards de dollars taïwanais en 2025, mais sa dép...

View Board

L'écran et l'âme : le dilemme numérique de la santé mentale Mars 2024. Dans un cabinet parisien, une patiente décrit à ...

View Board

Découvrez comment les PC IA, équipés de NPU dédiés, transforment nos ordinateurs en partenaires intelligents, redéfiniss...

View Board

L'IA en 2026 : révolution silencieuse ou tournant critique ? Le 12 mars 2024, un agent d’intelligence artificielle a, d...

View Board

Meta mise 2 milliards de dollars sur Manus, une startup d'IA rentable, pour dominer le marché des agents intelligents et...

View Board

Découvrez comment les lunettes IA génératives deviennent des assistants mains libres discrets, traduisant en temps réel,...

View Board

KI-Wearables 2026 revolutionieren die Medizin: Präzisionsdiagnostik in Echtzeit, Edge-AI analysiert Vitaldaten direkt am...

View Board

Edge AI revolutioniert Geräte durch lokale KI-Verarbeitung – schneller, datenschutzfreundlich und energieeffizient, mit ...

View Board

AMD lance Helios, un rack IA de 3 exaflops, défiant Nvidia avec 72 GPU MI455X et un partenariat clé avec OpenAI.

View Board

L'IA révolutionne la découverte de médicaments, compressant des années de recherche en mois, réduisant les coûts et ouvr...

View Board

Découvrez TRON (TRX), une blockchain haute performance pour DApps, DeFi, et plus encore. Explorez ses avantages, son jet...

View Board

Les batteries sodium-ion, moins chères et plus écologiques, révolutionnent le stockage d'énergie dès 2025, avec CATL en ...

View Board

Des chercheurs dévoilent un transistor synaptique qui détecte le mouvement en 100 µs, ouvrant la voie à une vision IA to...

View Board

L'IA crée en quelques minutes des milliers de molécules ciblées, diminue de dix le délai pré‑clinique et valide rapideme...

View Board

Comments