Explore Any Narratives

Discover and contribute to detailed historical accounts and cultural stories. Share your knowledge and engage with enthusiasts worldwide.

La salle de presse est comble. Les lumières se tamisent. Sur scène, le PDG d’AMD, Lisa Su, affiche un sourire confiant. Derrière elle, un rendu 3D d’une tour métallique monstrueuse, un rack de data center bourré de circuits, tourne lentement. Helios. Ce nom, choisi comme celui du dieu grec du soleil, n’est pas un hasard. C’est une déclaration d’intention. « Nous croyons qu’Helios est le meilleur rack IA du monde », annonce-t-elle, sans ambages. La cible est claire, évidente, presque tangible : le système NVL72 de Nvidia et sa domination écrasante sur le marché des accélérateurs d’intelligence artificielle. Nous sommes en janvier 2026, au CES de Las Vegas, et la bataille pour le futur du calcul entre dans une nouvelle phase, radicale.

Il y a encore trois ans, parler d’AMD comme d’un sérieux concurrent de Nvidia en IA data center aurait provoqué des sourires polis dans les couloirs des hyperscalers. L’écart semblait infranchissable. Nvidia détenait non seulement les GPU les plus performants, mais aussi un écosystème logiciel, CUDA, verrouillé par des années de développement et d’adoption massive. Pourtant, les chiffres boursiers racontent une autre histoire : sur la seule année 2025, l’action AMD a grimpé de +70%, surperformant largement Nvidia. Cette ascension n’est pas le fruit du hasard, mais le résultat d’une offensive méthodique et d’une feuille de route devenue agressive.

L’annonce, fin 2025, d’un partenariat stratégique majeur avec OpenAI a servi de détonateur. OpenAI a non seulement commandé des quantités significatives de processeurs AMD, mais a aussi investi dans la société. Pour les observateurs, ce geste est bien plus qu’un simple contrat. C’est un vote de confiance, un signal fort envoyé à l’ensemble de l’industrie. Selon un analyste de Morgan Stanley, « cela crédibilise immédiatement AMD comme fournisseur alternatif stratégique. OpenAI ne peut pas se permettre de parier sur une technologie de second rang pour entraîner ses modèles de nouvelle génération. Leur engagement est une validation technique puissante. »

L'accord avec OpenAI change la donne. C'est la preuve qu'AMD n'est plus seulement une option de secours pour faire baisser les prix, mais un partenaire capable de supporter les charges de travail les plus exigeantes de la planète IA.

Le cœur de l’offensive 2026 d’AMD bat dans ce rack nommé Helios. Sa spécification est une déclaration de guerre technique. Il combine 72 GPU Instinct MI455X, la dernière évolution de la série MI400, avec les nouveaux CPU EPYC « Venice » et des cartes réseau Pensando Vulcan. La promesse : 3 AI exaflops par rack. Ce chiffre n’est pas choisi au hasard. Il « match » précisément la capacité annoncée pour le système NVL72 de Nvidia, basé sur la future architecture Rubin. Le message est limpide : unité par unité, rack par rack, AMD propose désormais une alternative directe, performance pour performance.

La stratégie va au-delà du simple composant. En proposant Helios, AMD adopte la logique même de Nvidia : vendre non plus des GPU, mais des systèmes complets, optimisés de bout en bout, où le CPU, le GPU, la mémoire et l’interconnexion sont conçus pour travailler ensemble. Cette approche réduit la complexité pour les grands clients comme Microsoft, Meta ou Google, qui construisent des « usines à IA » à grande échelle. « Helios n'est pas seulement une collection de puces, c'est une plateforme de calcul intégrée conçue pour l'entraînement de modèles à milliers de milliards de paramètres », explique un ingénieur système présent au CES. « L'efficacité énergétique et la bande passante mémoire sont les clés, et c'est là qu'ils ont concentré leurs efforts. »

Nvidia a inventé le supercalculateur AI-en-boîte avec DGX. AMD, avec Helios, ne cherche pas à réinventer la roue, mais à en construire une meilleure, moins chère, et surtout ouverte. C'est un pari risqué, mais c'est le seul moyen de briser un quasi-monopole.

Alors que Nvidia double constamment sa mise sur le data center high-end, AMD déploie une stratégie différente, plus large. Baptisée « AI Everywhere », elle vise à placer des accélérateurs neuronaux dans chaque segment de marché : du PC portable aux consoles de jeu, en passant par le edge computing et, bien sûr, les serveurs géants. Au même CES 2026, AMD a ainsi lancé les Ryzen AI 400 Series, des processeurs pour PC intégrant un Neural Processing Unit (NPU) capable d'exécuter des modèles locaux. Ils promettent des gains de 1,7× en création de contenu par rapport aux générations précédentes.

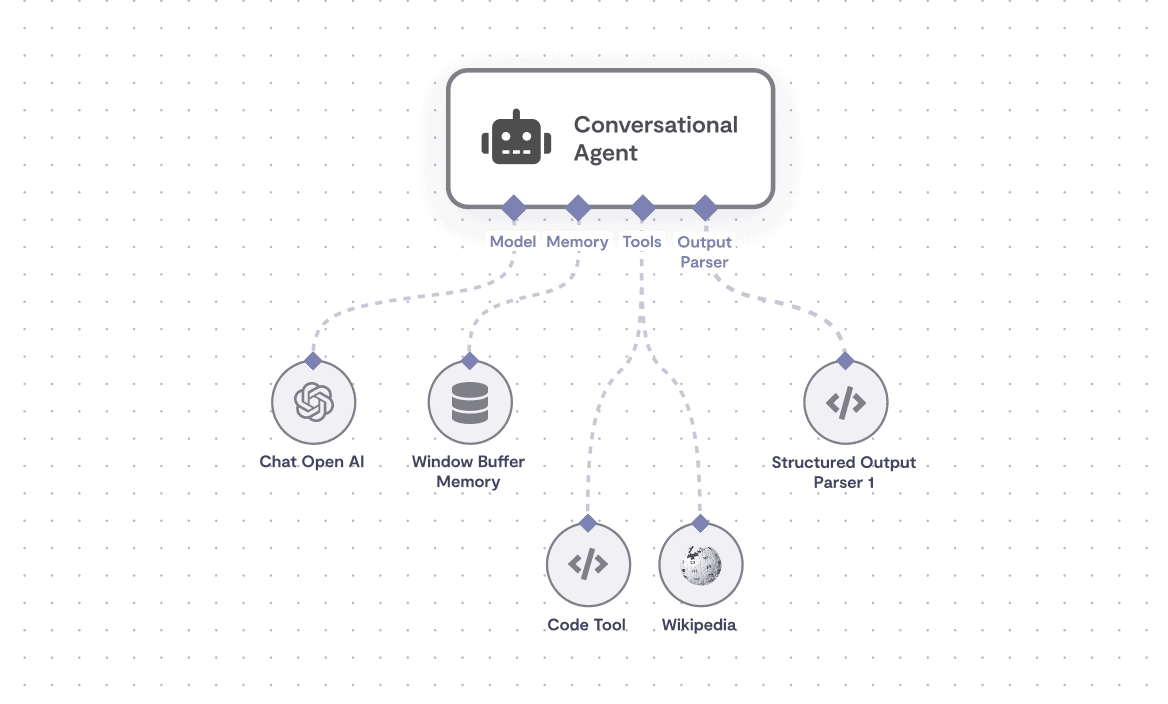

Cette approche présente un avantage subtil mais crucial : elle crée un écosystème. Un développeur habitué à utiliser les outils ROCm d’AMD sur son PC Ryzen pourrait être naturellement enclin à les utiliser également dans le cloud, sur des instances basées sur Instinct. C’est une tentative de construire, pierre par pierre, une alternative à l’hégémonie CUDA. L’argument n’est pas seulement la performance brute, mais aussi l’interopérabilité et la réduction des coûts de verrouillage.

La feuille de route produit, désormais rendue publique jusqu’en 2027, illustre cette ambition. Après la famille MI400 et Helios, AMD prévoit déjà la génération MI500, basée sur une architecture CDNA 6 gravée en 2 nanomètres et équipée de mémoire HBM4E. Les gains annoncés sont vertigineux : jusqu’à 1000× la performance IA de l’actuel MI300X pour certaines précisions réduites comme le FP4. Ces chiffres, s’ils se concrétisent, visent directement le leadership sur les charges de travail d’entraînement les plus lourdes, domaine où Nvidia règne sans partage aujourd’hui.

Pourtant, malgré ces annonces tonitruantes, le chemin reste semé d’embûches. La domination de Nvidia n’est pas seulement matérielle ; elle est logicielle, culturelle, presque institutionnelle. CUDA est le socle sur lequel repose des décennies de code de recherche et de déploiement industriel. Le runtime open source ROCm d’AMD a fait des progrès immenses, mais la bataille des développeurs est loin d’être gagnée. Chaque pourcentage de part de marché que va grignoter AMD devra être arraché par la force de la performance, du prix, et de la persuasion.

La scène est donc plantée pour un conflit d’une intensité rare dans le monde de la tech. D’un côté, un champion incontesté, Nvidia, qui répond à l’offensive avec sa plateforme Rubin et une cadence de renouvellement effrénée. De l’autre, un challenger agressif, AMD, qui mise sur une approche systémique et une ouverture affichée pour fracturer la forteresse. Les prochains trimestres ne seront pas jugés sur les communiqués de presse, mais sur les livraisons, les benchmarks indépendants, et les déploiements à grande échelle chez les géants du cloud. Le soleil d’Helios se lèvera-t-il sur l’ère d’un marché à deux joueurs ?

L'annonce d'Helios au CES 2026 n'était pas qu'une simple présentation de produit ; c'était une démonstration de force, une architecture pensée pour rivaliser, voire surpasser, ce que Nvidia prépare. AMD ne se contente plus de vendre des puces, l'entreprise propose désormais un système complet, optimisé pour les charges de travail IA les plus extrêmes. La directrice générale d'AMD, Lisa Su, n'a d'ailleurs pas mâché ses mots. Lors de la présentation, elle a affirmé :

Nous croyons qu’Helios est le meilleur rack IA du monde. — Lisa Su, PDG d'AMD, CES 2026

Cette déclaration, audacieuse, s'appuie sur des spécifications techniques vertigineuses. Chaque rack Helios intègre pas moins de 72 accélérateurs Instinct MI455X, l'architecture CDNA 5, et est couplé aux tout nouveaux CPU EPYC « Venice » basés sur l'architecture Zen 6. Le tout est interconnecté par des cartes réseau Pensando « Vulcano ». C'est une synergie de composants conçue pour offrir une performance brute inouïe. Le 6 janvier 2026, le communiqué de presse officiel d'AMD précisait d'ailleurs que « la plateforme rack-scale AMD “Helios” est le modèle d'infrastructure yotta-scale, délivrant jusqu'à 3 AI exaflops de performance dans un seul rack. Elle est conçue pour offrir une bande passante maximale et une efficacité énergétique pour l'entraînement de modèles à milliers de milliards de paramètres. »

Détaillons un instant ces chiffres. Un seul rack Helios atteint 2,9 exaFLOPS en FP4 dense pour l'inférence et 1,4 exaFLOPS en FP8 pour l'entraînement. Ce n'est pas anodin. Ces performances placent directement Helios dans la même ligue, et dans certains scénarios, le rendent plus rapide que les systèmes NVL72 Vera Rubin de Nvidia, comme l'a rapporté The Register le 7 janvier 2026. Pour un observateur attentif, cette parité technique est une véritable révolution. Pendant des années, Nvidia a joui d'une avance quasiment intouchable sur ces métriques.

La mémoire est un autre point fort. Helios embarque un total de 31 téraoctets de mémoire HBM4 par rack, avec une bande passante mémoire agrégée de 1,4 pétaoctets par seconde. Lisa Su a souligné l'importance de cette capacité et de cette vitesse lors de sa présentation au CES 2026, déclarant que les « GPU MI455 sont construits en utilisant des technologies de processus de pointe de 2 nm et 3 nm et un packaging avancé de chiplets 3D avec une mémoire HBM4 ultra-rapide et à large bande passante. » Cette densification de la mémoire et cette interconnexion ultra-rapide sont cruciales pour gérer les modèles d'IA toujours plus gourmands en données. Sans cela, même les cœurs de calcul les plus puissants seraient bridés.

Chaque rack Helios compte plus de 18 000 unités de calcul GPU CDNA 5 et plus de 4 600 cœurs CPU Zen 6, délivrant jusqu'à 2,9 exaflops de performance. Chaque rack inclut également 31 téraoctets de mémoire HBM4, une bande passante de montée en charge de 260 téraoctets par seconde leader de l'industrie, et 43 téraoctets par seconde de bande passante agrégée de mise à l'échelle. — Lisa Su, PDG d'AMD, CES 2026

Ces chiffres ne sont pas que des mots ; ils représentent la capacité brute de la plateforme à ingurgiter et traiter des quantités astronomiques de données, une nécessité absolue pour l'entraînement des modèles de langage massifs et des architectures d'apprentissage profond de demain. Tom's Hardware, le 6 janvier 2026, a d'ailleurs commenté que « Helios est la première solution système rack-scale d'AMD pour les déploiements de calcul haute performance basée sur le CPU EPYC 'Venice' Zen 6 d'AMD. Il contient 72 accélérateurs Instinct MI455X-series avec 31 To de mémoire HBM4 au total avec une bande passante mémoire agrégée de 1,4 PB/s. »

La performance d'Helios ne vient pas de nulle part. Elle est le fruit d'une ingénierie complexe et de choix technologiques audacieux. Les GPU MI455X sont les stars de cette plateforme. L'analyse de Chips and Cheese, également publiée le 6 janvier 2026, a révélé que le MI455X est un « package massif avec 12 dies HBM4 et "douze dies de calcul et d'E/S de 2 nanomètres et 3 nanomètres". » Cette utilisation intensive du packaging 3D et des nœuds de fabrication les plus avancés (2 nm et 3 nm) est la clé de la densité de calcul et de l'efficacité énergétique. C'est une prouesse technique qui montre qu'AMD ne craint pas d'investir massivement dans la R&D pour rattraper son retard.

L'intégration du CPU EPYC « Venice » est tout aussi cruciale. Avec la famille Zen 6, AMD vise jusqu'à 256 cœurs par puce, doublant la bande passante mémoire par rapport à la génération précédente (Turin). Cela signifie une capacité accrue à alimenter les GPU en données, réduisant ainsi les goulots d'étranglement qui peuvent freiner la performance globale d'un système. Le doublement des lignes PCIe 6.0 (environ 128 lignes) est également vital pour la communication entre CPU et GPU, et entre les GPU eux-mêmes. Sans un CPU à la hauteur, même les meilleurs accélérateurs IA ne peuvent pas exprimer tout leur potentiel. Est-ce que Nvidia, avec sa stratégie plus axée sur le GPU, n'a pas sous-estimé l'importance d'un CPU performant et intégré dans l'équation du calcul IA à l'échelle du rack ?

Nous avons réalisé la plus grande augmentation de performance générationnelle jamais atteinte. — Lisa Su, PDG d'AMD, CES 2026, parlant du saut générationnel MI400.

Cette déclaration de Lisa Su sur l'augmentation de performance des MI400 par rapport à leurs prédécesseurs est particulièrement révélatrice. Elle illustre la volonté d'AMD de ne pas seulement combler l'écart, mais de le faire à une vitesse fulgurante. La série MI500, prévue pour 2027, promet d'ailleurs jusqu'à 1 000 fois la performance IA du MI300X de 2023. Si ces objectifs sont atteints, cela représenterait un bond technologique sans précédent, capable de bouleverser l'équilibre actuel du marché. Le communiqué de presse d'AMD du 6 janvier 2026 confirme cette ambition, déclarant que « la série MI500 est en bonne voie pour délivrer jusqu'à une augmentation de 1 000x de la performance IA par rapport aux GPU AMD Instinct MI300X introduits en 2023. »

Malgré ces avancées matérielles impressionnantes, la véritable bataille pour AMD se jouera sur le terrain du logiciel et de l'écosystème. Nvidia a son CUDA, un environnement de développement mature et omniprésent, qui a créé un verrouillage technologique redoutable. AMD, de son côté, pousse ROCm, son environnement open source. L'entreprise mise sur l'ouverture et l'interopérabilité pour séduire les développeurs et les hyperscalers lassés de la dépendance à un seul fournisseur.

Le fait qu'AMD ait réussi à convaincre OpenAI d'adopter ses puces est un signe encourageant. Cela montre que des acteurs majeurs de l'IA sont prêts à investir dans des alternatives à Nvidia. Cependant, la migration d'un écosystème à un autre est coûteuse et complexe. Les ingénieurs doivent réécrire du code, adapter des bibliothèques, et se familiariser avec de nouveaux outils. Même avec le soutien d'acteurs de premier plan, le chemin est long. Les analystes de Zacks, tout en reconnaissant les progrès « envoûtants » d'AMD en IA, soulignent que l'entreprise reste « le second violon de Nvidia » en termes de leadership global et de momentum bénéficiaire. La performance matérielle est une chose, l'adoption généralisée et la construction d'une communauté de développeurs en est une autre, bien plus ardue. Sans une base logicielle solide et largement adoptée, même le « meilleur rack IA du monde » pourrait avoir du mal à s'imposer durablement.

Le duel AMD contre Nvidia dépasse largement le cadre d'une simple rivalité commerciale entre deux fabricants de semi-conducteurs. Il s'agit d'une bataille pour définir l'architecture fondamentale de l'intelligence artificielle pour la décennie à venir. D'un côté, le modèle intégré et verrouillé de Nvidia, où le GPU, le réseau, le logiciel et même le CPU (via les superchips comme Vera Rubin) sont conçus pour fonctionner ensemble de manière exclusive. De l'autre, la proposition plus ouverte et modulaire d'AMD, incarnée par Helios, qui assemble ses meilleurs composants (CPU EPYC, GPU Instinct, réseau Pensando) tout en prônant des standards ouverts comme ROCm. Cette confrontation façonne le paysage technologique dans lequel les géants du cloud, les startups et les chercheurs devront évoluer.

La victoire de l'un ou de l'autre modèle aura des conséquences concrètes sur le coût, l'accessibilité et le rythme de l'innovation en IA. Un marché à deux joueurs crédibles est une assurance contre la stagnation des prix et un moteur pour l'accélération technologique. Comme le soulignait un rapport de Morgan Stanley en janvier 2026, la réussite à long terme d'AMD obligera Nvidia à « innover encore plus vite ». Cette pression concurrentielle bénéficie in fine à l'ensemble de l'écosystème. L'engagement d'OpenAI auprès d'AMD n'est pas seulement un achat de puces ; c'est un acte stratégique pour préserver une certaine marge de manœuvre et éviter de devenir captif d'un seul fournisseur. Cela redéfinit les rapports de force dans une industrie où la puissance de calcul est devenue la ressource la plus critique.

La capacité d'AMD à proposer une alternative crédible à Nvidia est le meilleur espoir pour briser le monopole de fait sur l'IA de pointe. Leur succès ou leur échec déterminera si nous aurons un marché compétitif ou un marché dominé par un seul architecte pour les années à venir. — Analyste en chef, firme de capital-risque spécialisée dans les infrastructures tech.

Il serait toutefois irresponsable de céder à un optimisme béat. Les obstacles sur la route d'AMD restent colossaux. Le premier, et le plus évident, est l'écosystème logiciel. ROCm a progressé, mais CUDA reste la lingua franca de l'IA. Des millions de lignes de code, des années de recherche académique, et des déploiements industriels gigantesques reposent sur cette plateforme. La conversion est un processus lent, coûteux et risqué. Même avec des performances matérielles supérieures sur le papier, la résistance au changement et le coût de la migration peuvent être des freins décisifs pour les grands clients.

Ensuite, il y a la question de l'exécution et de la chaîne d'approvisionnement. Annoncer Helios pour le second semestre 2026 est une chose. Livrer des milliers de ces racks complexes, avec des puces gravées en 2 nm et 3 nm, en temps et en heure, en est une autre. AMD a connu des retards par le passé. Nvidia, de son côté, a démontré une capacité remarquable à exécuter sa feuille de route et à livrer en volume. La crédibilité d'AMD en tant que fournisseur de niveau 1 pour les hyperscalers sera jugée à l'aune de sa ponctualité et de la fiabilité de ses livraisons.

Enfin, la dimension financière ne peut être ignorée. Malgré une croissance spectaculaire, la valorisation boursière d'AMD, autour de 250 à 300 milliards de dollars fin 2025, reste nettement inférieure à celle de Nvidia. Cet écart se traduit par des ressources moindres pour la R&D et les investissements en capital. Nvidia peut se permettre de parier sur plusieurs générations de technologies en parallèle. AMD doit faire des choix plus ciblés. Cette asymétrie des ressources est un désavantage structurel que la simple ingéniosité technique ne suffit pas toujours à compenser.

Les prochains mois seront décisifs. La disponibilité commerciale des premiers racks Helios, attendue au deuxième semestre 2026, constituera le premier vrai test. Les benchmarks indépendants, les témoignages de clients pilotes et les chiffres de livraison seront scrutés à la loupe. Parallèlement, le déploiement à grande échelle de la plateforme Rubin de Nvidia chez des clients comme Microsoft dans ses « AI super factories » montrera la force de la contre-offensive du leader.

La feuille de route annonce déjà la suite : la série Instinct MI500 d'AMD, prévue pour 2027 avec son architecture CDNA 6 et ses promesses de gains de performance vertigineux, se heurtera aux successeurs de Rubin. Cette cadence infernale d'une nouvelle génération majeure chaque année ou presque est le nouveau rythme normal du marché de l'IA. Elle exige non seulement de l'innovation de rupture, mais aussi une exécution industrielle parfaite.

La scène du CES 2026, avec Lisa Su présentant Helios comme le « meilleur rack IA du monde », restera dans les mémoires comme le moment où AMD a cessé de courir derrière Nvidia pour se placer résolument à ses côtés sur la ligne de départ. Le soleil d'Helios s'est levé. La question maintenant est de savoir s'il parviendra à éclairer durablement le paysage, ou s'il ne sera qu'une brillante étoile filante dans le ciel encore largement dominé par l'éclat de Nvidia.

Your personal space to curate, organize, and share knowledge with the world.

Discover and contribute to detailed historical accounts and cultural stories. Share your knowledge and engage with enthusiasts worldwide.

Connect with others who share your interests. Create and participate in themed boards about any topic you have in mind.

Contribute your knowledge and insights. Create engaging content and participate in meaningful discussions across multiple languages.

Already have an account? Sign in here

La Corée du Sud parie 500 millions sur FuriosaAI pour défier Nvidia avec sa puce Renegade, 40% plus économe en énergie p...

View Board

Découvrez comment les PC IA, équipés de NPU dédiés, transforment nos ordinateurs en partenaires intelligents, redéfiniss...

View Board

L'ère du silicium spécialisé s'ouvre avec l'ascension des ASIC et des puces modulaires, défiant l'hégémonie des GPU et r...

View Board

Deepgram lève 130 M$ en Série C pour dominer l'IA vocale mondiale, étend Nova-3 à 10 langues et acquiert OfOne.

View Board

Feu! Chatterton : L'Architecture d'un Songe Parisien Le 16 octobre 2025, dans l'écrin acoustique du Studio 104 de Radio ...

View Board

Découvrez comment l'IA devient un collègue de travail en 2026, transformant les usines, les bureaux et les vignobles ave...

View Board

Dans les ruelles de Berlin-Est, tunnels clandestins, ballons à air chaud et plans audacieux ont défié un Mur de béton qu...

View Board

TSMC domine le marché des puces IA avec des revenus records de 3 809 milliards de dollars taïwanais en 2025, mais sa dép...

View Board

Le 1er octobre 2018, à 94 ans, le monde a perdu une voix : Charles Aznavour, un titan de la chanson française dont plus ...

View Board

Google LiteRT révolutionne l'IA embarquée en permettant l'exécution de modèles sur microcontrôleurs avec seulement 16 Ko...

View Board

Meta mise 2 milliards de dollars sur Manus, une startup d'IA rentable, pour dominer le marché des agents intelligents et...

View Board

L'IA en 2026 : révolution silencieuse ou tournant critique ? Le 12 mars 2024, un agent d’intelligence artificielle a, d...

View Board

Le TinyML révolutionne l'électronique en intégrant une IA ultra-frugale dans les objets du quotidien, transformant therm...

View Board

Spot, le robot quadrupède de Boston Dynamics, redéfinit les interventions à risque en devenant un partenaire opérationne...

View Board

A YouTuber's meteoric rise and catastrophic fall: Adam Dahlberg's story serves as a cautionary tale of the fleeting natu...

View Board

La chute d'iRobot : comment le pionnier américain des robots domestiques, symbole d'innovation, a succombé sous les tari...

View Board

A pesquisa em microgravidade na ISS revolucionou o tratamento do câncer, resultando em terapias inovadoras como o pembro...

View Board

Apple y Google unen fuerzas en 2026 para revolucionar Siri con IA Gemini, marcando un hito en la inteligencia artificial...

View Board

Samsung AI Living revolutioniert das Zuhause mit unsichtbarer KI, die Haushaltsaufgaben antizipiert und erledigt – vom K...

View Board

The elusive term Vexxed sparks a search for definition in 2026, revealing a labyrinth of unrelated fragments and a void ...

View Board

Comments