Explore Any Narratives

Discover and contribute to detailed historical accounts and cultural stories. Share your knowledge and engage with enthusiasts worldwide.

Le 2 janvier 2026, un développeur d'intelligence artificielle à San Francisco a reçu un email de son service juridique. L'objet : « Action Requise : Évaluation de Conformité TFAIA ». Le contenu détaillait une nouvelle série d'obligations bureaucratiques, de tests de sécurité et de déclarations publiques. La veille, le 1er janvier, deux lois étatiques pionnières étaient entrées en vigueur en Californie et au Texas. Pourtant, à Washington, une autre machine s'était mise en branle. Un ordre exécutif fédéral, signé le même jour, menaçait déjà de saper ces mêmes lois, les qualifiant de potentiellement « burdensome » et inconstitutionnelles. Un conflit de souveraineté, technique et brutal, venait de commencer. Il définira l'innovation, la sécurité et la vie privée pour la décennie à venir.

Cette collision entre l'action des États et la puissance fédérale n'est qu'une facette d'une transformation réglementaire globale. De Bruxelles à Washington, en passant par les capitales des États américains, 2026 est l'année où les principes abstraits sur la gouvernance de l'IA et de la technologie se transforment en textes de loi contraignants. Avec des délais serrés, des pénalités sévères et des définitions techniques précises, ces nouvelles règles ne concernent pas seulement les géants de la Silicon Valley. Elles affectent les startups, les fournisseurs gouvernementaux, les chercheurs en biotechnologie et, in fine, chaque utilisateur de services numériques.

En l'absence d'une loi fédérale complète sur l'IA, un vide s'est créé. La Californie et le Texas l'ont comblé avec des approches distinctes mais complémentaires. Le California Frontier AI Accountability Act (TFAIA) cible spécifiquement les modèles d'IA les plus puissants. Sa définition est purement technique et extrêmement exigeante : un « modèle frontalier » est un modèle dont l'entraînement a requis une puissance de calcul supérieure à 10^26 opérations par seconde. Ce seuil, faramineux, vise délibérément une poignée d'acteurs – les développeurs de modèles de fondation à grande échelle comme GPT-4, Gemini ou Claude. Pour eux, la loi impose des obligations rigoureuses en matière de gestion des risques, de tests de sécurité avant déploiement et de transparence sur les capacités et les limites des systèmes.

Le Texas, de son côté, a promulgué le Responsible AI Governance Act (RAIGA). Moins focalisé sur la puissance brute de calcul, il établit un cadre de gouvernance pour les systèmes d'IA utilisés par les agences de l'État et les entités contractantes. Il insiste sur les principes de loyauté, de non-discrimination et de responsabilité. Ensemble, la TFAIA et la RAIGA dessinent les contours d'une régulation « par le bas », où les États agissent comme des laboratoires d'idées – et d'obligations.

« La TFAIA californienne n'est pas une simple déclaration d'intention. C'est un cadre d'application concret avec des dents. Elle change la donne pour quiconque développe ou déploie une IA de pointe sur le sol américain, en créant une norme de diligence que d'autres États pourraient suivre », explique Marie Lefèvre, avocate spécialisée en droit des technologies chez King & Spalding.

L'impact est immédiat pour les entreprises. Une startup travaillant sur un modèle de langage de nouvelle génération doit désormais évaluer si ses plans d'entraînement la feront franchir le seuil des 10^26 opérations. Si c'est le cas, son chemin vers la commercialisation vient de s'allonger et de se complexifier. Elle doit budgétiser des audits de sécurité indépendants, documenter exhaustivement les données d'entraînement et mettre en place des protocoles pour atténuer les risques de génération de contenu dangereux. Les coûts de conformité deviennent un élément central de sa feuille de route.

Mais cette dynamique étatique crée un problème évident : la fragmentation. Une entreprise opérant à l'échelle nationale pourrait faire face à cinquante régimes réglementaires différents. C'est précisément ce risque qui a déclenché la réaction fédérale.

Le 1er janvier 2026, le président des États-Unis a signé un ordre exécutif qui jette une clé dans l'engrenage naissant de la régulation étatique. Son objectif affiché est de protéger l'innovation nationale et d'éviter un patchwork réglementaire étouffant. Mais ses mécanismes sont agressifs. L'ordre identifie les lois étatiques qui pourraient être « excessivement lourdes », notamment celles qui altéreraient les sorties « véridiques » d'un système d'IA ou violeraient les protections du Premier Amendement.

L'arme principale du gouvernement fédéral est la préemption. L'ordre exécutif charge le Secrétaire au Commerce de publier, au plus tard le 11 mars 2026, une évaluation détaillée des lois étatiques problématiques. Sur cette base, le gouvernement fédéral utilisera ses leviers financiers et réglementaires pour les neutraliser. Ces leviers sont puissants : conditionner l'octroi de fonds fédéraux, comme ceux du programme Broadband Equity, Access, and Deployment, au respect de normes fédérales ; utiliser l'autorité de la FTC (Federal Trade Commission) et de la FCC (Federal Communications Commission) pour établir des règles qui prévaudront sur celles des États.

« Cet ordre exécutif n'est pas une suggestion. C'est une directive opérationnelle avec une deadline claire. D'ici la mi-mars, nous aurons une cartographie des conflits et une feuille de route pour la préemption. Les États qui pensaient prendre les devants pourraient voir leurs lois rendues inapplicables par la menace de perdre des financements fédéraux essentiels », analyse Jean-Luc Bernard, professeur de droit constitutionnel à l'Université de Georgetown.

Le champ de bataille est donc tracé. D'un côté, les législateurs californiens et texans, convaincus de la nécessité d'une action immédiate pour encadrer des technologies aux risques sociétaux profonds. De l'autre, l'exécutif fédéral, soucieux de préserver une cohérence nationale et un avantage compétitif dans la course à l'IA. Les exceptions notables à cette préemption, comme les lois sur la sécurité des enfants en ligne ou la régulation des centres de données, montrent où se situent les compromis possibles. Mais pour le cœur de la régulation de l'IA – sécurité, transparence, non-discrimination – le conflit est inévitable.

Les entreprises se retrouvent dans une position délicate. Doivent-elles se conformer immédiatement aux lois de la Californie et du Texas, au prix d'investissements substantiels ? Ou parier sur la préemption fédérale et risquer de se retrouver en infraction dans quelques mois ? La période entre le 1er janvier et le 11 mars 2026 est un intervalle d'incertitude maximale. La seule stratégie raisonnable est une surveillance juridique intense et une préparation à plusieurs scénarios. Le paysage réglementaire américain n'est plus simplement complexe ; il est devenu instable.

Pendant que les États-Unis se débattent avec leur propre fragmentation interne, l'Union européenne a tracé son chemin avec une approche unifiée et ambitieuse : l'AI Act. Entré en vigueur progressivement, ce texte législatif n'est pas seulement le premier du genre au monde ; il est aussi un signal clair que l'Europe entend réguler la technologie avec une priorité donnée à l'éthique, à la transparence et aux droits fondamentaux. Contrairement aux États-Unis, où l'innovation est souvent le mantra dominant, l'UE place la protection du citoyen au cœur de sa stratégie. L'AI Act impose des obligations de transparence pour l'IA générative, même si elle n'est pas classée comme "à haut risque", exige l'enregistrement des systèmes à haut risque dans une base de données publique et insiste sur la conformité au droit d'auteur européen.

Cette approche contraste fortement avec l'agitation américaine. Alors que Washington et les États s'affrontent sur la préemption, l'UE propose un cadre clair, bien que complexe. Elle vise à créer un marché unique numérique où les règles du jeu sont définies à l'avance, offrant une certitude juridique aux entreprises. Les startups européennes, mais aussi celles qui souhaitent opérer sur le continent, bénéficieront de "bacs à sable" réglementaires pour tester leurs innovations dans des conditions réelles, un soutien concret pour naviguer dans un environnement réglementaire exigeant. C'est une stratégie de "gardiennage" qui vise à s'assurer que l'innovation ne se fasse pas au détriment des valeurs démocratiques.

« L'AI Act européen est un modèle pour le reste du monde. Il démontre qu'il est possible de réguler l'IA de manière proactive et éthique, sans étouffer l'innovation. La transparence et la protection des droits sont les piliers d'une IA responsable, et l'Europe en fait une priorité absolue », a déclaré Ursula von der Leyen, Présidente de la Commission européenne, lors d'une conférence de presse en novembre 2025.

Pourtant, cette certitude a un prix. Les exigences de conformité sont lourdes, particulièrement pour les systèmes d'IA à haut risque, qui incluent des applications dans la santé, les transports, l'emploi et l'application de la loi. Les entreprises devront non seulement prouver la robustesse et la sécurité de leurs systèmes, mais aussi s'assurer qu'ils respectent les principes de non-discrimination et de supervision humaine. C'est un défi de taille, mais également une opportunité de construire des produits plus fiables et dignes de confiance.

Aux États-Unis, en parallèle des débats sur l'IA, la National Defense Authorization Act (NDAA) pour l'exercice fiscal 2026 a introduit des changements profonds, bien que moins médiatisés, dans la manière dont le gouvernement interagit avec le secteur technologique. Adoptée entre octobre et décembre 2025, cette loi alloue 150 millions de dollars par an pour les années 2026 et 2027 au Trésor américain afin de renforcer les restrictions sur les transactions avec des "personnes étrangères couvertes", notamment dans la biotechnologie et la technologie de pointe. Il s'agit d'une mesure de sécurité nationale, visant à protéger les chaînes d'approvisionnement critiques et les technologies sensibles.

La NDAA donne au Département de la Défense (DoD) une autorité élargie pour les contrats commerciaux. La Section 1823 amende les régulations d'acquisition fédérale, permettant au DoD d'acheter "tout produit commercial", et pas seulement les technologies "innovantes". Cela inclut la possibilité d'accords de production "follow-on", facilitant l'intégration de solutions commerciales éprouvées dans les programmes de défense. Cette disposition est particulièrement pertinente pour les petites et moyennes entreprises (PME) qui, jusqu'alors, peinaient à naviguer dans la complexité des appels d'offres gouvernementaux.

« La NDAA 2026 est une déclaration claire : la sécurité nationale passe par la maîtrise technologique. En investissant 150 millions de dollars et en renforçant les capacités de surveillance des transactions étrangères, le gouvernement fédéral envoie un message fort aux acteurs malveillants tout en rationalisant l'accès aux technologies critiques », a souligné David Chen, analyste en politique de défense chez Fenwick.com, fin 2025.

Le Trésor américain, quant à lui, est autorisé à recruter jusqu'à 15 personnes supplémentaires pour identifier les transactions non notifiées ou prohibées. Il créera également une base de données publique des entités étrangères couvertes, offrant un outil précieux pour les entreprises cherchant à éviter les partenariats risqués. Un processus de "feedback non contraignant", y compris anonyme, sera mis en place pour permettre à l'industrie de vérifier si une transaction potentielle est prohibée. Cette initiative est un geste pragmatique pour aider les entreprises à naviguer dans ce nouveau paysage complexe, où les pénalités peuvent aller jusqu'au désinvestissement forcé.

Si 2026 voit une intensification de la régulation, elle est également marquée par une profonde fragmentation des approches, du moins aux États-Unis. La prédiction des analystes de hackdiversity.com, émise en 2025, selon laquelle "d'ici 2026, la plupart des États adopteront des règles sur l'IA", semble se confirmer. Le 1er janvier 2026, "de nombreuses lois liées à la technologie sont entrées en vigueur", comme l'a rapporté The Verge (cité par interestingengineering.com en 2026), impactant tout, des applications aux services en ligne.

En Californie, les lois entrées en vigueur le 1er janvier 2026 obligent les développeurs d'IA majeurs à divulguer des informations sur la sécurité et la protection des employés signalant des préoccupations internes. Les forces de l'ordre doivent communiquer de manière transparente sur l'usage de l'IA, et des directives spécifiques ont été établies pour les chatbots destinés aux mineurs. Au Texas, bien qu'un cadre interdisant les applications d'IA nuisibles ou discriminatoires soit en place, une injonction judiciaire temporaire bloque une exigence de vérification d'âge pour les app stores, soulignant les batailles légales qui accompagnent inévitablement cette vague réglementaire. Le Nevada, lui, a choisi de réglementer le contenu politique généré par IA, une réponse directe aux défis de la désinformation électorale.

Cette effervescence législative étatique est une réponse directe à l'immobilisme de Washington. Les États, la Californie en tête, agissent comme des "hubs expérimentaux", explorant des solutions pour la confidentialité des données, les cryptomonnaies, les médias sociaux et même le droit à la réparation des appareils électroniques. La loi fédérale Take It Down Act, visant à lutter contre la diffusion d'images intimes non consensuelles, verra son application retardée jusqu'en mai 2026, tandis que la législation sur l'IA de New York sera effective en mars 2026. Ces dates disparates créent un calendrier de conformité complexe et parfois contradictoire pour les entreprises opérant à travers le pays.

La question se pose : cette fragmentation est-elle une force ou une faiblesse ? D'un côté, elle permet une adaptation rapide aux besoins locaux et une expérimentation réglementaire. De l'autre, elle impose des coûts de conformité exorbitants et peut freiner l'innovation à l'échelle nationale. L'alignement international, recherché par la diplomatie du Département d'État pour favoriser les exportations technologiques américaines, semble d'autant plus difficile à atteindre quand le pays lui-même n'a pas de position unifiée.

« Le véritable défi pour les entreprises technologiques en 2026 ne sera pas de comprendre une seule loi, mais de naviguer dans une mer de régulations concurrentes. Cela exige une agilité juridique sans précédent et une capacité à anticiper les conflits entre les niveaux de gouvernement », a commenté un analyste juridique anonyme pour interestingengineering.com, en 2026.

Les controverses ne manquent pas. Les injonctions judiciaires au Texas et en Utah contre la vérification d'âge pour les app stores illustrent les limites de la régulation étatique face aux libertés constitutionnelles. La qualification de "burdensome" par l'ordre exécutif fédéral pour certaines lois étatiques n'est pas qu'une question de terminologie ; elle est le signe d'une bataille idéologique sur l'équilibre entre innovation et sécurité. Comment concilier la volonté d'innover rapidement avec la nécessité de protéger les citoyens ? C'est la question fondamentale que pose cette année 2026.

Un aspect souvent négligé de cette dynamique est la facilitation pour les PME. La NDAA, par exemple, relève les seuils pour les données de coût/prix et la conformité CAS, priorisant les solutions commerciales. Cela rend les contrats gouvernementaux plus accessibles aux petits acteurs, créant un contrepoids à la complexité réglementaire générale. C'est un détail, mais un détail important qui pourrait démocratiser l'accès aux marchés publics pour des entreprises innovantes qui n'auraient jamais pu rivaliser avec les géants de l'industrie auparavant. Mais cela est-il suffisant face à la marée montante des exigences de conformité ? La réponse reste en suspens.

Les batailles réglementaires de 2026 ne se limitent pas à des paragraphes de loi ou des budgets fédéraux. Elles redéfinissent l'architecture fondamentale du pouvoir dans l'ère numérique. Qui contrôle les flux de données ? Qui est responsable des décisions algorithmiques ? Qui a le dernier mot sur ce qui constitue une innovation acceptable ? Les réponses émergent de cette lutte complexe entre États, gouvernement fédéral et instances internationales. L'enjeu dépasse la simple conformité ; il s'agit de déterminer si la gouvernance technologique du XXIe siècle sera fragmentée et réactive, ou cohérente et anticipatrice.

L'impact culturel est déjà tangible. La méfiance envers les "boîtes noires" algorithmiques, alimentée par des années de scandales liés à la vie privée et aux biais discriminatoires, a forcé la main des législateurs. Les lois sur la transparence, comme celles de la Californie concernant l'usage de l'IA par les forces de l'ordre, répondent directement à une exigence citoyenne de redevabilité. La régulation n'est plus perçue comme un frein bureaucratique, mais comme un prérequis nécessaire à une confiance érodée. L'industrie technologique doit désormais composer avec une nouvelle réalité : ses produits ne seront plus jugés uniquement sur leur utilité ou leur rentabilité, mais aussi sur leur conformité à des normes éthiques et démocratiques.

« Nous assistons à la naissance d’un nouveau contrat social pour l’ère numérique. Les lois de 2026, malgré leurs imperfections, établissent un principe fondamental : la technologie doit servir la société, et non l’inverse. Ce n’est pas la fin de l’innovation, c’est le début de sa maturité », déclare Camille Rossi, directrice du think tank Digital Futures, dans une analyse publiée en février 2026.

L'héritage de cette année charnière sera probablement la normalisation du principe de précaution dans le domaine tech. L'approche européenne, avec ses catégories de risque et ses exigences de conformité préalable, gagne du terrain conceptuel même aux États-Unis, où la Californie emprunte une voie similaire. La course technologique ne se gagne plus seulement en étant le premier sur le marché, mais aussi en étant le plus sûr, le plus transparent et le plus digne de confiance. Cette évolution représente un changement de paradigme historique pour une industrie habituée à une croissance rapide et à une régulation a posteriori.

Pour autant, cette nouvelle architecture est loin d'être parfaite. Sa faiblesse la plus évidente est sa complexité vertigineuse. Une startup doit désormais jongler avec la TFAIA californienne, les restrictions de la NDAA, les injonctions contradictoires des tribunaux du Texas, et les potentiels préemptions fédérales annoncées pour le 11 mars 2026. Le coût de la conformité, en ressources humaines et financières, risque d'écraser les petites structures innovantes, au profit des géants qui disposent de légions d'avocats et de responsables de la conformité. La promesse de la NDAA de faciliter l'accès des PME aux contrats publics est une bouée de sauvetage bienvenue, mais elle suffira-t-elle à compenser le tsunami réglementaire ?

Le conflit États-fédéral crée une incertitude juridique toxique pour les investissements. Quel investisseur voudra parier sur une technologie dont le statut légal pourrait être remis en cause par une décision du Secrétaire au Commerce dans quelques semaines ? Cette instabilité pourrait paradoxalement ralentir l'innovation américaine, précisément ce que l'ordre exécutif fédéral prétend vouloir éviter. De plus, la focalisation sur les "modèles frontaliers" en Californie, définis par un seuil de calcul arbitraire (10^26 opérations), présente une lacune majeure. Elle ignore les risques potentiels de systèmes d'IA plus modestes mais déployés à grande échelle, ou les dangers spécifiques d'applications de niche dans des domaines comme la biométrie ou la justice prédictive.

Enfin, l'approche sécuritaire de la NDAA, bien que compréhensible, ajoute une couche de géopolitique à un paysage déjà surchargé. La désignation d'"entités étrangères couvertes" et la menace de désinvestissement forcé pourraient conduire à une fragmentation technologique mondiale, avec des écosystèmes numériques qui ne communiquent plus entre eux. La base de données publique du Trésor est un outil utile, mais elle ne résout pas le dilemme fondamental : comment protéger la sécurité nationale sans isoler l'innovation américaine du reste du monde ?

L'horizon immédiat est marqué par des dates précises qui façonneront le paysage. Le 11 mars 2026 est la date butoir pour l'évaluation du Secrétaire au Commerce et la déclaration de la FTC sur la préemption des lois étatiques. Les recommandations qui en découleront donneront le ton pour le reste de l'année, indiquant clairement quelles lois étatiques survivront et lesquelles seront neutralisées. En mars 2026 également, la législation sur l'IA de l'État de New York entrera en vigueur, ajoutant une autre pièce majeure au puzzle nord-américain. Puis, en mai 2026, l'application enfin effective de la loi fédérale Take It Down Act marquera un test crucial pour la lutte contre les abus en ligne, un domaine où la régulation a toujours été en retard sur la technologie.

Les prédictions pour la fin de 2026 et 2027 sont claires. La pression pour une loi fédérale américaine sur l'AI va s'intensifier, poussée par les entreprises lassées du patchwork étatique. Cette loi, si elle émerge, sera fortement influencée par les cadres déjà testés en Californie et au Texas, mais aussi par la nécessité de s'aligner, au moins partiellement, sur les standards de transparence de l'UE pour faciliter le commerce transatlantique. Du côté de la sécurité nationale, le budget de 150 millions de dollars de la NDAA commencera à se matérialiser par des enquêtes et des sanctions concrètes, faisant probablement la une des journaux économiques.

Le développeur de San Francisco qui, le 2 janvier, ouvrait avec anxiété l'email de son service juridique, aura parachevé son premier audit de conformité TFAIA d'ici la fin de l'année. Son équipe aura intégré de nouveaux processus de documentation et de test. Elle surveillera assidûment la base de données du Trésor avant tout partenariat. La régulation ne sera plus une surprise, mais une variable opérationnelle quotidienne, aussi réelle que les lignes de code. La question qui demeurera, bien après 2026, est de savoir si cette nouvelle normalité, née du chaos législatif, produira une technologie plus robuste et plus juste, ou si elle aura simplement ajouté une couche de complexité qui étouffe la prochaine idée révolutionnaire dans l'œuf.

Your personal space to curate, organize, and share knowledge with the world.

Discover and contribute to detailed historical accounts and cultural stories. Share your knowledge and engage with enthusiasts worldwide.

Connect with others who share your interests. Create and participate in themed boards about any topic you have in mind.

Contribute your knowledge and insights. Create engaging content and participate in meaningful discussions across multiple languages.

Already have an account? Sign in here

Le 1er janvier 2026 marque un tournant dans la régulation technologique aux États-Unis, avec l'entrée en vigueur de lois...

View Board

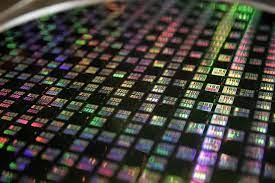

TSMC domine le marché des puces IA avec des revenus records de 3 809 milliards de dollars taïwanais en 2025, mais sa dép...

View Board

Deepgram lève 130 M$ en Série C pour dominer l'IA vocale mondiale, étend Nova-3 à 10 langues et acquiert OfOne.

View Board

Découvrez comment les PC IA, équipés de NPU dédiés, transforment nos ordinateurs en partenaires intelligents, redéfiniss...

View Board

L'ère du silicium spécialisé s'ouvre avec l'ascension des ASIC et des puces modulaires, défiant l'hégémonie des GPU et r...

View Board

La Corée du Sud parie 500 millions sur FuriosaAI pour défier Nvidia avec sa puce Renegade, 40% plus économe en énergie p...

View Board

La chute d'iRobot : comment le pionnier américain des robots domestiques, symbole d'innovation, a succombé sous les tari...

View Board

AMD lance Helios, un rack IA de 3 exaflops, défiant Nvidia avec 72 GPU MI455X et un partenariat clé avec OpenAI.

View Board

Comments