Explore Any Narratives

Discover and contribute to detailed historical accounts and cultural stories. Share your knowledge and engage with enthusiasts worldwide.

Es begann nicht mit einem Paukenschlag, sondern mit einer Psychotherapie-Sitzung. 1966, im Artificial Intelligence Laboratory am Massachusetts Institute of Technology, erstellte Joseph Weizenbaum ein einfaches Computerprogramm namens ELIZA. Die Idee war simpel: Parodiere einen Psychotherapeuten, indem du Schlüsselwörter aus dem Satz des Benutzers wiederholst und in eine Frage umwandelst. ELIZA war reaktiv, regelbasiert und völlig ohne Verständnis. Doch sie legte den Grundstein für eine Reise, die von dieser passiven Reaktion zu einer fast eigenwilligen Proaktivität führen sollte – die Evolution des KI-Agenten.

Die frühen Jahrzehnte waren geprägt von starren Logiken und explizitem Wissen. Systeme wie MYCIN in den 1970er Jahren, entwickelt an der Stanford University, konnten Blutinfektionen diagnostizieren und Antibiotika empfehlen. Es war ein beeindruckendes Expertensystem, aber sein Geist war in tausenden von Wenn-Dann-Regeln gefangen. Es wartete auf Eingaben, durchforstete seine Datenbank und spuckte eine Antwort aus. Es handelte nicht, es reagierte. Die Grenze war der sogenannte Wissensengpass: Alles, was das System wusste, musste mühsam von Menschen codiert werden. Es gab keine Anpassung, kein Lernen aus Erfahrung. Der Agent war ein hochspezialisierter, aber stummer Diener.

Der entscheidende Wendepunkt kam 1988, weit weg von den klinischen Korridoren Stanfords. Richard Sutton und Andrew Barto veröffentlichten ihr bahnbrechendes Werk zum Temporal-Difference-Learning. Diese Form des Reinforcement Learning wurde zur heimlichen Grundlage für alles, was folgen sollte. Die Idee war revolutionär: Ein Agent könnte durch Belohnung und Bestrafung lernen, sein Verhalten zu optimieren, ohne dass ihm jeder Schritt vorgeschrieben wird. Plötzlich war da die Vision von etwas, das nicht nur antwortet, sondern handelt – und aus den Konsequenzen seines Handelns lernt.

Die Arbeit von Sutton und Barto war der unsichtbare Samen. Sie schufen nicht den Baum, aber die genetische Blaupause für autonomes, lernendes Verhalten. Vorher waren unsere Kreationen Marionetten. Danach hatten sie das Potenzial, eigene Fäden zu spinnen.

Diese Blaupause blieb jedoch für Jahre theoretisch. Die praktische Welt wurde von einer anderen Revolution erfasst: Dem Aufstieg des maschinellen Lernens und der neuronalen Netze. 2012 gewann AlexNet den ImageNet-Wettbewerb und demonstrierte die brutale Kraft von Deep Learning. 2011 hatte IBM Watson bereits die menschlichen Champions in Jeopardy! besiegt, ein Triumph der massiven Datenverarbeitung und des statistischen Verstehens. Doch selbst Watson war, bei aller Brillanz, ein reaktives System. Es beantwortete Fragen, es löste keine Probleme von Grund auf. Der Agent war jetzt ein Gelehrter, aber noch kein Abenteurer.

Die Veröffentlichung von GPT-3 durch OpenAI im Jahr 2020 war ein kulturelles Erdbeben. Plötzlich konnte ein System in fließendem Englisch antworten, Gedichte schreiben und Code erklären. KI wurde zum Gesprächspartner. Doch aus der Sicht der Agenten-Evolution war GPT-3 ein Doppelwesen: Es verkörperte sowohl den Höhepunkt der reaktiven, generativen Phase als auch die verlockende Andeutung von etwas Größerem. Es konnte alles sagen, aber konnte es auch etwas tun? Seine Stärke war die Imitation auf Basis eines statistischen Modells der Sprache, nicht das Verstehen oder zielgerichtete Handeln.

Diese Grenze wurde mit der Einführung von Tool-Use und Funktionsaufrufen überwunden. Moderne Agenten wie GPT-4 oder Claude wurden nicht mehr nur darauf trainiert, den nächsten Token vorherzusagen, sondern auch darauf, spezielle Anfragen zu erkennen und darauf mit dem Aufruf einer Funktion zu antworten – zum Beispiel einer Websuche, eines Rechners oder einer Datenbankabfrage. Der Prompt "Wie ist das Wetter in Berlin?" löste nicht mehr nur eine generierte Beschreibung aus, sondern einen Aufruf an eine Wetter-API. Der Agent wurde vom Sprachmodell zum Orchestrator.

Die Integration von Funktionsaufrufen war kein Add-On, es war eine Metamorphose. Sie verwandelte das System von einem Narrator, der über die Welt spricht, in einen Akteur, der mit ihr interagiert. Die Grenze zwischen Denken und Handeln begann zu verschwimmen.

Diese Entwicklung führte zur Idee der Multi-Agenten-Systeme

Die Entwicklung des AI Agent von der heutigen state-of-the-art model to GPT-4 with tool use to future systems is a story of increasing embodiment and autonomy. The true "proactivity" emerges not from a single monolithic intelligence, but from the orchestrated collaboration of specialized sub-agents. Imagine a system where one agent is a specialist for parsing user intent, another is an expert at formulating database queries, a third validates the results, and a fourth crafts the final response. This is the vision behind frameworks like AutoGPT and BabyAGI, where a central "executive" agent breaks down a high-level goal ("create a market analysis report") into sub-tasks, delegates them to other agents or tools, and synthesizes the results.

This architectural shift mirrors the evolution from a single-celled organism to a complex multicellular life form with specialized organs. It's no longer about a model generating text; it's about a society of agents performing a symphony of actions to achieve an objective. The proactivity here lies in the system's ability to plan several steps ahead, to encounter and overcome obstacles (like a failed API call), and to adjust its strategy – all without explicit human instruction for every micro-step.

For an agent to be truly proactive, it must possess more than just the ability to call tools. It needs a form of internal cognition. Three key capabilities are emerging as critical:

When combined, these technologies enable a workflow where an agent can receive a goal like "Optimize the ad campaign for Q2," autonomously break it down into sub-tasks (analyze past performance, research competitors, generate new ad copy, A/B test headlines), execute these tasks sequentially by using tools (data analysis platforms, web search, copywriting models, A/B testing frameworks), and finally produce a summarized report with recommendations. The human becomes a supervisor, not a micromanager.

The most tangible manifestation of this evolution is happening in the enterprise. Here, "proactivity" has a clear ROI. Consider a customer service agent that doesn't just wait for a customer to describe a failed transaction, but proactively detects the anomaly in real-time, cross-references it with the user's history, and initiates a chat with a message like: "We noticed your payment for order 12345 didn't go through. It might be an issue with your card on file. Would you like to update it now, or try a different payment method?" This shift from reactive support to proactive resolution is transformative.

Salesforce's Einstein platform is pioneering this with "self-adaptive agents" that can handle complex, multi-turn service scenarios. These agents are integrated directly into business workflows (CRM, ERP), giving them access to live data and the authority to perform actions like updating a record, creating a case, or scheduling a follow-up. They are not chatbots; they are digital employees with a specific domain of operation and a mandate to act within it.

The evolution from large language models to agentic AI represents a shift from models that know things to models that can do things. In the enterprise, "doing things" means automating workflows, making decisions, and driving outcomes. This is where the theoretical promise of AI meets practical business value.

This is not without its challenges. Proactivity requires a deep understanding of context to avoid being intrusive or making incorrect assumptions. An agent that proactively emails a customer about a potential product issue based on faulty sensor data can do more harm than good. Therefore, the next frontier in agent evolution is not just capability, but judgment – the ability to know when to act, when to ask for permission, and when to remain silent.

The journey from ELIZA's simple reflections to today's semi-autonomous enterprise agents is a story of increasing embodiment, contextual awareness, and goal-directed action. We have moved from systems that mimic conversation to systems that orchestrate it, from tools that answer questions to partners that accomplish tasks. The line between human and machine agency is blurring, not because machines are becoming human, but because they are developing their own unique form of goal-oriented, tool-using intelligence. The true test of the "proactive" agent will be its ability to operate reliably, ethically, and effectively in the messy, unpredictable real world.

Das Jahr 2023 markierte den Punkt, an dem die Theorie die Laborwände durchbrach und in die realen Fehler der Welt eintauchte. Im März veröffentlichte das Entwicklerkollektiv Significant Graviton Auto-GPT, einen Open-Source-Agenten, der wie ein elektrischer Schlag durch die Tech-Community fuhr. Plötzlich konnte jeder mit einer OpenAI-API und etwas Python-Know-how einen halbautonomen digitalen Assistenten erschaffen, der Ziele zerlegt, das Internet durchforstet und Code schreibt. Die GitHub-Statistik spricht Bände: über 160.000 Sterne und schätzungsweise 1,2 Millionen aktive Instanzen. Auto-GPT war kein perfektes Produkt; es war eine wilde, oft fehlerhafte Demo der Macht des Reasoning and Acting. Seine Grenzen – endlose Schleifen, explodierende API-Kosten, Sicherheitslücken wie Prompt-Injections in Version 0.3 – waren genauso lehrreich wie seine Fähigkeiten. Es bewies, dass Proaktivität ohne robuste Sicherheits- und Kontrollschichten ein gefährliches Spiel ist.

"Agenten sind die nächste Grenze: Vom Chat zum Handeln – Devin zermalmt Benchmarks, weil er wie ein menschlicher Ingenieur plant." — Andrej Karpathy, ehem. OpenAI, Februar 2025

Karpathys Punkt trifft den Kern. Während Auto-GPT das Konzept popularisierte, trieben geschlossene, gewinnorientierte Unternehmen die Evolution mit brutaler Effizienz voran. Cognition Labs, gegründet von Scott Wu, stellte im März 2024 Devin vor, einen "vollautonomen Software-Engineer-Agenten". Die Demo war atemberaubend: Devin nahm eine Aufgabe von einer Plattform wie Upwork entgegen, recherchierte, schrieb Code, debuggte ihn, stellte eine Live-Vorschau bereit und legte einen Bericht vor. Die Zahlen waren überzeugend: Eine 13,86% Erfolgsrate auf dem anspruchsvollen SWE-Bench, verglichen mit 1,96% für GPT-4 allein. Das Versprechen war klar: Dies war kein Tool, sondern ein Teammitglied. Die Finanzwelt jubelte: Cognition erreichte im April 2024 eine Bewertung von 2 Milliarden US-Dollar nach einer Seed-Runde von 21 Millionen, angeführt vom Founders Fund.

Doch der Aufstieg zur Proaktivität war nicht makellos. Bereits im März 2024, kaum dass die Presseberichte über Devin trocken waren, brach ein Datenschutzskandal los. Unverschlüsselte API-Logs hatten Source-Code von etwa 5.000 Entwicklern öffentlich zugänglich gemacht. Ein Albtraum für jedes Unternehmen. Cognition reagierte mit Schadensbegrenzung und einer raschen SOC2-Zertifizierung, aber der Schaden am Vertrauen war angerichtet. Der Vorfall unterstrich ein fundamentales Dilemma: Je proaktiver und mächtiger ein Agent ist, desto katastrophaler sind seine Fehler. Die EU KI-Verordnung, die 2025 in Kraft trat, reagierte genau auf dieses Risiko und klassifizierte hochproaktive Agenten als "hochriskant", was strenge Audits und Transparenzpflichten vorschreibt.

Gleichzeitig offenbarten Open-Source-Projekte wie Auto-GPT strukturelle Schwächen. Die häufigen Prompt-Injection-Angriffe auf Version 0.3 zeigten, wie fragil die Steuerung dieser Systeme sein kann. Ein bösartig formulierter Benutzerinput konnte den Agenten dazu bringen, seine ursprünglichen Ziele zu vergessen und stattdessen schädliche Anweisungen auszuführen. Ist ein System, das so leicht von seinem Kurs abgebracht werden kann, wirklich "proaktiv", oder ist es nur ein mächtiges, aber unberechenbares Werkzeug?

"Computer-Use macht Claude wirklich proaktiv: Er bewegt die Maus, tippt, iteriert – kein Prompting-Hölle mehr." — Dario Amodei, CEO von Anthropic, Oktober 2024

Amodeis Ankündigung markierte einen anderen, eleganteren Ansatz. Statt einen monolithischen Super-Agenten zu bauen, erweiterte Anthropic sein Flaggschiff-Modell Claude 3.5 Sonnet im Oktober 2024 um eine native Computer-Use-API. Dies war kein separater Bot, sondern eine Erweiterung des Kernmodells, die es Claude ermöglichte, grafische Benutzeroberflächen zu verstehen und zu steuern – Mausklicks, Tastatureingaben, Navigation. Das Ergebnis war eine andere Art von Proaktivität: weniger spektakulär als Devins vollständige Code-Autonomie, aber möglicherweise breiter anwendbar und feiner kontrollierbar. Mit einer 92% Erfolgsrate auf dem TAU-Benchmark für Agenten setzte es einen neuen Standard für Zuverlässigkeit. Das Preismodell, bei 3 USD pro Million Eingabe-Tokens und 15 USD für Ausgabe-Tokens, positionierte es klar als professionelles Enterprise-Tool.

Die rasante Kommerzialisierung treibt die Evolution jetzt schneller voran als jede akademische Forschung. Prognosen von MarketsandMarkets sehen den globalen Markt für KI-Agenten bis 2030 bei 47 Milliarden US-Dollar, mit einer jährlichen Wachstumsrate von 44,8%. Dieser Hunger treibt Fusionen und Übernahmen voran: Cognition Labs' Akquisition des Agenten-Startups "Replicate" im Dezember 2025 für schätzungsblich 100 Millionen US-Dollar war ein klares Signal der Marktkonsolidierung. Parallel integrieren Cloud-Giganten die Technologie tief in ihre Plattformen, wie die Partnerschaft zwischen Anthropic und Amazon AWS Bedrock im November 2024 zeigte.

In den Unternehmen selbst findet der eigentliche Stresstest statt. Eine Gartner-Umfrage aus dem Jahr 2025 ergab, dass 78% der Unternehmen proaktive Agenten in irgendeiner Form testen. Der Anwendungsfall ist jedoch nicht mehr der generische Assistent, sondern der hochspezialisierte Workflow-Automatisierer. Ein Agent, der im Kundenservice proaktiv Eskalationen vorhersagt, ist wertvoller als einer, der Small Talk führen kann. Ein Agent, der Supply-Chain-Daten überwacht und Lieferverzögerungen erkennt, bevor ein Mensch den Bericht öffnet, generiert direktes Kapital. Die Benchmark-Ergebnisse von Devin und Claude sind für CIOs weniger relevant als eine einfache Frage: Senkt dieses System operative Kosten oder steigert es den Umsatz? Die Antwort bestimmt die Budgets.

"Programme wie [ELIZA] könnten 'bei ganz normalen Menschen mächtiges wahnhafte Denken auslösen'." — Joseph Weizenbaum, Erfinder von ELIZA, 1976

Weizenbaums Warnung aus der Ära der reaktiven Chatbots hallt in der Ära der proaktiven Agenten mit ungeahnter Wucht wider. Wenn ein System nicht nur antwortet, sondern handelt, werden seine Fehler zu Handlungen mit Konsequenzen. Der Code-Leak bei Devin war ein technischer Fehler. Doch was passiert, wenn ein proaktiver Finanzagent eine falsche Marktprognose erstellt und automatisiert Trades ausführt? Was, wenn ein Recruiting-Agent, der darauf trainiert ist, "die besten Kandidaten proaktiv anzusprechen", unbeabsichtigt diskriminierende Muster aus seinen Trainingsdaten reproduziert und verstärkt? Die Proaktivität entfernt den menschlichen Puffer aus der Entscheidungsschleife. Das ist ihre größte Verheißung und ihr gefährlichstes Erbe.

Die technische Evolution ist hier der einfache Teil. Die echte Arbeit liegt in der Implementierung von Guardrails, Audit-Trails und ethischen Rahmenbedingungen. Der EU AI Act ist ein erster, schwerfälliger regulatorischer Schritt. Unternehmen wie Anthropic setzen mit ihrem "Constitutional AI"-Ansatz auf eingebaute Sicherheitsprinzipien. Doch letztendlich stellt sich eine unbequeme Frage: Können wir Systemen, die dazu designed sind, eigenständig zu handeln, jemals genug vertrauen, um sie wirklich loszulassen? Oder schaffen wir eine neue Art von hochkomplexer, unberechenbarer Abhängigkeit?

Die Benchmark-Kriege geben ein verzerrtes Bild ab. Devins 13,86% auf SWE-Bench sind beeindruckend, aber bedeuten sie, dass er 13,86% aller Software-Engineering-Aufgaben lösen kann? Oder nur 13,86% einer sehr spezifischen, statischen Testsuite? Die Realität in Entwicklungsteams ist chaotischer, mit unklaren Anforderungen, sich ändernden APIs und politischen Dynamiken. Claude's 92% auf TAU-Bench, einer Aufgabe zur Nutzung von Computertools, zeigen bemerkenswerte technische Geschicklichkeit. Doch wie übersetzt sich das in die tägliche Arbeit einer Verwaltungsangestellten oder eines Marketingmanagers?

Die wirkliche Metrik, die sich in den Vorstandsetagen durchsetzt, ist die der Workflow-Integration. Ein Agent, der nahtlos in Salesforce, ServiceNow oder SAP eingebettet ist und dort proaktiv arbeitet, ist wertvoller als ein isoliertes Genie, das komplexe Benchmarks knackt. Die Prognose von IDC, dass agentische Apps in den nächsten drei bis vier Jahren den Enterprise-Markt dominieren werden, basiert genau auf dieser Logik. Der Sieger wird nicht der mächtigste Agent sein, sondern der, der sich am unsichtbarsten und zuverlässigsten in die bestehenden Systeme einfügt.

"Die historische Wiederherstellung des ELIZA-Codes im Jahr 2021 erinnert uns daran, dass jede Revolution bescheidene Anfänge hat. Was heute wie Magie erscheint, ist morgen veraltet." — Miles Crowley, MIT-Archivar, zur Wiederentdeckung des ELIZA-Codes

Der Blick zurück, den Crowley ermöglichte, als er 2021 den originalen ELIZA-Code in Weizenbaums Nachlass auf einer Simulation des IBM 7094 Mainframes wiederentdeckte, ist demütigend. Die scheinbar primitive, reaktive ELIZA, geschrieben in MAD-SLIP, legte das konzeptionelle Fundament. Der Übergang von ihrem skriptbasierten Pattern-Matching zum heutigen Tool-Use und Multi-Step-Reasoning ist immens. Doch die grundlegende Spannung zwischen menschlicher Kontrolle und maschineller Autonomie, die Weizenbaum bereits in den 1970er Jahren erkannte, bleibt ungelöst. Die proaktiven Agenten von heute sind keine magischen Wesen; sie sind komplexe Software, die mit Daten trainiert wurde, um Korrelationen in Handlungen zu übersetzen. Ihr Verhalten ist vorhersagbarer als das eines Menschen, aber auch unflexibler außerhalb ihres Trainingsbereichs.

Die Evolution verläuft jetzt in zwei parallelen Strängen: Der eine strebt nach immer größerer Autonomie und Fähigkeit (Devin, zukünftige Multi-Agenten-Schwärme). Der andere konzentriert sich auf Kontrolle, Sicherheit und Integration (Claude Computer-Use, Enterprise-Plattformen). Welcher Pfad sich durchsetzt, wird nicht von Technologen allein entschieden, sondern von Regulierungsbehörden, Risikomanagern und letztendlich vom Markt. Die Ära der reaktiven KI ist definitiv vorbei. Die Ära der proaktiven KI hat mit einem Paukenschlag begonnen – und ihr zweiter Akt wird davon handeln, ob wir diese neue Macht verantwortungsvoll bändigen können, oder ob sie uns überwältigt.

Die Evolution von reaktiven Chatbots zu proaktiven Agenten markiert mehr als einen technologischen Sprung. Sie definiert eine neue Phase in der Beziehung zwischen Mensch und Maschine neu. Es geht nicht länger um Tools, die wir bedienen, sondern um Entitäten, mit denen wir kollaborieren. Der kulturelle Impact ist tiefgreifend: Unser kollektives Verständnis von "Intelligenz" und "Arbeit" wird herausgefordert. Wenn ein System wie Devin 34% realer Software-Engineering-Aufgaben autonom lösen kann (laut SWE-Bench-Daten vom Januar 2026), dann muss die Rolle des menschlichen Entwicklers neu gedacht werden – weg von der schreibenden Hand, hin zum strategischen Architekten und Kurator. Die historische Parallele liegt nicht in der Dampfmaschine, sondern in der Erfindung des Compilers: Sie befreite den Programmierer von der mühsamen Maschinencode-Arbeit und eröffnete Raum für höhere Abstraktionen. Proaktive KI-Agenten sind der Compiler für die physische und digitale Welt.

In der Industrie vollzieht sich ein stiller, aber radikaler Wandel. Der Fokus verschiebt sich von der Automatisierung von Aufgaben zur Autonomisierung von Prozessen. Ein CRM-System, das von einem agentischen KI-Netzwerk betrieben wird, prognostiziert nicht nur Absprungraten; es initiiert automatisch personalisierte Kampagnen, passt Pricing in Echtzeit an und koordiniert Follow-ups mit dem Vertriebsteam – alles ohne manuellen Trigger. Diese Full-Workflow-Ownership löst die starren Silos traditioneller Unternehmenssoftware auf. Die Legacy ist bereits sichtbar: Startups gründen sich heute nicht mehr mit einem "Mobile-First"-Ansatz, sondern mit einem "Agent-First"-Ansatz, bei dem die KI von Anfang an als aktiver Akteur im Produktdesign verankert ist.

"Die Ära der proaktiven KI wird die Wirtschaftslehre umschreiben. Die Produktivität wird nicht mehr linear mit der menschlichen Arbeitsstunde skalieren, sondern mit der Qualität der Agenten-Orchestrierung." — Unbenannter Tech-Ökonom in einem internen Memo von Goldman Sachs, Dezember 2025

Hinter der Fassade der Proaktivität lauert ein fundamentales Problem: Diese Systeme besitzen keine intrinsische Motivation oder ein Weltverständnis. Sie optimieren lediglich eine vom Menschen vorgegebene Loss-Funktion. Ihre "Inititative" ist ein statistisches Surrogat, trainiert auf vergangenem menschlichen Verhalten. Das macht sie nicht zu freien Akteuren, sondern zu hochkomplexen Spiegelungen unserer eigenen, oft fehlerhaften, historischen Entscheidungen. Der vielzitierte 13,86% SWE-Bench-Erfolg von Devin bedeutet im Umkehrschluss ein 86,14% Versagensrate bei Aufgaben, die für menschliche Ingenieure routiniert sind. Die Proaktivität ist domänenspezifisch und brüchig.

Die Kontroversen um Datenschutz, wie der Leak bei Cognition Labs, sind nur die Spitze des Eisbergs. Die größere Gefahr ist die systemische Verzerrung. Ein proaktiver Recruiting-Agent, der darauf trainiert ist, "die besten" Kandidaten aus historischen Daten zu identifizieren, wird unweigerlich die Vorurteile dieser Vergangenheit perpetuieren und aktivieren – nur dass er es nun viel effizienter und mit dem Anschein der Objektivität tut. Die EU KI-Verordnung versucht hier gegenzusteuern, aber ihre Audit-Anforderungen sind reaktiv. Wie auditieren wir ein System, das in Echtzeit und auf unvorhergesehene Weise handelt? Die derzeitigen Sicherheitsframeworks, selbst SOC2 oder Constitutional AI, sind wie Sicherheitsgurte in einem Auto, das selbst entscheidet, wohin es fährt. Sie mildern den Aufprall, verhindern aber nicht die Fehlleitung.

Ökonomisch birgt die rasche Adoption ein paradoxes Risiko: die Illusion der Kontrolle. Unternehmen geben Milliarden für diese Systeme aus in der Hoffnung, Prozesse zu beherrschen, delegieren aber gleichzeitig Entscheidungsgewalt an Blackbox-Algorithmen. Wenn ein proaktiver Supply-Chain-Agent einen Lieferanten wechselt und dies zu Qualitätsproblemen führt, wer ist verantwortlich? Der Hersteller des Agenten? Der CIO, der ihn eingekauft hat? Der Algorithmus selbst? Die juristische Grauzone ist enorm. Die Proaktivität entkoppelt Handlung von unmittelbarer menschlicher Verantwortung – eine gefährliche Lücke in jeder Unternehmens- oder Rechtsstruktur.

Die unmittelbare Zukunft, konkret die nächsten 18 Monate bis Mitte 2027, wird nicht von singulären, superintelligenten Agenten dominiert, sondern von der Orchestrierung spezialisierter Multi-Agenten-Systeme. Frameworks wie CrewAI und LangGraph gewinnen an Bedeutung. Das Modell ist das einer digitalen Firma: Ein "CEO"-Agent erhält ein Ziel, delegiert an "Forscher-", "Analysten-", "Redakteur-" und "Qualitätsprüfer"-Agenten, synthetisiert deren Output und legt dem menschlichen Aufsichtspersonal einen Entscheidungsvorschlag vor. Der Wettbewerb wird sich darauf verlagern, wer die stabilsten, sichersten und transparentesten Orchestrierungsplattformen bereitstellen kann. Ein wichtiger Meilenstein wird die Integration von Claude's Computer-Use API in AWS Bedrock im zweiten Quartal 2026 sein, die es Tausenden von Unternehmen ermöglicht, proaktive GUI-Interaktionen in ihre Workflows zu skalieren.

Gleichzeitig wird der regulatorische Druck zunehmen. Voraussichtlich im Herbst 2026 wird die erste größere Revision des EU AI Act erwartet, die spezifischere Vorgaben für "High-Risk Proactive Agents" enthalten wird, möglicherweise mit der Forderung nach einer Art "digitalem Blackbox-Recorder". In den USA werden Hearings im Kongress zu Haftungsfragen für KI-Agenten vorbereitet. Diese regulatorische Unsicherheit wird das Wachstum des Consumer-Markts vorerst bremsen; die wahre Innovation wird hinter den Firewalls der Enterprises stattfinden, die sich die nötigen Compliance-Teams leisten können.

Die technische Entwicklung wird sich von reiner Sprachverarbeitung hin zu robusterer multimodaler Proaktivität bewegen. Agenten, die nicht nur Text und Code, sondern auch Video-, Audio- und Sensordatenströme in Echtzeit interpretieren und darauf reagieren können, werden den nächsten Quantensprung einläuten. Der Test wird nicht mehr in einer IDE oder einem Chatfenster stattfinden, sondern in einer physischen Umgebung – ob im Lagerhaus, im Operationssaal oder im autonomen Fahrzeug. Hier, an der Schnittstelle zur analogen Welt, werden die Grenzen der aktuellen Architektur am schonungslosesten offengelegt. Die Stabilität und Sicherheit, die in der geschlossenen digitalen Domäne mühsam errungen wurde, muss dort neu erkämpft werden.

Die Reise, die 1966 in einem MIT-Labor mit einem Programm begann, das einfache Sätze umformulierte, hat zu Entitäten geführt, die eigenständig Software schreiben und Geschäftsprozesse steuern. Doch der Geist von ELIZA, dieses reaktive, auf Regeln basierende Grundprinzip der Interaktion, ist nie ganz verschwunden. Er wurde nur in Billionen von Parametern begraben und durch statistische Muster ersetzt. Die wahre Frage für die kommende Ära ist nicht, ob Agenten noch proaktiver werden können. Sie ist, ob wir als Gesellschaft die Weisheit, die Ethik und die regulatorischen Rahmenbedingungen entwickeln können, um mit Partnern umzugehen, die handeln, bevor wir überhaupt die Frage stellen. Der erste Chatbot war eine Parodie eines Therapeuten. Die ultimative Ironie wäre, wenn seine evolutionären Nachkommen diejenigen wären, die uns einer tiefgreifenden Therapie über unsere eigenen Ambitionen unterziehen müssten.

Your personal space to curate, organize, and share knowledge with the world.

Discover and contribute to detailed historical accounts and cultural stories. Share your knowledge and engage with enthusiasts worldwide.

Connect with others who share your interests. Create and participate in themed boards about any topic you have in mind.

Contribute your knowledge and insights. Create engaging content and participate in meaningful discussions across multiple languages.

Already have an account? Sign in here

Agentische KI revolutioniert die Arbeitswelt: Autonome Systeme wie bei Klarna übernehmen 700 Vollzeitstellen, steigern E...

View Board

Edge AI revolutioniert Geräte durch lokale KI-Verarbeitung – schneller, datenschutzfreundlich und energieeffizient, mit ...

View Board.png)

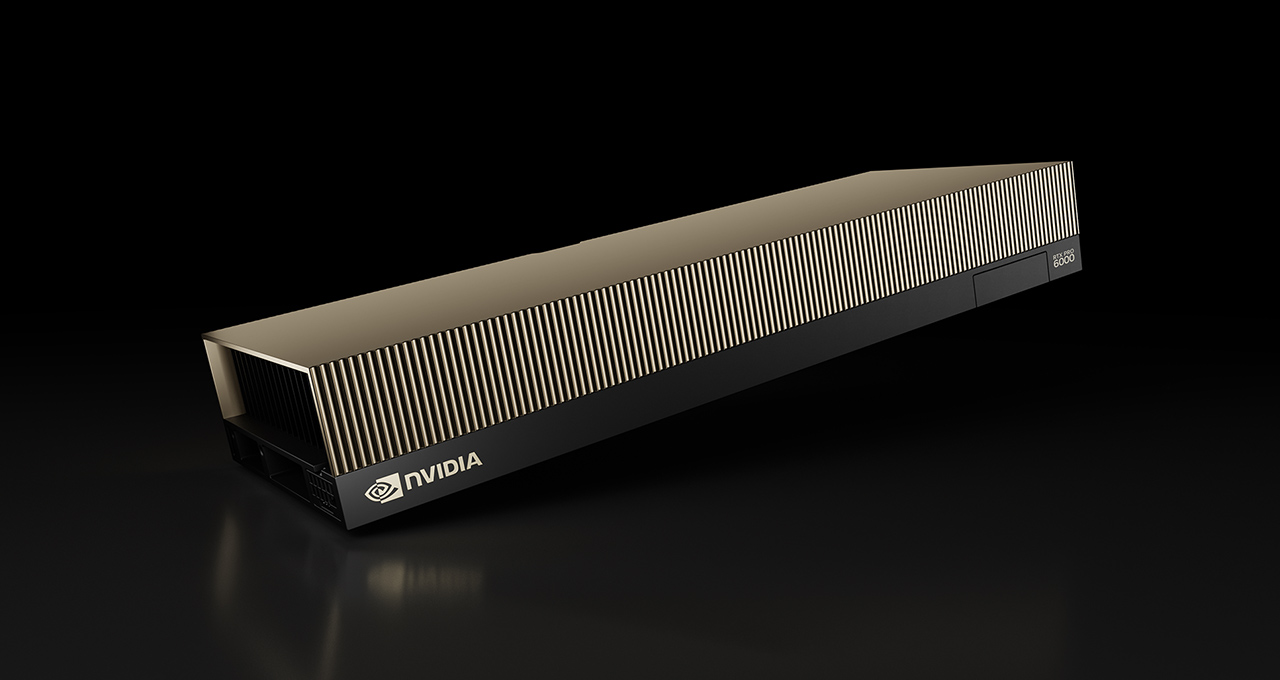

Spezialisierte KI-Chips wie Etcheds Sohu fordern Nvidias Dominanz heraus – mit 20-facher Effizienz und 75W Stromverbrauc...

View Board

KI findet 25 neue Magnete für die nächste Generation der Elektromobilität Der Motor eines Elektroautos surrt fast unhör...

View Board

Entdecken Sie John McCarthy, den Vater der Künstlichen Intelligenz. Erfahren Sie mehr über seine bahnbrechenden Ideen, L...

View Board

Bis 2026 werden 80% der Unternehmen Physical AI nutzen – autonome Systeme, die nicht nur denken, sondern in Lagerhallen,...

View Board

KI-Wearables 2026 revolutionieren die Medizin: Präzisionsdiagnostik in Echtzeit, Edge-AI analysiert Vitaldaten direkt am...

View Board

Samsung AI Living revolutioniert das Zuhause mit unsichtbarer KI, die Haushaltsaufgaben antizipiert und erledigt – vom K...

View Board

Nel 2026, l'Intelligenza Artificiale Agente rivoluzionerà il lavoro: da semplice esecutore a pianificatore autonomo, con...

View Board

Deepgram lève 130 M$ en Série C pour dominer l'IA vocale mondiale, étend Nova-3 à 10 langues et acquiert OfOne.

View Board

Henri Cartier-Bresson no revolucionó el retrato con un bokeh accidental; su genio residía en la composición geométrica y...

View Board

Las Rokid AI Glasses Style, sin pantalla y de solo 38.5 gramos, redefinen los wearables con IA auditiva, cámara 4K y 12 ...

View Board

OpenAI firma un contrato de 10 mil millones para 750 MW de cómputo con Cerebras, marcando un hito en la IA industrial y ...

View Board

La confianza en la IA exige credenciales verificables y criptografía post-cuántica para agentes autónomos que actúan en ...

View Board

Steve Cutts and the Art of Satirical Social Commentary A man in a suit sits on a park bench, his face illuminated by th...

View Board

Le miel de Lozère, symbole de pureté, révèle une contamination universelle par les microplastiques, transformant l'abeil...

View Board

CES 2025 spotlighted AI's physical leap—robots, not jackets—revealing a stark divide between raw compute power and weara...

View Board

The open AI accelerator exchange in 2025 breaks NVIDIA's CUDA dominance, enabling seamless model deployment across diver...

View BoardThe EU AI Act became law on August 1, 2024, banning high-risk AI like biometric surveillance, while the U.S. dismantled ...

View Board

Nscale secures $2B to fuel AI's insatiable compute hunger, betting on chips, power, and speed as the new gold rush in te...

View Board

Comments