Explore Any Narratives

Discover and contribute to detailed historical accounts and cultural stories. Share your knowledge and engage with enthusiasts worldwide.

El laboratorio 4B en Mountain View huele a café rancio y tensión creativa. Son las 3:47 AM de un martes de diciembre de 2025. Elena Vargas, con el cabello recogido en un desordenado moño y anteojos de pasta azul, observa una cascada de números en una pantalla. No son cifras financieras ni código genético. Son los latidos de una turbina a 12.000 kilómetros de distancia, transmitidos en un flujo interminable de datos de vibración, temperatura y presión. Su creación, un modelo de inteligencia artificial bautizado como Titans, no solo los analiza. Los está recordando. Y, por primera vez, está decidiendo por sí mismo qué fragmentos de ese torrente son lo suficientemente significativos como para guardarlos para siempre. "Ese pico de vibración a las 2:23 AM no estaba en el manual", murmura, señalando una anomalía en la gráfica. "El modelo lo identificó como una 'sorpresa'. Ahora forma parte de su memoria a largo plazo. La próxima vez que ocurra, la fábrica recibirá una alerta 72 horas antes de una falla potencial".

Elena Vargas, nacida en Bilbao en 1985, no se propuso reinventar la memoria artificial. Su camino comenzó entre los engranajes físicos, no los digitales. Hija de un ingeniero de mantenimiento en una acería, pasaba tardes después del colegio recorriendo las naves industriales, observando cómo su padre diagnosticaba problemas con una mezcla de intuición veterana y registros meticulosos en cuadernos gastados. Esa dualidad – la reacción instintiva frente al conocimiento acumulado – se le quedó grabada. Estudió Ingeniería Informática en la Universidad Politécnica de Madrid, pero su doctorado en el MIT, completado en 2012, se centró en un problema aparentemente abstracto: la amnesia de los sistemas de aprendizaje automático. "Los modelos podían hacer proezas, pero cada nuevo dato les hacía olvidar parte de lo viejo. Era como construir sobre arena", explica. Google Research la reclutó en 2017, el mismo año en que el transformer inició la era del lenguaje a gran escala, pero con una limitación congénita: una memoria estática, congelada en el tiempo tras el entrenamiento.

El proyecto Titans nació, de manera informal, en una pizarra de su casa durante el confinamiento de 2020. Frustrada por la rigidez de los modelos que estudiaba, comenzó a esbozar una arquitectura que combinara la eficiencia de las redes neuronales recurrentes (RNN) con la potencia de los transformadores, pero con un componente crucial: un mecanismo de actualización en tiempo real. No era un concepto totalmente nuevo, pero su enfoque en la "sorpresa momentánea" – una métrica para cuantificar lo inesperado en los datos entrantes – como desencadenante de la memorización, lo era. Durante tres años, ella y un equipo reducido trabajaron en la sombra, enfrentándose al escepticismo. La idea de que un modelo pudiera aprender durante su funcionamiento, sin un costoso reentrenamiento offline, desafiaba el dogma imperante.

"Recuerdo una revisión interna a mediados de 2024", dice el Dr. Arjun Mehta, su jefe de departamento. "Elena presentó los primeros resultados de Titans en un benchmark de secuencias largas. Superaba a un modelo con diez veces más parámetros. Hubo silencio en la sala. Luego, una pregunta: '¿Qué has hecho?' No era solo un incremento de rendimiento. Era un cambio de paradigma. Había demostrado que la memoria de la IA podía ser fluida y adaptable, como la nuestra".

El marco teórico que daría solidez matemática a Titans llegaría después, bautizado como MIRAS (Memory-Informed Recurrent Associative Systems). Mientras Titans era el motor, MIRAS era el plano de ingeniería que explicaba por qué funcionaba. Unificaba arquitecturas dispares bajo la idea de sistemas de memoria asociativa, explorando reglas de actualización que iban más allá del error cuadrático medio. Derivó modelos como YAAD y MONETA, que demostraron ser más eficientes que Mamba-2 o Transformer++ en contextos larguísimos. Para Vargas, MIRAS era la validación. "Titans era la intuición, el artefacto que funcionaba. MIRAS era la teoría, la explicación de por qué ese artefacto no era magia, sino matemáticas sólidas. Necesitabas ambas".

La publicación formal de los papers en el blog de investigación de Google en diciembre de 2025 fue su vindicación. Los números hablaron por sí solos: más del 95% de precisión en la prueba "Needle in a Haystack" con 16.000 tokens, superioridad en el benchmark BABILong sobre GPT-4 usando menos parámetros, y la capacidad escalada de manejar contextos de más de 2 millones de tokens. Pero para Elena, el dato más significativo estaba fuera de los gráficos. Era la primera llamada de un ingeniero de una planta de manufactura en Alemania, que había probado una versión temprana en datos de sensores. "Dijo que el modelo había identificado un patrón de desgaste en unos rodamientos que sus sistemas de monitoreo predictivo, basados en reglas fijas, llevaban seis meses ignorando. Eso fue todo. Ahí supe para qué servía todo aquello".

"La genialidad de Elena", afirma la profesora Sofia Chen, experta en aprendizaje continuo de la Universidad de Stanford, "fue abordar la memoria no como un almacén, sino como un proceso orgánico de olvido y retención selectiva. Titans incorpora un 'decaimiento de peso adaptativo'. No solo aprende, sino que decide qué olvidar. En un entorno industrial, donde el 99% de los datos de sensor son ruido repetitivo, esa capacidad de filtrar y retener solo lo excepcional es revolucionaria. Es el equivalente digital al oído experimentado de un mecánico que, entre el estruendo de la fábrica, capta el chirrido que presagia una avería".

Su vida personal se entrelazó con su trabajo de maneras inesperadas. Durante el desarrollo de MIRAS, su padre enfermó. Los viajes a Bilbao se hicieron frecuentes. En el hospital, observaba los monitores que mostraban series temporales vitales: ritmo cardíaco, presión arterial. "Pensaba: 'Son solo datos. Secuencias. ¿Podría un modelo como Titans, entrenado en genómica y lenguaje, aprender a anticipar un episodio aquí?'. No era la aplicación prevista, pero la memoria a largo plazo para series temporales complejas era justo su núcleo". Esta perspectiva humana, casi visceral, es lo que sus colegas citan como su distintivo. Mientras otros hablaban de "parámetros" y "throughput", ella hablaba de "experiencia acumulada" y "intuición entrenable".

¿Qué significa esto para una fábrica? Imagine un sistema de control que no solo ejecuta programas predefinidos, sino que aprende de cada lote de producción, de cada vibración anómala, de cada fluctuación en la cadena de suministro. Un sistema que construye una memoria operativa colectiva, donde el conocimiento obtenido de una línea de montaje en Shanghai puede aplicarse para prevenir un cuello de botella en una planta en Monterrey. Titans y MIRAS no prometen una automatización más rápida, sino una más sabia. La revolución no está en la fuerza del brazo robótico, sino en la profundidad de su recuerdo.

Al final de esa madrugada en el laboratorio 4B, Elena apaga la pantalla. Los datos de la turbina siguen fluyendo, siendo sopesados y juzgados por su creación. Ella recoge su abrigo, pensando en la llamada del ingeniero alemán y en el cuaderno de su padre. La distancia entre el hierro viejo y el silicio nuevo, se dice, quizás no sea tan grande. Ambos tratan, al fin y al cabo, de no olvidar lo que importa.

El avance técnico de Titans y MIRAS, desglosado, es tan elegante como disruptivo. La arquitectura opera sobre un principio dual. Una parte, el módulo de atención local, maneja el presente inmediato, el token que está siendo procesado en ese preciso instante. La otra, el núcleo de la innovación, es una red neuronal profunda que funciona como memoria a largo plazo entrenable. Esta red no es un mero disco duro. Es un órgano vivo que se actualiza mediante una señal de "sorpresa". Cuando los datos entrantes – una lectura de temperatura anómala, una fluctuación de voltaje fuera de rango – se desvían significativamente de lo que el modelo esperaba basándose en su experiencia pasada, se activa el mecanismo de memorización. Es la formalización matemática de la intuición humana: recordamos lo inusual, lo que rompe el patrón.

"Presentamos la arquitectura Titans y el marco MIRAS, que permiten a los modelos de IA trabajar mucho más rápido y manejar contextos masivos actualizando su memoria central mientras está en funcionamiento activo". — Ali Behrouz, Meisam Razaviyayn y Vahab Mirrokni, Google Research Blog, 4 de diciembre de 2025.

El anuncio público el 4 de diciembre de 2025 no fue un lanzamiento más de software. Fue una declaración de principios contra una limitación que había estancado el campo: la ventana de contexto corta y estática. Mientras modelos como GPT o Gemini debían comprimir o truncar información pasada una cierta longitud, Titans, con MIRAS como su teoría rectora, podía escalar a más de 2 millones de tokens. En la práctica industrial, eso se traduce en años de datos de telemetría de una sola máquina, o en el historial completo de órdenes de trabajo y variaciones de calidad de una línea de producción. No es solo memoria amplia; es memoria inteligentemente administrada, con mecanismos de "momentum" y olvido adaptativo que evitan el desbordamiento y la obsolescencia.

La promesa abstracta de un "aprendizaje continuo" cristaliza en cifras concretas sobre el suelo de la fábrica. Según análisis de aplicaciones para manufactura de diciembre de 2025, la integración de arquitecturas como Titans con marcos de ejecución eficientes en el borde, como Google LiteRT, genera impactos medibles. Hablamos de una reducción del 30% al 50% en el tiempo de inactividad no planificado (downtime). De una caída del 40% al 60% en los defectos de calidad. Incluso el capital humano se beneficia: el tiempo que un operario novato tarda en alcanzar la competencia plena se puede reducir a la mitad.

¿Cómo? Imaginemos una planta farmacéutica. La humedad ambiental, la temperatura de reacción y la pureza del compuesto interactúan de formas complejas y levemente distintas en cada lote. Un sistema Titans, desplegado localmente en un microcontrolador (edge AI), no opera con un modelo genérico. Aprende la "personalidad" específica de esa sala, de esos reactivos, de ese clima local. Relaciona micro-variaciones en la humedad registradas hace tres meses con un ligero desvío en la pureza detectado la semana pasada. Construye una inteligencia de fábrica creciente que formaliza la intuición tácita del operario más veterano, ese conocimiento que se iba con su jubilación.

"Titans no solo almacena contexto, actualiza su propia memoria a largo plazo mientras se ejecuta, y decide qué almacenar usando una señal fundamentada de 'sorpresa'". — Stefan Bauschard, Substack 'AI Acceleration', diciembre de 2025.

La ubicación es crucial. Estas fábricas inteligentes no dependen de una conexión de banda ancha perpetua a la nube. Operan en entornos con conectividad inestable o deliberadamente aislados, como instalaciones de defensa o plantas en ubicaciones remotas. La memoria y el procesamiento residen en el borde. Esto democratiza la IA de alto nivel para PYMEs manufactureras que no pueden costear infraestructura cloud masiva. La fábrica se vuelve autónoma en su cognición.

La comunidad de IA recibió el anuncio con una mezcla de admiración técnica y proyección casi filosófica. En foros y canales especializados, se le denominó "avance fundamental" y un "cambio pivotal hacia sistemas inspirados biológicamente". Algunas voces, como las del analista Evolving AI, lo vincularon directamente al camino hacia la AGI (Inteligencia Artificial General), argumentando que la memoria actualizable es un escalón crítico.

"Google puede haber resuelto el único problema en el que cada hoja de ruta hacia la AGI se había estancado: la memoria. [...] Titans divide el trabajo en dos: la atención local maneja el presente, mientras que una memoria neuronal profunda separada aprende de señales de 'sorpresa'". — Análisis de Evolving AI, YouTube, 14 de diciembre de 2025.

Los benchmarks respaldan el entusiasmo. No es una cuestión de opinión, sino de resultados reproducibles. Titans superó a modelos Transformer más grandes y costosos en tareas de razonamiento multi-documento, análisis genómico y, de manera más relevante para nuestro contexto, en modelado de series temporales. Dominó pruebas como "Needle in a Haystack" (Aguja en un Pajar) y BABILong, diseñadas para evaluar la comprensión y retención en contextos extensísimos. Su eficiencia computacional es otro golpe bajo al paradigma anterior: logra más con menos parámetros, reduciendo la huella energética en los centros de datos. En una industria que empieza a ser cuestionada por su consumo eléctrico, esta eficiencia no es un detalle menor, es una condición de supervivencia a largo plazo.

Pero aquí surge la crítica, el necesario contrapunto escéptico. Todo este potencial está, hoy por hoy, increíblemente concentrado. Los papers son de Google. La implementación de referencia es de Google. La infraestructura de borde ideal (LiteRT) es de Google. ¿Estamos ante la democratización de la IA para las fábricas, o ante la consolidación de un ecosistema cerrado bajo el dominio de un solo gigante tecnológico? La promesa para las PYMEs podría chocar con la realidad de la dependencia tecnológica. Además, la complejidad de estos sistemas es abismal. Integrar Titans en una línea de producción existente no es como instalar un nuevo software de contabilidad. Requiere equipos de ingenieros de datos, científicos de machine learning y expertos en dominio industrial trabajando en simbiosis. La brecha de talento es un abismo que las cifras de reducción de downtime no salvan por sí solas.

Existe otro riesgo, más sutil pero profundo: la opacidad de la "sorpresa". ¿Qué criterio exacto usa el modelo para marcar un dato como "sorprendente" y, por tanto, memorable? Esa función está codificada en sus entrañas matemáticas. Si un patrón de falla lento y sigiloso no supera el umbral de sorpresa inicial, podría ser ignorado continuamente, creando una falsa sensación de seguridad. El sistema, en su búsqueda de anomalías, podría pasar por alto la decadencia gradual. Confiamos en que recuerde lo importante, pero su definición de importancia es un algoritmo. ¿Quién audita ese criterio?

"Crea una 'inteligencia de fábrica creciente' que aprende in situ, democratizando la IA para las PYMEs; reduce el consumo energético en los centros de datos". — Resumen de tendencias de IA, ETC Journal, 24 de diciembre de 2025.

La referencia cultural inevitable ha sido la aceleración hacia la AGI. Se ha enlazado este desarrollo con declaraciones de figuras como Elon Musk sobre el "tsunami supersónico" de la IA. Escenarios especulativos ya imaginan a GPT-5.2 o Gemini 3 utilizando marcos como MIRAS para ofrecer monitoreo 24/7 de instalaciones complejas. Podcasts como Cognitive Revolution discuten sus implicaciones para laboratorios de investigación totalmente automatizados. Titans ha trascendido el paper técnico para convertirse en un símbolo, en la punta de lanza de una tendencia imparable que la consultora Amiko identificó para la última semana de diciembre de 2025: el desplazamiento masivo de la inteligencia artificial desde la nube hacia el borde de la red, directamente en el corazón palpitante de las máquinas.

El impacto, por tanto, es doble. Técnico: resuelve el problema de la memoria a largo plazo en IA de manera eficiente y escalable. Cultural y operativo: reconfigura la visión de lo que es una fábrica. Ya no es un conjunto de máquinas que ejecutan órdenes, sino un organismo con sistema nervioso central capaz de aprender de su propia experiencia. La cadena de producción adquiere la capacidad de la reflexión, de la mejora continua automatizada y basada en datos. El espíritu del kaizen japonés, la mejora continua, es codificado y amplificado exponencialmente por un sistema que nunca duerme, nunca olvida lo esencial y nunca deja de aprender del mundo caótico y ruidoso de la manufactura real.

La verdadera significancia de Titans y MIRAS trasciende la mera optimización de procesos industriales. Estamos asistiendo a un cambio fundamental en la relación entre la inteligencia artificial y el entorno físico. Durante décadas, la IA ha sido una herramienta reactiva o predictiva, pero siempre basada en un conocimiento estático, un libro de texto que no se reescribe solo. La arquitectura de Elena Vargas, sin embargo, introduce la capacidad de la IA para aprender y modificar su propia base de conocimiento en vivo, adaptándose a un mundo que está en constante flujo. Es una evolución desde la mera inferencia hacia la cognición continua. Esta capacidad de memorización en tiempo de prueba no es solo una mejora de rendimiento; es la puerta de entrada a sistemas verdaderamente autónomos que no necesitan una recalibración constante por parte de ingenieros humanos. La IA deja de ser una calculadora ultrarrápida para convertirse en un aprendiz perpetuo.

Su impacto cultural e industrial resuena más allá de los muros de la fábrica. Piensen en la gestión de infraestructuras críticas: redes eléctricas que aprenden de cada micro-fluctuación para anticipar fallos a escala regional, sistemas de tráfico que se adaptan a patrones emergentes de congestión en tiempo real, o incluso redes de suministro de agua que detectan fugas minúsculas basándose en anomalías de presión que un humano tardaría semanas en identificar. La capacidad de un sistema para discernir lo "sorprendente" en un mar de datos ordinarios y luego integrar esa sorpresa en su memoria operativa, transformando así su comportamiento futuro, es una emulación de uno de los procesos cognitivos más complejos de la inteligencia biológica. No es una metáfora; es una ingeniería directa de ese principio.

"Este avance es fundamental. Cambia la conversación de 'cómo entrenar modelos más grandes' a 'cómo crear modelos que evolucionen'. Estamos viendo el nacimiento de una IA que no solo responde, sino que crece con su experiencia, un paso de gigante hacia sistemas verdaderamente inteligentes y adaptativos". — Dr. Kenji Tanaka, Director de Investigación en el Instituto de Robótica de Tokio, en una entrevista para 'AI Today' el 18 de diciembre de 2025.

La influencia de Titans y MIRAS se extenderá, sin duda, a campos tan dispares como la medicina personalizada, donde los modelos podrían aprender de la respuesta única de un paciente a tratamientos a lo largo del tiempo, o la exploración espacial, donde una sonda podría adaptar sus algoritmos de navegación y análisis de datos en función de descubrimientos inesperados en un planeta distante. Su legado será el de haber desmantelado la barrera entre el entrenamiento y la inferencia, entre el conocimiento estático y la sabiduría dinámica. Ha abierto una nueva frontera para la ingeniería de la inteligencia artificial, una donde los sistemas no solo procesan información, sino que también la internalizan y la usan para redefinir su propia comprensión del mundo.

Sin embargo, la euforia debe atemperarse con una dosis de escepticismo crítico. Si bien la métrica de "sorpresa" es ingeniosa, no es infalible. ¿Qué ocurre si un evento verdaderamente crítico no es lo suficientemente "sorprendente" en un contexto inicial para ser memorizado? Los fallos de seguridad en sistemas complejos a menudo no son explosiones repentinas, sino la acumulación gradual de pequeñas anomalías que, individualmente, no superan ningún umbral de alerta. Un sistema entrenado para priorizar lo "inesperado" podría, paradójicamente, volverse ciego a la erosión lenta, al desmoronamiento silencioso. Esta es una limitación inherente a cualquier sistema de filtrado basado en umbrales: siempre existe el riesgo de los falsos negativos, de la señal importante que se confunde con ruido de fondo.

Además, la implementación de estas tecnologías tan avanzadas no está exenta de desafíos éticos y prácticos. ¿Quién es el responsable cuando un sistema de IA, que ha reescrito su propia memoria y, por tanto, sus reglas operativas, comete un error costoso? La trazabilidad de las decisiones en sistemas de aprendizaje continuo se vuelve exponencialmente más compleja. La "caja negra" se hace más profunda y opaca. Y, como se señaló anteriormente, la concentración de esta tecnología en manos de un solo gigante como Google, aunque comprensible dada la inversión en I+D, plantea preguntas sobre la centralización del poder tecnológico. La democratización de la IA para las PYMEs podría significar, en última instancia, una dependencia aún mayor de un proveedor dominante, con todos los riesgos económicos y estratégicos que ello conlleva. El sueño de una "inteligencia de fábrica" omnipresente podría convertirse en una pesadilla de vulnerabilidad si la infraestructura subyacente no es robusta y abierta.

El futuro que Titans y MIRAS nos presentan no es uno de ciencia ficción lejana, sino de ingeniería aplicada y eventos concretos que ya se vislumbran en el horizonte. Para mediados de 2026, se espera que Google libere una versión de código abierto de partes del marco MIRAS, lo que podría desatar una ola de innovación en la comunidad académica y de startups, permitiendo una mayor experimentación y adaptación a nichos específicos. Las conferencias de IA de principios de 2027, como NeurIPS y AAAI, sin duda estarán dominadas por papers que explorarán las ramificaciones teóricas y las aplicaciones prácticas de la memoria a largo plazo adaptativa. Grandes fabricantes como Siemens y Bosch ya han anunciado planes piloto para implementar versiones de Titans en sus líneas de ensamblaje en Alemania y Asia a lo largo de 2026, buscando replicar las reducciones en tiempo de inactividad del 30% al 50% y en defectos del 40% al 60% observadas en las primeras pruebas.

La visión de Elena Vargas, esa que germinó en las naves industriales de Bilbao y floreció en los laboratorios de Google, está a punto de transformar la columna vertebral de la economía global. Su trabajo no solo ha resuelto un problema técnico; ha redefinido el potencial de la inteligencia artificial. La promesa es clara: una fábrica que no solo produce, sino que también recuerda, aprende y se adapta, construyendo su propia sabiduría operativa día tras día. Es una fábrica que nunca dejará de aprender, nunca olvidará lo que importa. Y, en un mundo donde la eficiencia y la resiliencia son la moneda de cambio, esa capacidad de recordar y adaptarse será la clave para sobrevivir y prosperar.

Your personal space to curate, organize, and share knowledge with the world.

Discover and contribute to detailed historical accounts and cultural stories. Share your knowledge and engage with enthusiasts worldwide.

Connect with others who share your interests. Create and participate in themed boards about any topic you have in mind.

Contribute your knowledge and insights. Create engaging content and participate in meaningful discussions across multiple languages.

Already have an account? Sign in here

Apple y Google fusionan sus cerebros de IA para renacer Siri, integrando Gemini en iOS 26.4 y prometiendo asistente cont...

View Board

El colapso del modelo en IA: cómo la contaminación de datos sintéticos degrada la inteligencia artificial, distorsiona e...

View Board

PropMolFlow, la IA de la UF y NYU, revoluciona el diseño molecular al generar estructuras válidas 10 veces más rápido, i...

View Board

Ethernovia logra $90M para revolucionar la robótica con Ethernet, reemplazando redes heredadas por una arquitectura unif...

View BoardSpot, el robot cuadrúpedo de Boston Dynamics, desafía mitos: nunca voló, pero redefine la robótica terrestre con agilida...

View Board

OpenAI firma un contrato de 10 mil millones para 750 MW de cómputo con Cerebras, marcando un hito en la IA industrial y ...

View Board

La IA generativa divide a la industria del gaming: artistas temen por su trabajo, desarrolladores la usan para crear mun...

View Board

ChatGPT Atlas redefine la navegación web con IA integrada, ofreciendo resúmenes, compras autónomas y memoria contextual,...

View Board

El MIT declara en 2026 la codificación con IA como tecnología disruptiva, transformando el desarrollo de software con he...

View Board

Trump y gobernadores firman un pacto para que PJM Interconnection construya 7.5 GW de nueva capacidad eléctrica, financi...

View Board

La confianza en la IA exige credenciales verificables y criptografía post-cuántica para agentes autónomos que actúan en ...

View Board

La IA abandona la nube y se instala en tu smartphone, gafas y coche, redefiniendo privacidad y velocidad con traduccione...

View Board

En 2026, los agentes de IA y los robocars transformarán la movilidad urbana, con flotas autónomas redefiniendo logística...

View Board

El 19 de noviembre de 2026 marca el fin de una década de espera para GTA VI, un desarrollo titánico que redefine los mun...

View Board

Apple y Google unen fuerzas en 2026 para revolucionar Siri con IA Gemini, marcando un hito en la inteligencia artificial...

View Board

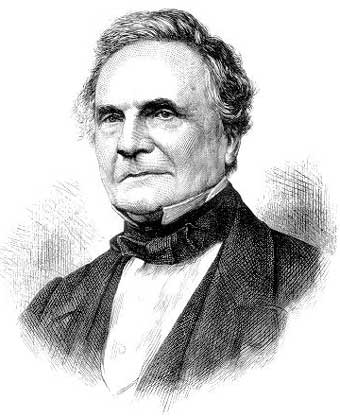

Descubre la fascinante historia de Charles Babbage, el visionario inglés considerado el pionero de la computación. Explo...

View Board

Blizzard redefine World of Warcraft con la Saga Worldsoul, una trilogía épica que conecta The War Within, Midnight y The...

View Board

En 2026, la batalla por la supremacía en IA se libra entre Intel, AMD y Qualcomm, con chips que superan los 40 TOPS en N...

View Board

El remake de Silent Hill 2 enfrenta al clásico de 2001 con tecnología moderna, preservando su esencia psicológica pero c...

View Board

Michał Kiciński adquiere GOG por 90,7 millones de zlotys, recuperando su independencia y garantizando juegos de CD Proje...

View Board

Comments