Explore Any Narratives

Discover and contribute to detailed historical accounts and cultural stories. Share your knowledge and engage with enthusiasts worldwide.

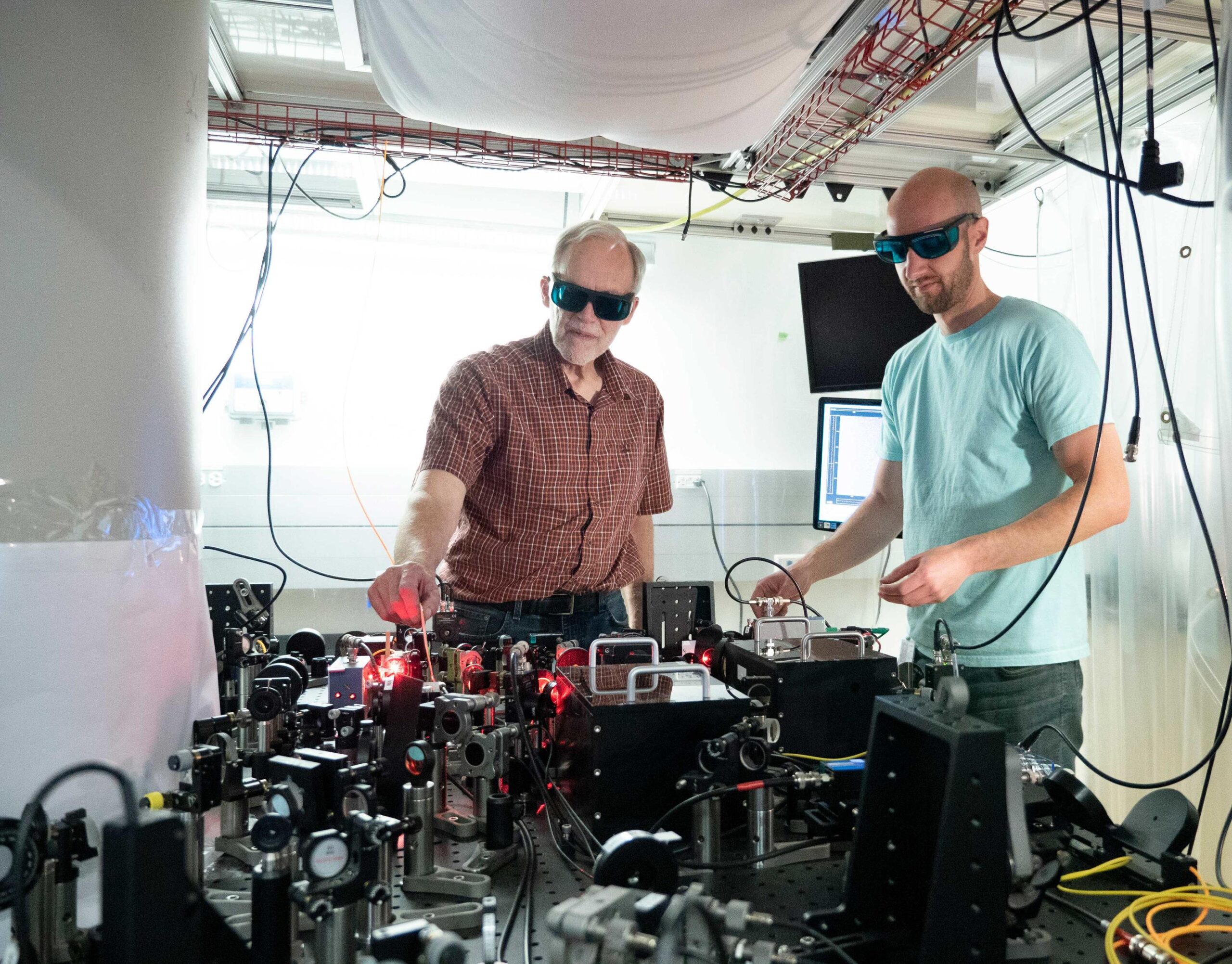

Il laboratorio è freddo, silenzioso, punteggiato solo dal ronzio degli impianti di raffreddamento. In una camera a vuoto, intrappolati da fasci di luce laser, centinaia di atomi di rubidio sospesi nel nulla oscillano tra lo stato di 0 e 1, e una combinazione di entrambi. È qui, in questa foresta di fotoni e campi magnetici, che si gioca una partita epocale. L'obiettivo non è solo leggere quell'oscillazione, ma preservarla dalla costante, brutale aggressione della realtà. Il rumore termico, le vibrazioni infinitesime, le imperfezioni del metallo: tutto cospira per cancellare il più fragile stato della materia. Per vincere, bisogna costruire un castello logico così resiliente da sopravvivere al crollo delle sue stesse mura fisiche. La corsa per costruire computer quantistici scalabili e corretti dagli errori è una storia di fisica estrema, ingegneria implacabile e una manciata di menti che stanno riscrivendo le regole.

Al centro di questa storia non c'è un solo volto, ma un principio: la correzione quantistica degli errori (QEC). Senza di essa, ogni calcolo quantistico ambizioso è destinato a dissolversi nel caos. I qubit fisici sono fragili, effimeri. I qubit logici—entità astratte protette dall'errore—devono essere forgiatti. Per anni, la via maestra è sembrata quella dei surface code, un approccio che richiede migliaia di qubit fisici per custodirne uno solo logico. Una prospettiva dispendiosa, che rischiava di rendere il traguardo della tolleranza ai guasti un miraggio lontano decenni.

Poi, nel 2024, il panorama è cambiato. Improvvisamente.

La pubblicazione su Nature dei codici bivariate bicycle (BB) da parte di IBM ha agito come un detonatore. Quei codici, appartenenti alla famiglia dei Low-Density Parity-Check quantistici (qLDPC), promettevano di impacchettare l'informazione logica con un'efficienza dieci volte superiore. Dove i surface code richiedevano una folla di qubit fisici come scorta, i codici BB di IBM ne chiedevano molti meno. Il codice [[144,12,12]]—288 qubit fisici per codificarne 12 logici—non era solo un teorema elegante. Era un progetto per un nuovo hardware. La comunità ha reagito con uno scetticismo trasformato in citazioni: oltre 200 in meno di due anni, un fiume di interesse accademico che ha travolto le vecchie certezze.

“I codici qLDPC non sono più una curiosità teorica. Sono il progetto per la prossima generazione di processori quantistici. La riduzione dell'overhead è l'unica leva che abbiamo per raggiungere la scala utile prima del 2030”, ha dichiarato il direttore della ricerca su architetture fault-tolerant di IBM Quantum.

Ma la teoria, da sola, non basta. Il vero banco di prova è la decodifica degli errori in tempo reale. Un sistema di migliaia di qubit genera un fiume ininterrotto di dati di sindrome—segnali che indicano dove il rumore ha colpito. Interpretarli e correggerli istantaneamente è un problema di calcolo classico di proporzioni mostruose. La risposta di IBM si chiama Relay-BP decoder: un algoritmo che promette di essere da cinque a dieci volte più veloce dei decodificatori leader, abbastanza compatto da risiedere su un FPGA accanto alla criogenia del processore. È il classico esempio di co-design: l'hardware e il software devono evolversi insieme, in un abbraccio simbiotico, o il sistema collasserà sotto il peso dei propri dati.

Mentre IBM perfezionava i codici, a Mountain View un altro colosso prendeva una strada diversa, ma complementare. Il team di Google Quantum AI, nel dicembre 2024, ha svelato i risultati del processore Willow e dei suoi dynamic surface codes. L'innovazione non stava nel codice in sé, ma nella sua implementazione. Hanno abbandonato la griglia rettangolare tradizionale per un reticolo esagonale, aumentando la connettività tra i qubit. Hanno reso i circuiti dinamici, capaci di adattare le operazioni in base a ciò che misuravano, bypassando attivamente i qubit guasti—le cosiddette "dropout".

Il risultato? Un miglioramento del 15% nella soppressione degli errori e la dimostrazione che i tassi di errore potevano scendere al di sotto della soglia teorica critica. Il loro obiettivo dichiarato è spietato: raggiungere meno di un errore logico ogni milione di cicli. Un numero che, se raggiunto, trasformerebbe il calcolo da rumoroso a affidabile.

“La staticità era il nostro peggior nemico. I qubit falliscono, è un dato di fatto. La domanda è: il tuo sistema se ne accorge e sa aggirarli? Con i circuiti dinamici, stiamo insegnando alla macchina a guarire se stessa in tempo reale”, ha spiegato un ingegnere capo del team Willow, in un briefing tecnico riservato.

Queste non sono più solo simulazioni. Sono esperimenti eseguiti su dispositivi reali, con qubit reali che si guastano in modi reali. Questo passaggio dal regno della pura matematica al laboratorio sporco di elio liquido segna il vero inizio della corsa.

I giganti non sono soli. Un ecosistema di startup sta esplorando architetture radicalmente diverse, scommettendo che la scalabilità arriverà da piattaforme alternative. QuEra, nata da un incubatore di Harvard, ha fatto parlare di sé a settembre 2025 con l'Algorithmic Fault Tolerance (AFT). Il loro campo di battaglia sono gli atomi neutri, raffreddati e intrappolati in array ottici. La promessa dell'AFT è ridurre drasticamente il numero di cicli di correzione necessari, sfruttando le proprietà intrinseche degli atomi per proteggere l'informazione. Un calcolo che con metodi tradizionali avrebbe richiesto un anno, con AFT potrebbe teoricamente completarsi in cinque giorni. È un cambio di paradigma: non solo correggere l'errore, ma progettare l'algoritmo per essere naturalmente robusto.

Poco più in là, Infleqtion ha raggiunto un traguardo simbolo nel 2025: la prima dimostrazione pubblica su un dispositivo reale di qubit logici che effettivamente superano in prestazioni i qubit fisici che li compongono. È il Santo Graal della QEC: la prova che l'incapsulamento logico funziona. La loro roadmap punta a passare da dozzine a centinaia di qubit logici protetti entro il 2030. Sono numeri che iniziano a sfiorare la soglia della "utilità", il momento in cui una macchina quantistica potrebbe risolvere problemi di ottimizzazione o di chimica al di là della portata di qualsiasi supercomputer classico.

E dall'Asia, a gennaio 2026, è arrivato un contributo che ha sorpreso per la sua eleganza matematica. Un team di Science Tokyo ha pubblicato su npj Quantum Information un metodo basato sul "hashing bound", il limite teorico di accuratezza per la correzione d'errore. La loro tecnica elimina gli errori intrinseci alla computazione stessa, raggiungendo un'efficienza quasi teorica con una velocità tale da non richiedere potenza di calcolo classica proibitiva. È un approccio che punta dritto al cuore del problema: la massima precisione con il minimo sforzo.

Il ritmo è febbrile. Ogni trimestre porta un nuovo paper, un nuovo risultato sperimentale, una nuova roadmap aggiornata. La sensazione tra i ricercatori è di essere sull'orlo di una transizione di fase. Stanno passando dalla fisica dei singoli qubit all'ingegneria di sistemi complessi. Stanno imparando a domare il caos, un fotone alla volta.

Ma cosa guida queste persone? Cosa spinge un ingegnere a passare mesi a ottimizzare un algoritmo di decodifica per guadagnare millesimi di secondo, o un fisico a cercare il punto esatto in cui un atomo cessa di oscillare per colpa del rumore del mondo? La risposta forse sta non nella grandiosità della meccanica quantistica, ma nella sua implacabile fragilità. Costruire qualcosa di utile da qualcosa di così fondamentalmente instabile è una sfida che tocca l'orgoglio professionale più profondo. È una forma di pura, ostinata creazione contro le leggi statistiche dell'entropia. Il castello logico deve reggere. E qualcuno, in un laboratorio freddo e silenzioso, sta posando l'ultimo mattone teorico prima che l'alba del calcolo utile sorga.

Dicembre 2024. Nei laboratori di Google Quantum AI, un processore di nome Willow ha fatto qualcosa che per due decenni era rimasto confinato nei libri di testo: ha spinto l'operazione di correzione degli errori al di sotto della soglia critica. Quel traguardo, apparentemente astratto, è il punto di non ritorno dell'intero campo. Significa che la robustezza di un qubit logico inizia ad aumentare in modo esponenziale per ogni qubit fisico aggiunto al sistema. Non è più una lotta contro il moltiplicarsi del rumore, ma la prima, tangibile prova che l'ingegneria può battere la fisica del caos. Il metodo? Una rielaborazione radicale dei surface code attraverso circuiti dinamici che permettono di scambiare i ruoli dei qubit "dati" e "misura" su un reticolo esagonale.

"Utilizzando circuiti dinamici, possiamo realizzare la correzione degli errori con un circuito che scambia periodicamente il ruolo dei qubit 'dati' e 'misura'. Questo non è solo un trucco di cablaggio; è un cambio di filosofia operativa." — Team di Ricerca, Google Quantum AI.

Il miglioramento simulato nel fattore di soppressione degli errori è stato del 15%. Una cifra che in qualsiasi altro settore tecnologico potrebbe sembrare modesta. Qui, dove ogni decimale di affidabilità si paga con anni di lavoro, è un balzo da gigante. Parallelamente, a Cambridge, un team di Harvard lavorava su un fronte completamente diverso. A gennaio 2026, con un array di 448 qubit atomici di rubidio intrappolati otticamente, hanno raggiunto lo stesso risultato fondamentale: sopprimere gli errori al di sotto di quella soglia magica. La loro architettura a atomi neutri ha impiegato una sinfonia di tecniche avanzate—teletrasporto quantistico per la diagnosi in tempo reale, circuiti stratificati, una tecnica di "rimozione dell'entropia". Due strade, una conclusione: la barriera teorica può essere infranta nella pratica.

Per comprendere la portata di questi risultati, bisogna tornare alle aspettative crudeli dei primi tempi. La soglia teorica per una correzione degli errori efficace era stata fissata a un'accuratezza di gate del 99,9999%—sei nove dopo la virgola. Nel 2019, durante la celebre dimostrazione della supremazia quantistica di Google, i gate a due qubit viaggiavano a un 99,5%. La distanza tra il 99,5 e il 99,9999 era un abisso apparentemente incolmabile. La corsa degli ultimi anni non è stata solo per costruire più qubit, ma per renderli infinitamente più precisi. Scott Aaronson, teorico di riferimento, traccia una linea netta: "Nel corso dell'ultimo anno, il nuovo stato dell'arte è l'accuratezza del 99,9%".

Un miglioramento di quattro decimi di punto percentuale. Potrebbe sembrare nulla. Invece, è tutto. Perché contemporaneamente, i progressi teorici nella progettazione dei codici hanno abbassato la soglia stessa richiesta. È una doppia leva: i qubit fisici diventano meno peggio, e i codici logici diventano più intelligenti nel gestire quel "meno peggio". L'obiettivo si avvicina non per un miracolo singolo, ma per un lento, metodico stringere la morsa su tutti i fronti. La domanda è: questa progressione lineare di miglioramenti incrementali basterà a raggiungere la scala utile, o ci vorrà un'altra rivoluzione nell'architettura stessa dei qubit?

Mentre i laboratori di Google e Harvard lavoravano sul silicio e sugli atomi, a Tokyo un gruppo guidato dal Professor Associato Kenta Kasai affrontava il problema da una prospettiva puramente matematica. La loro ricerca, pubblicata all'inizio del 2026, non riguardava un nuovo qubit fisico, ma un nuovo meccanismo di correzione degli errori che si avvicina estremamente al limite teorico assoluto: il limite di hashing. Questo limite rappresenta l'efficienza ultima possibile per un codice correttore; per anni è stato un faro irraggiungibile.

Il metodo di Tokyo ha una caratteristica che lo rende potenzialmente dirompente: la velocità di calcolo della correzione. In molti schemi, il tempo computazionale classico necessario per decodificare gli errori esplode al crescere del sistema, diventando un collo di bottiglia insormontabile. L'approccio del team giapponese promette che questo tempo "aumenta appena" con la scala. Se confermato e integrato nell'hardware, sarebbe l'equivalente di trovare un motore a curvatura per il processore classico che gestisce la QEC. Siamo di fronte a un paradosso affascinante: la parte "classica" del computer quantistico sta diventando il campo di una battaglia algoritmica altrettanto feroce di quella fisica.

"Il nostro meccanismo elimina gli errori intrinseci alla computazione stessa, avvicinandosi al limite di hashing con un overhead computazionale minimo. Non stiamo solo correggendo il rumore; stiamo riprogettando il calcolo per essere intrinsecamente più puro." — Prof. Associato Kenta Kasai, Institute of Science Tokyo.

Questa ondata di innovazione teorica si sta concretizzando in strumenti universali. Ricercatori hanno sviluppato un framework basato sulla teoria del gruppo stabilizzatore applicabile a qualsiasi codice, dai semplici codici a cinque qubit ai complessi surface code ruotati. Questi schemi raggiungono il limite superiore teorico di performance per tutti i codici testati—un traguardo di generalità ed eleganza. Segnala una maturazione del campo: non si cerca più il codice miracoloso, ma si costruisce un toolkit matematico per estrarre il massimo da qualsiasi architettura hardware.

La narrativa pubblica è ossessionata dalla correzione degli errori, il livello più alto e costoso. Ma la ricerca d'avanguardia, come quella condotta alla Northwestern University, delinea una strategia più sfumata e pragmatica: una gerarchia a tre livelli di gestione del caos quantistico. Al primo gradino c'è la soppressione degli errori: ottimizzare la compilazione dei circuiti, controllare con precisione maniacale i laser e le microonde. È il lavoro oscuro dell'ingegnere.

Il secondo livello è il più dinamico e promettente per il prossimo futuro: la rilevazione e mitigazione degli errori. Qui, il sistema classico monitora costantemente il processo quantistico, identifica un errore quando si verifica e intraprende un'azione correttiva senza necessariamente ricorrere alla piena potenza della QEC. Richiede una co-elaborazione classica strettamente integrata, ma promette di estendere la profondità dei circuiti utili già oggi, con l'hardware imperfetto che abbiamo.

"La rilevazione degli errori ci permette di fare qualcosa di profondamente pratico: rilevare gli errori e intraprendere azioni basate su ciò. È un passo intermedio cruciale prima della correzione completa, che richiede l'overhead più elevato." — Ricercatori, Northwestern University Quantum Lab.

Il terzo livello, la correzione vera e propria, rimane l'obiettivo finale. Ma questa visione gerarchica smaschera una verità scomoda per gli evangelisti più accesi: i computer quantistici non saranno mai macchine autonome. Avranno sempre, come un parassita vitale, un bisogno significativo di risorse di calcolo classico per decomporre i problemi e, appunto, correggere i propri errori. L'immagine del "computer quantistico" è fuorviante. Quello che stiamo costruendo è un ibrido simbiotico, dove la parte classica non è un semplice controllore, ma il sistema immunitario e una porzione sostanziale della corteccia cerebrale dell'intero organismo.

Le previsioni del settore per il 2026 sono unanimi nel dichiarare la correzione degli errori il "cuore pulsante dell'industria". Si parla dell'integrazione dei primi blocchi costruttivi tolleranti ai guasti, di tassi di errore migliorati, di architetture finalmente scalabili. Ma al di là dell'ottimismo di facciata, la strada è lastricata di scetticismo giustificato. La transizione dai risultati di laboratorio—con poche centinaia di qubit—a macchine con milioni di qubit logici necessari per applicazioni rivoluzionarie è un salto di diversi ordini di grandezza. I problemi di fabbricazione, di interconnessione, di alimentazione e raffreddamento diventano mostruosi.

L'approccio di co-design hardware-software è l'unica via praticabile. L'esempio di Google con i reticoli esagonali e circuiti dinamici lo dimostra: non puoi prima costruire un processore generico e poi sperare che il software risolva i suoi problemi. Il codice di correzione e l'architettura fisica devono essere progettati insieme, in un dialogo continuo. IBM spinge su questa linea con i suoi codici BB e i decoder FPGA-integrati. Ma questo richiede un livello di collaborazione tra discipline—fisica della materia condensata, teoria dell'informazione, ingegneria dei semiconduttori, scienza dei materiali criogenici—che non ha precedenti nella storia della tecnologia.

"La correzione degli errori quantistici smetterà di essere un campo di ricerca separato e diventerà la metrica primaria di valutazione di ogni piattaforma hardware. Non chiederemo più 'quanti qubit fisici hai?', ma 'qual è il tuo fattore di soppressione degli errori logici?'." — Analisti di Settore, The Quantum Insider.

Il rischio più grande per il 2026 non è il fallimento di un esperimento, ma l'emergere di un plateau ingegneristico. Potremmo assistere a una serie di successi incrementali su scale ridotte, mentre i problemi fondamentali della fabbricazione massiva di qubit identici e stabili rimangono irrisolti. La corsa si sta trasformando da una sfida di fisica fondamentale a una sfida di ingegneria di sistema su scala estrema. E la storia dell'ingegneria è piena di progetti perfetti sulla carta, naufragati sullo scoglio della manifattura industriale. I qubit di atomi neutri sono eleganti e flessibili, ma possiamo intrappolarne e controllarne dieci milioni in una camera a vuoto? I qubit superconduttivi sono veloci e compatibili con la litografia, ma possiamo produrre array di milioni di giunzioni Josephson senza un singolo punto debole? Queste sono le domande che bruciano, silenziose, dietro ogni annuncio trionfale. La soglia critica è stata superata in laboratorio. Ora bisogna superarla in fabbrica.

Il significato profondo di questa corsa trascende di gran lunga l'obiettivo di fattorizzare numeri grandi o simulare molecole. Ciò che si sta costruendo nei laboratori criogenici e nelle camere a vuoto è una nuova relazione con l'informazione stessa. Per secoli, abbiamo basato il calcolo sulla certezza binaria: un transistor acceso o spento, un bit a 0 o 1. Il mondo quantistico ci obbliga a trattare con la probabilità, la sovrapposizione e l'incertezza non come un difetto da eliminare, ma come la risorsa fondamentale. La correzione degli errori è il ponte tra questi due regni: è il meccanismo che ci permette di estrarre certezza logica dal caos fisico. Non è un'operazione tecnica. È un atto filosofico di imposizione dell'ordine.

L'impatto sull'industria è già palpabile. Le roadmap aziendali non sono più vaghe promesse, ma documenti tecnici dettagliati con metriche precise. Il 2026 sarà l'anno in cui la QEC cessa di essere un campo di ricerca accademico specializzato e diventa una competenza ingegneristica di base per chiunque voglia operare nello spazio quantistico. Le aziende farmaceutiche come Roche e Pfizer hanno già team dedicati a studiare le implicazioni per la scoperta di farmaci; le istituzioni finanziarie da JPMorgan Chase a Banca d'Italia scrutano gli algoritmi per l'ottimizzazione di portafoglio. Stanno aspettando, con scetticismo ma anche con una preparazione meticolosa, il momento in cui il "quantum utility" diventerà realtà.

"La correzione degli errori non è più una domanda di 'se', ma di 'quando' e 'quanto costa'. Sta trasformando il calcolo quantistico da un esperimento di fisica in un problema di ingegneria dei sistemi. E l'ingegneria ha un prezzo, un timeline e specifiche di progetto. Questo è il vero punto di svolta." — Direttore del Fondo Tecnologico, un importante fondo di venture capital europeo specializzato in deep tech.

La posta in gioco è il controllo su una nuova classe di problemi che definiscono la modernità: la progettazione di materiali per batterie ad alta densità, la catalisi per la cattura del carbonio, la logistica globale in un clima instabile. Sono problemi la cui complessità esponenziale schiaccia anche i più potenti supercomputer classici. Un computer quantistico tollerante ai guasti sarebbe la prima vera nuova macchina di calcolo generale dai tempi di Von Neumann. Il suo lascito non sarà solo una serie di pubblicazioni scientifiche, ma la capacità potenziale di affrontare sfide che oggi consideriamo intrattabili.

Per ogni annuncio trionfale, però, esiste un sottofondo di dubbi legittimi che la narrazione entusiasta spesso soffoca. Il primo è il problema dell'overhead classico. Anche i codici più efficienti, come i qLDPC di IBM, richiedono comunque un esercito di qubit fisici per supportarne uno logico. E ogni qubit fisico aggiunto non è solo un atomo o una giunzione Josephson; è un controllo criogenico, linee di microonde, sistemi di lettura. La complessità sistemica cresce in modo non lineare. C'è un reale rischio che costruire un sistema con migliaia di qubit logici risulti così costoso e energivoro da renderlo economicamente insostenibile per qualsiasi applicazione al di fuori di nicchie iper-specializzate.

La seconda criticità è il divario tra dimostrazione di principio e produzione industriale. Aver soppresso gli errori sotto la soglia con 448 qubit atomici è un capolavoro scientifico. Riprodurre quella stabilità in un sistema di 448.000 qubit, con tolleranze di fabbricazione accettabili, è un'impresa di un ordine di difficoltà completamente diverso. La storia dell'IA è piena di algoritmi rivoluzionari che hanno impiegato vent'anni a trovare l'hardware per esprimere il loro potenziale. Il quantum rischia lo stesso ritmo delusivo.

Infine, c'è l'iperbole del "computer quantistico generale". Gran parte della copertura mediatica dipinge una macchina che risolverà magicamente tutto. La realtà, anche nella più rosea delle previsioni, è che saranno macchine specializzate, ibride, che eccelleranno in una classe ristretta di problemi di ottimizzazione e simulazione quantistica. Il rischio è un ciclo di hype e delusione—un "inverno quantistico"—che potrebbe prosciugare gli investimenti proprio quando sono più necessari per la lunga, costosa fase di ingegnerizzazione.

Guardando avanti, il calendario è fitto di scadenze che separeranno i contendenti dai semplici partecipanti. Entro la fine del 2026, IBM ha dichiarato di voler dimostrare un circuito logico a 100 qubit protetto dai suoi codici BB su un processore a scale. Google punta a pubblicare i risultati del successore di Willow, con l'obiettivo dichiarato di avvicinarsi a quel traguardo di < 1 errore logico per milione di cicli. Microsoft, attraverso il suo Quantum Pioneers Program, finanzierà esperimenti su piattaforme di calcolo measurement-based che potrebbero bypassare completamente alcuni ostacoli delle architetture a gate.

La conferenza QIP 2027, già in fase di organizzazione, sarà il banco di prova. Non si ascolteranno più teorie eleganti, ma rapporti dettagliati su tassi di errore, stabilità temporale, yield di fabbricazione e costi per qubit logico. I fondi di venture capital monitoreranno questi dati con la stessa attenzione con cui si analizzano i bilanci aziendali. Le prime applicazioni commerciali in ambito chimico e farmaceutico potrebbero emergere già nel 2028, non come soluzioni miracolose, ma come strumenti di screening complementari in grado di esplorare spazi chimici inaccessibili ai metodi classici.

La corsa, quindi, entra in una fase nuova. Non è più una gara per un singolo risultato, ma una maratona di stabilizzazione, integrazione e riduzione dei costi. Torniamo a quel laboratorio freddo, al ronzio degli impianti di raffreddamento. L'atomo di rubidio è ancora lì, sospeso, oscillante tra lo stato di 0 e 1 e una combinazione di entrambi. Ma ora, attorno a quel frammento di incertezza, è stato costruito un intero universo logico di protezione. Un castello di codici, circuiti dinamici e algoritmi di decodifica che sussurra all'atomo: "Resisti". Il successo non sarà misurato dalla bellezza del castello, ma dal fatto che, un giorno, qualcuno potrà dimenticarsi completamente della fragilità dell'atomo al suo centro, e usare semplicemente la macchina. Quel giorno non è domani. Ma per la prima volta, è diventato una data sul calendario.

Your personal space to curate, organize, and share knowledge with the world.

Discover and contribute to detailed historical accounts and cultural stories. Share your knowledge and engage with enthusiasts worldwide.

Connect with others who share your interests. Create and participate in themed boards about any topic you have in mind.

Contribute your knowledge and insights. Create engaging content and participate in meaningful discussions across multiple languages.

Already have an account? Sign in here

Scopri la plastica biodegradabile ispirata al DNA che si autodistrugge, una rivoluzione scientifica per risolvere l'inqu...

View BoardScopri la straordinaria vita di Richard Feynman, fisico geniale e premio Nobel. Dalla bomba atomica alla nanotecnologia,...

View Board

HP e Dell presentano al CES 2026 innovazioni rivoluzionarie per non vedenti: EliteBoard G1, PC integrato in tastiera, e ...

View Board

Scopri il mistero del 95% invisibile dell'universo: materia ed energia oscura, le forze nascoste che plasmano il cosmo e...

View Board

Descubre el legado perdurable de Michael Faraday, el físico y químico cuyas revolucionarias invenciones en electromagnet...

View Board

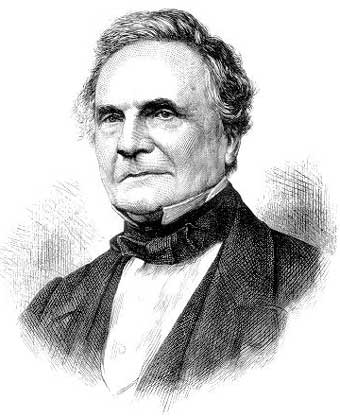

Descubre la fascinante historia de Charles Babbage, el visionario inglés considerado el pionero de la computación. Explo...

View Board

Scoperta rivoluzionaria: l'ammasso SPT2349-56, nell'universo adolescente, sfida i modelli cosmologici con un gas cinque ...

View Board

TESSERACT rivoluziona la caccia alla materia oscura ultraleggera con sensori quantistici criogenici, spingendo i limiti ...

View Board

CRISPR sta riscrivendo il destino genetico, da malattie rare a terapie personalizzate, ma solleva interrogativi etici e ...

View Board

Sistema operacional inovador da Haiqu mapeia e contorna ruídos de qubits NISQ, atraindo US$11M em financiamento para tor...

View Board

Los nuevos procesadores Ryzen AI 400 de AMD, con 50 TOPS y capacidad para modelos de 200 mil millones de parámetros, red...

View Board

La memoria dell'Olocausto migra online: archivi digitali, AI e realtà virtuale ridisegnano il ricordo, tra innovazione e...

View Board

Gli occhiali intelligenti hanno superato la fase pionieristica: oggi pesano meno di una mela, traducono in tempo reale e...

View Board

L'IA rivoluziona la medicina personalizzata: algoritmi analizzano dati genomici e clinici per terapie su misura, riducen...

View Board

Sebastian Will e sua equipe revolucionam a computação quântica com um disco de 3,5 mm que usa 360.000 pinças ópticas par...

View Board

A Amazon Leo, com mais de 3.200 satélites em órbita baixa, promete revolucionar a conectividade global até 2026, desafia...

View Board

CERN's Large Hadron Collider achieves alchemy, converting lead to gold via ultra-peripheral collisions, validating quant...

View Board

Em 1976, na garagem de Los Altos, Steve Jobs e Steve Wozniak deram início à Apple com uma placa-mãe vendida por US$ 666,...

View Board

Em 2026, a IA já não é uma ameaça futura, mas uma realidade que remodela riscos globais, superando até ciberataques em p...

View Board

ul researchers unveil paper-thin OLED with 2,000 nits brightness, 30% less power use via quantum dot breakthrough, targe...

View Board

Comments