Explore Any Narratives

Discover and contribute to detailed historical accounts and cultural stories. Share your knowledge and engage with enthusiasts worldwide.

Às 04:09 UTC do dia 19 de julho de 2024, um arquivo de configuração anômalo, identificado internamente como Canal 291, começou a ser distribuído pela rede global da CrowdStrike. Em minutos, uma cascata de telas azuis da morte (BSOD) varreu o planeta, paralisando aeroportos, hospitais, redes de televisão e escritórios financeiros. O que falhou não foi um hacker sofisticado, mas uma lógica de validação de software. Um simples "se" no código que deveria proteger 8,5 milhões de dispositivos Windows os tornou inoperantes. O incidente, resolvido em 78 minutos mas cujos efeitos duraram dias, não foi um ataque. Foi um espelho, e a imagem refletida foi a de uma infraestrutura digital global perigosamente interdependente e frágil.

A CrowdStrike, uma das gigantes da segurança cibernética, sustenta seu modelo no Falcon, um sensor instalado nos endpoints – os computadores das empresas. Para combater ameaças em tempo real, esse sensor recebe atualizações de configuração de forma contínua e automática a partir da nuvem da empresa. Naquela manhã de julho, o arquivo Canal 291 continha uma instrução malformada relacionada à avaliação de execução de named pipes, um mecanismo de comunicação entre processos no Windows. Um bug no software de validação da própria CrowdStrike permitiu que essa instrução defeituosa passasse pelos controles de qualidade e fosse empurrada para a frota global.

O resultado foi imediato e catastrófico. O driver do Falcon, que opera em um nível profundo e privilegiado do sistema operacional (o kernel), encontrou a instrução ilegível e travou. Quando um componente do kernel trava, o sistema operacional inteiro desaba. A tela azul, projetada como um último recurso para proteger a integridade do hardware, tornou-se a face de um apagão digital. O sistema foi projetado para confiar cegamente no seu protetor. E o protetor falhou.

Não foi uma brecha de segurança nem um ataque malicioso. Foi uma falha operacional em um processo de controle de qualidade. O arquivo continha um defeito que deveria ter sido detectado nos testes internos, mas o software de validação projetado para pegar exatamente esse tipo de erro também estava com defeito.

Segundo a análise técnica pública da CrowdStrike, publicada em 29 de julho de 2024.

A janela de exposição foi das 04:09 às 05:27 UTC – um espaço de 78 minutos. Para as máquinas que estavam online nesse período e executavam a versão 7.11 ou superior do sensor Falcon para Windows, o colapso foi inevitável. Sistemas Linux e macOS foram poupados, mas o domínio esmagador do Windows no ambiente corporativo garantiu um impacto máximo. Às 05:27 UTC, a CrowdStrike já havia emitido um arquivo de correção. O problema é que aplicar a correção em uma máquina que não consegue inicializar é um desafio de lógica perversa.

A solução exigia uma intervenção manual física ou remota: reiniciar o computador em Modo de Segurança do Windows (ou usar um disco de recuperação) e deletar manualmente o arquivo de driver problemático, o crowdstrike.sys. Para empresas com milhares de máquinas espalhadas por continentes, essa foi uma operação logística de guerra. Enquanto equipes de TI corriam contra o relógio, o mundo real entrava em paralisia. Dados da Bitsight revelam que, apenas em 19 de julho, 5.078 voos foram cancelados. Grandes companhias aéreas, como a Delta, ainda lutavam para normalizar operações dias depois, em 23 de julho. Transações financeiras congelaram, cirurgias foram adiadas e noticiários nacionais foram tirados do ar.

Vimos em tempo real o que acontece quando um único ponto de falha, localizado no coração da cadeia de fornecimento de segurança digital, se rompe. A dependência de uma tecnologia de um só fornecedor, por mais robusta que pareça, cria um vetor de risco sistêmico que vai muito além do ciberataque tradicional.

Afirma o analista de risco cibernético, Pedro Almeida, do Instituto de Estudos Estratégicos de Tecnologia.

A ironia é profunda. A CrowdStrike vende proteção contra a desordem – contra o caos deliberado causado por agentes mal-intencionados. Seu Falcon é um componente crítico da infraestrutura de zero trust (confiança zero) de milhares de empresas, uma filosofia que prega a desconfiança de qualquer entidade dentro ou fora da rede. No entanto, a arquitetura prática da solução exigia uma confiança absoluta e automática em seus próprios canais de atualização. O zero trust parou no limite do fornecedor.

A empresa serve mais de 24.000 clientes em todo o mundo, incluindo aproximadamente 60% das empresas da Fortune 500. Essa penetração global, um testemunho de sua eficácia, também foi o amplificador do desastre. A falha não estava na ideia de atualizações frequentes – essenciais para combater malwares de dia zero –, mas na ausência de circuitos de ruptura eficazes e na homogeneidade do ecossistema. Quando todos usam o mesmo guarda-costas e ele tem uma reação alérgica súbita, todos ficam desprotegidos ao mesmo tempo.

George Kurtz, CEO da CrowdStrike, fez um pronunciamento público de desculpas ainda no dia 19 de julho. A transparência técnica veio depois, com o relatório detalhado de causa raiz (RCA). A empresa colaborou com a Microsoft para fornecer ferramentas de recuperação, mas a opção de recuperação automatizada via cloud, por incrível que pareça, exigia que os clientes já tivessem optado anteriormente por esse serviço. A maioria não tinha. O conserto, portanto, dependia da antiquada e lógica intervenção humana, máquina por máquina.

Até 29 de julho, cerca de 99% dos sensores estavam operacionais novamente. Mas aquele 1% restante representava milhares de máquinas ainda isoladas, um lembrete de que em redes globais, a cauda longa do problema pode ser longa e dolorosa. A semana seguinte ao incidente teve flutuações normais na saúde dos sensores, mas o trauma operacional e financeiro já estava gravado. Um princípio básico da engenharia de confiabilidade, a redundância, havia sido ignorado em nome da eficiência e da integração perfeita. A nuvem, prometida como um modelo elástico e resiliente, revelou sua espinha dorsal centralizada e rígida.

Os números frios do prejuízo materializaram a abstração da falha técnica. Enquanto as equipes de TI lutavam contra telas azuis, o balanço financeiro de empresas inteiras tremia. A Delta Airlines emergiu como o caso mais emblemático do choque entre o digital e o físico. A companhia aérea calculou um impacto de US$ 500 milhões devido ao incidente e cancelou mais de 5.000 voos entre 19 e 25 de julho de 2024. A recuperação foi hercúlea. Segundo documentos judiciais relatados pela CNBC em agosto daquele ano, a Delta precisou redefinir e recuperar 40.000 servidores manualmente – uma operação de força bruta contra uma falha do século XXI.

A resposta legal foi imediata e agressiva. A Delta contratou o célebre litigante David Boies e moveu ações judiciais contra a CrowdStrike e a Microsoft. O argumento central era a falta de suporte adequado durante a crise. A CrowdStrike, em uma carta legal de resposta, assumiu uma postura defensiva, mas firme. Ela rejeitou de forma absoluta a interpretação da Delta sobre sua conduta.

“Estamos extremamente decepcionados com a sugestão da Delta de que a CrowdStrike agiu de forma inadequada e rejeitamos veementemente qualquer alegação de negligência grave ou má conduta intencional.”

— Trecho da carta legal da CrowdStrike, divulgado em agosto de 2024 e reportado pela CNBC.

Esse embate jurídico não é sobre um simples bug de software. Abre um precedente perigoso para toda a indústria de tecnologia. Se um fornecedor de software pode ser responsabilizado criminalmente por cada falha em seu processo de desenvolvimento, você inibe a inovação e encarece a segurança? Ou, pelo contrário, você força um nível de diligência que deveria ser padrão desde o início? A Delta comprou uma solução de segurança, não um seguro contra todas as falhas operacionais do fornecedor. Mas quando esse fornecedor se torna parte crítica da infraestrutura, a linha entre serviço e responsabilidade vital se desfaz.

Enquanto executivos e advogados trocavam acusações, uma outra frente de batalha se abria, mais silenciosa e insidiosa. A escuridão digital causada pelas telas azuis foi rapidamente preenchida por predadores. Cibercriminosos identificaram na confusão uma oportunidade de ouro para phishing e ataques de engenharia social.

Nas duas semanas seguintes ao apagão de 19 de julho, a empresa de segurança Akamai listou em seu repositório público no GitHub cerca de 200 domínios maliciosos registrados para explorar o pânico. Esses sites falsos usavam logos da CrowdStrike e da Microsoft, incorporavam termos como "helpdesk", "support" e "fix" em seus URLs e se passavam por portais oficiais de recuperação. A tática era simples e velha, mas renovada pela urgência do momento: oferecer uma solução falsa para o problema real que estava paralisando empresas.

Funcionários desesperados por uma maneira rápida de recuperar seus sistemas eram o alvo ideal. Um e-mail ou um resultado de busca prometendo "Correção oficial da CrowdStrike para erro BSOD" podia levá-los a um site que, em vez de fornecer um patch, instalava ransomware ou roubava credenciais de acesso.

"Aproveitadores estão enviando e-mails e fazendo chamadas se passando por suporte técnico da CrowdStrike, alegando falsamente que houve um 'ataque cibernético' e oferecendo serviços pagos ou acessos remotos para aplicar 'correções'."

— Alerta publicado pelo CyberPeace Institute em julho de 2024.

Essa segunda onda de danos é talvez a lição mais perturbadora do episódio. Uma falha operacional em uma empresa de segurança não apenas desarma os clientes, como ativa um mecanismo de autoamplificação do risco. O caos gerado pela falha principal vira terreno fértil para ataques secundários. A infraestrutura de defesa, já comprometida, não está lá para detectar esses novos vetores de invasão. A empresa fica cega e surda justamente quando mais precisa enxergar. O princípio da resiliência cibernética não fala apenas sobre se recuperar de um golpe, mas sobre permanecer defensável durante o processo de recuperação. Em julho de 2024, muitas organizações descobriram que estavam indefesas nesse intervalo crítico.

O alerta das autoridades foi unânime: acessar apenas os canais oficiais da CrowdStrike para instruções de recuperação. Mas em um cenário de pânico, com comunicação interna prejudicada e pressão dos gestores para normalizar as operações, o discernimento do funcionário individual é o elo mais fraco. A sofisticação técnica do ataque inicial foi zero. A sofisticação do ataque subsequente, também. O que falhou foi o ecossistema.

A pergunta que fica, depois da poeira dos processos e dos domínios de phishing baixar, é fundamental: por que tantos setores críticos dependiam de um único sensor para sua segurança? A resposta reside em uma confluência perversa de eficiência, marketing e comodidade. A CrowdStrike construiu um produto técnico superior em detecção de ameaças, que se integrava profundamente ao sistema operacional para oferecer visibilidade e proteção em tempo real. Essa mesma profundidade que o tornava eficaz o tornava um ponto único de falha catastrófica.

O setor de aviação, por exemplo, opera em margens apertadas e sob regulamentações de segurança rigorosas. Adotar uma solução líder de mercado, usada por concorrentes e endossada por auditorias, é uma decisão racional para um diretor de TI. Ninguém é demitido por comprar da líder do setor. Essa lógica, aplicada em escala global, criou uma monocultura. Uma monocultura de defesa. O paradoxo é evidente: para se proteger de ameaças diversificadas e adaptativas, o mundo corporativo padronizou sua primeira linha de defesa.

“O outage da CrowdStrike destacou a fragilidade inerente em depender excessivamente de soluções de terceiros baseadas em nuvem, sem estratégias robustas de backup e redundância. Os líderes de TI estão agora sendo forçados a repensar a resiliência como um pilar central, não um acessório.”

— Análise publicada pela World Insurance Associates no relatório “Global Tech Outage”.

A lição de arquitetura é clara. A confiança zero (zero trust) não pode terminar na porta do fornecedor. Ela precisa ser aplicada à própria stack de segurança. Isso significa arquiteturas heterogêneas, onde diferentes sensores de diferentes fornecedores vigiam não apenas as ameaças externas, mas também a saúde uns dos outros. Significa desacoplar atualizações críticas de kernel, criando mecanismos de rollback automático e instantâneo. Significa, acima de tudo, abandonar a ilusão de que a "nuvem" é um conceito abstrato e resiliente por natureza. A nuvem é feita de servidores físicos, de código escrito por humanos e de pipelines de distribução controlados por um punhado de empresas.

A Microsoft, parceira involuntária nesse drama, também sai com sua reputação arranhada. Apesar de não ser a origem da falha, a integração profunda do Windows com drivers de terceiros cria um vetor de risco sistêmico. O sistema operacional, a camada fundamental sobre a qual tudo é construído, se mostrou vulnerável a um componente externo com privilégios totais. A solução de recuperação conjunta foi um remendo de crise, não uma revisão arquitetural.

O que o episódio CrowdStrike reescreveu foi o contrato não dito entre fornecedores de tecnologia crítica e a sociedade. Quando seu software para de ser uma ferramenta e se torna uma utilidade pública – como a energia elétrica ou o controle de tráfego aéreo – os termos de responsabilidade mudam. O processo da Delta é a primeira tentativa de judicializar essa nova realidade.

O argumento da companhia aérea vai além do prejuízo contábil. É sobre a expectativa de resiliência. Ao contratar a CrowdStrike, a Delta não estava comprando apenas um antivírus avançado; estava comprando a promessa de que sua operação estaria protegida contra paralisias. Quando a solução de segurança se tornou a causa da paralisia, o contrato simbólico foi quebrado. A defesa da CrowdStrike se apoia na letra miúda dos acordos de serviço, que certamente limitam sua responsabilidade. Mas um juiz ou júri pode decidir que, para infraestrutura crítica, a letra miúda é moral e legalmente insuficiente.

"Esta não foi uma violação de dados no sentido tradicional, mas uma violação de confiança operacional. Os clientes confiaram que o guardião não trancaria as portas por dentro. A lição para qualquer CIO é que a diversificação da segurança não é uma despesa, é um seguro existencial."

— Declaração de uma analista sênior de risco cibernético ao site CoverLink, em um estudo de caso sobre o outage.

O caminho a seguir é mais complexo e caro do que o mercado gostaria. Exige duplicação de investimentos, sistemas de monitoramento cruzado e a aceitação de uma certa ineficiência em nome da robustez. É o oposto da otimização extrema que a computação em nuvem pregou na última década. A pergunta final é incômoda: estamos dispostos a pagar mais por um mundo digital menos eficiente, mas mais resiliente? O crash global de julho de 2024 pode não ter dado a resposta, mas tornou a pergunta inescapável para todo board de direção do planeta. Enquanto isso, os sensores Falcon, corrigidos e atualizados, continuam rodando em dezenas de milhões de máquinas, um testemunho silencioso de uma dependência que ninguém sabe realmente como quebrar.

A verdadeira importância do dia 19 de julho de 2024 não se mede apenas em voos cancelados ou milhões perdidos. Seu significado mais profundo reside em ter funcionado como um raio-X brutal da civilização digital. O episódio expôs, sem qualquer filtro, a tensão estrutural entre a complexidade necessária para o funcionamento moderno e a simplicidade exigida para sua confiabilidade. Uma empresa de segurança, por definição um componente de defesa, tornou-se, por algumas horas, um ator de risco sistêmico maior do que qualquer grupo de hackers. Essa inversão de papéis é o legado duradouro do incidente.

Culturalmente, o "Black Friday da TI" minou a fé cega na expertise técnica como um farol infalível. Executivos, passageiros, pacientes e telespectadores foram lembrados de que por trás de cada interface intuitiva e serviço em nuvem contínuo existe uma pilha de código mantida por pessoas que cometem erros. O mito da máquina perfeita foi substituído pela realidade do sistema complexo – e frágil. A dependência deixou de ser um conceito abstrato de TI e se tornou uma experiência visceral para boa parte da população adulta conectada.

"O outage da CrowdStrike não será lembrado como um problema da CrowdStrike. Será lembrado como o momento em que percebemos que nossa infraestrutura global tem um sistema imunológico único. E que quando esse sistema imunológico tem uma reação autoimune, não há um segundo sistema para contê-lo. É um problema de arquitetura civilizacional."

— Comentário do arquiteto de segurança cibernética, Dr. Fernando Costa, em painel do Fórum Econômico Mundial de setembro de 2024.

Para a indústria de tecnologia, o evento funcionou como um despertador regulatório. Agências governamentais nos Estados Unidos, União Europeia e países asiáticos já revisam diretrizes para software classificado como "crítico para a infraestrutura nacional". A discussão migrou da proteção de dados para a garantia de continuidade operacional. O foco não está mais apenas em se o software é seguro contra invasões, mas em se ele é seguro contra si mesmo. A pressão por padrões abertos de interoperabilidade e por mecanismos obrigatórios de rollback automático ganhou uma urgência política inédita.

Apesar das lições óbvias, uma crítica central persiste: a indústia falha em oferecer alternativas viáveis fora do modelo dominante. A solução pregada por muitos especialistas – diversificar fornecedores, implementar arquiteturas híbridas – ignora a realidade econômica e operacional da maioria das empresas. Os ecossistemas de segurança são projetados para integração profunda, não para coexistência superficial. Trocar de fornecedor é um processo caro, desgastante e arriscado que pode levar anos.

A própria CrowdStrike, após o incidente, não propôs uma revisão radical de seu modelo de atualização ou uma abertura de sua arquitetura para permitir monitoramento cruzado por concorrentes. Ela aperfeiçoou seus processos de teste e validação. Ou seja, dobrou a aposta no mesmo paradigma centralizado, apenas prometendo executá-lo com mais perfeição. Isso não é resiliência; é aprimoramento de um ponto único de falha. A crítica, portanto, não é só técnica, é de mercado. A consolidação extrema do setor de segurança em poucos atores globais criou uma ilusão de escolha onde, na prática, a adoção de um deles implica em uma dependência quase total.

Outro ponto cego nas análises pós-crise é a questão do custo. Construir redundância verdadeira, com sensores de múltiplos fornecedores e circuitos de ruptura independentes, exige duplicar ou triplicar investimentos em licenças, treinamento e operação. Para muitas organizações, o custo dessa resiliência parece maior que o risco de uma paralisia esporádica. O cálculo é racional no curto prazo e desastroso no longo. O outage de julho mostrou que o preço da falha – US$ 500 milhões para uma única companhia aérea – pode facilmente superar décadas de investimento em diversificação. Mas essa é uma conta feita depois do desastre.

O caminho a seguir é menos uma revolução tecnológica e mais uma mudança de mentalidade contratual. Espera-se que, até o final de 2025, os grandes contratos de fornecimento de software para infraestrutura crítica incluam cláusulas inéditas. Cláusulas que obriguem fornecedores a manterem canais de rollback automático e independentes da sua nuvem principal, que exijam a publicação de interfaces padrão para monitoramento de saúde por terceiros e que estipulem penalidades financeiras escalonadas não por violação de dados, mas por tempo de indisponibilidade causada por falhas do próprio fornecedor.

O futuro imediato será marcado por esses ajustes contratuais e por uma busca febril – e muitas vezes teatral – por "resiliência". Grandes conferências de cibersegurança agendadas para 2025, como a RSA Conference em maio em São Francisco e a Black Hat em agosto em Las Vegas, terão o tema "Architecting for Failure" como central. A previsão é concreta: veremos uma proliferação de novos fornecedores oferecendo soluções de "segurança para a segurança", ou seja, ferramentas para monitorar a saúde e a integridade dos principais agentes de defesa já instalados. Será um mercado novo, nascido diretamente do trauma de julho.

A cena final, porém, não está em um contrato ou em uma conferência. Está em uma sala de servidores qualquer, onde um único arquivo .sys, agora corrigido, ainda reside no kernel de milhões de máquinas. Sua presença é um lembrete silencioso de que a complexidade que nos sustenta é, por natureza, instável. A promessa da nuvem era a de uma abstração perfeita, um poder infinito e sem atrito. O que herdamos, na verdade, foi uma rede de dependências tão intricada que um erro em uma única linha de código, validada às 04:09 UTC, conseguiu escurecer, ainda que brevemente, o mundo. A pergunta que persiste, ecoando das telas azuis de 2024, não é se isso vai acontecer de novo. É quando. E se, da próxima vez, a recuperação ainda dependerá de um técnico, em modo de segurança, deletando um arquivo manualmente.

Your personal space to curate, organize, and share knowledge with the world.

Discover and contribute to detailed historical accounts and cultural stories. Share your knowledge and engage with enthusiasts worldwide.

Connect with others who share your interests. Create and participate in themed boards about any topic you have in mind.

Contribute your knowledge and insights. Create engaging content and participate in meaningful discussions across multiple languages.

Already have an account? Sign in here

Google LiteRT redefine IA em dispositivos pequenos, com execução local, baixa latência e eficiência energética em smartp...

View Board

A Amazon Leo, com mais de 3.200 satélites em órbita baixa, promete revolucionar a conectividade global até 2026, desafia...

View Board

Em 2026, a IA já não é uma ameaça futura, mas uma realidade que remodela riscos globais, superando até ciberataques em p...

View Board

Hytale débarque enfin le 13 janvier 2026 après 7 ans d'attente : découvrez ce que l'Early Access réserve aux joueurs et ...

View Board

2XKO: Riot Games lança jogo de luta 2v2 gratuito em PC/PS5/Xbox, unindo campeões de Runeterra em batalhas estratégicas e...

View Board

Em 1976, na garagem de Los Altos, Steve Jobs e Steve Wozniak deram início à Apple com uma placa-mãe vendida por US$ 666,...

View Board

Em 2026, o Dia de Martin Luther King Jr. celebra 40 anos como feriado federal, mas sua essência vai além da comemoração,...

View Board

Em 2025, os anéis de Saturno desapareceram temporariamente devido a um alinhamento geométrico raro, revelando segredos d...

View Board

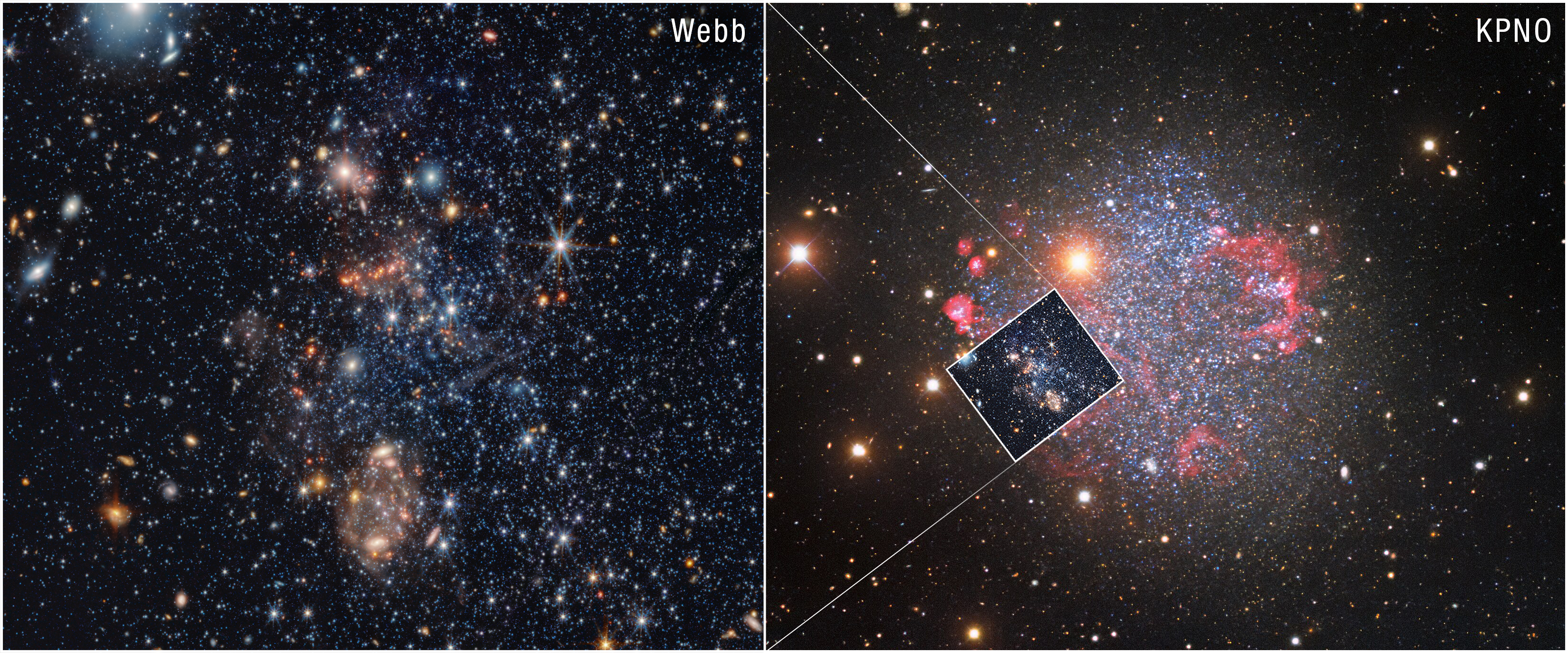

O JWST revela aglomerados de PAHs em Sextans A, desafiando teorias sobre a formação de poeira cósmica em galáxias pobres...

View Board

A Apple e o JPMorgan unem forças para redefinir o Cartão Apple, substituindo o Goldman Sachs em uma transição de US$ 20 ...

View Board

O Telescópio Hubble revela Nuvem-9, uma galáxia sem estrelas, confirmando teoria de halos de matéria escura e redefinind...

View Board

Em janeiro de 1776, um panfleto de 47 páginas mudou o rumo da história: "Common Sense" de Thomas Paine, um ataque direto...

View Board

A Guiné-Bissau mergulhou no caos em novembro de 2025, quando um golpe militar anulou a vitória eleitoral de Fernando Dia...

View Board

O Brasil redefine o futuro da energia com 95% de fontes renováveis até 2026, liderando a transição global com sol, vento...

View Board

Arqueólogos da Universidade de Tomsk investigam possível túmulo medieval sob o campus, onde pontas de lança sugerem pres...

View Board

La IA abandona la nube y se instala en tu smartphone, gafas y coche, redefiniendo privacidad y velocidad con traduccione...

View Board

Découvrez comment l'IA devient un collègue de travail en 2026, transformant les usines, les bureaux et les vignobles ave...

View Board

PropMolFlow, la IA de la UF y NYU, revoluciona el diseño molecular al generar estructuras válidas 10 veces más rápido, i...

View Board

A corrida para limpar o lixo espacial se tornou urgente após incidentes em 2025 que adiaram missões e expuseram riscos c...

View Board

El MIT declara en 2026 la codificación con IA como tecnología disruptiva, transformando el desarrollo de software con he...

View Board

Comments