L'Industrie Musicale en 2025 : Air d'Innovation et de Croissance

L'industrie musicale vit une transformation profonde, portée par une innovation technologique constante et de nouveaux modèles économiques. En 2025, le secteur repose sur une croissance significative et une personnalisation accrue de l'expérience auditive. Ce premier volet explore les fondements économiques de cette renaissance et les tendances majeures qui redéfinissent l'écoute et la création.

L'Économie Mondiale de la Musique : Une Ascension Solide

Les perspectives financières pour l'industrie musicale sont exceptionnellement positives. Selon des analyses récentes, les revenus globaux sont en passe de doubler d'ici la prochaine décennie. Cette expansion repose sur plusieurs piliers essentiels.

Une Projection de Revenus Doublés

Le marché mondial de la musique enregistrée et du spectacle vivant affiche une santé robuste. Les chiffres parlent d'eux-mêmes et illustrent une trajectoire ascendante claire.

Les revenus mondiaux de l'industrie devraient passer de 104,9 milliards USD en 2024 à près de 200 milliards USD d'ici 2035.

Cette croissance phénoménale sera alimentée par l'explosion des marchés émergents, la meilleure monétisation des superfans et la vitalité continue des concerts. Après un ralentissement de la croissance à 6,2% en 2024, les experts prévoient un rebond soutenu.

La Dynamique du Streaming et des Marchés Émergents

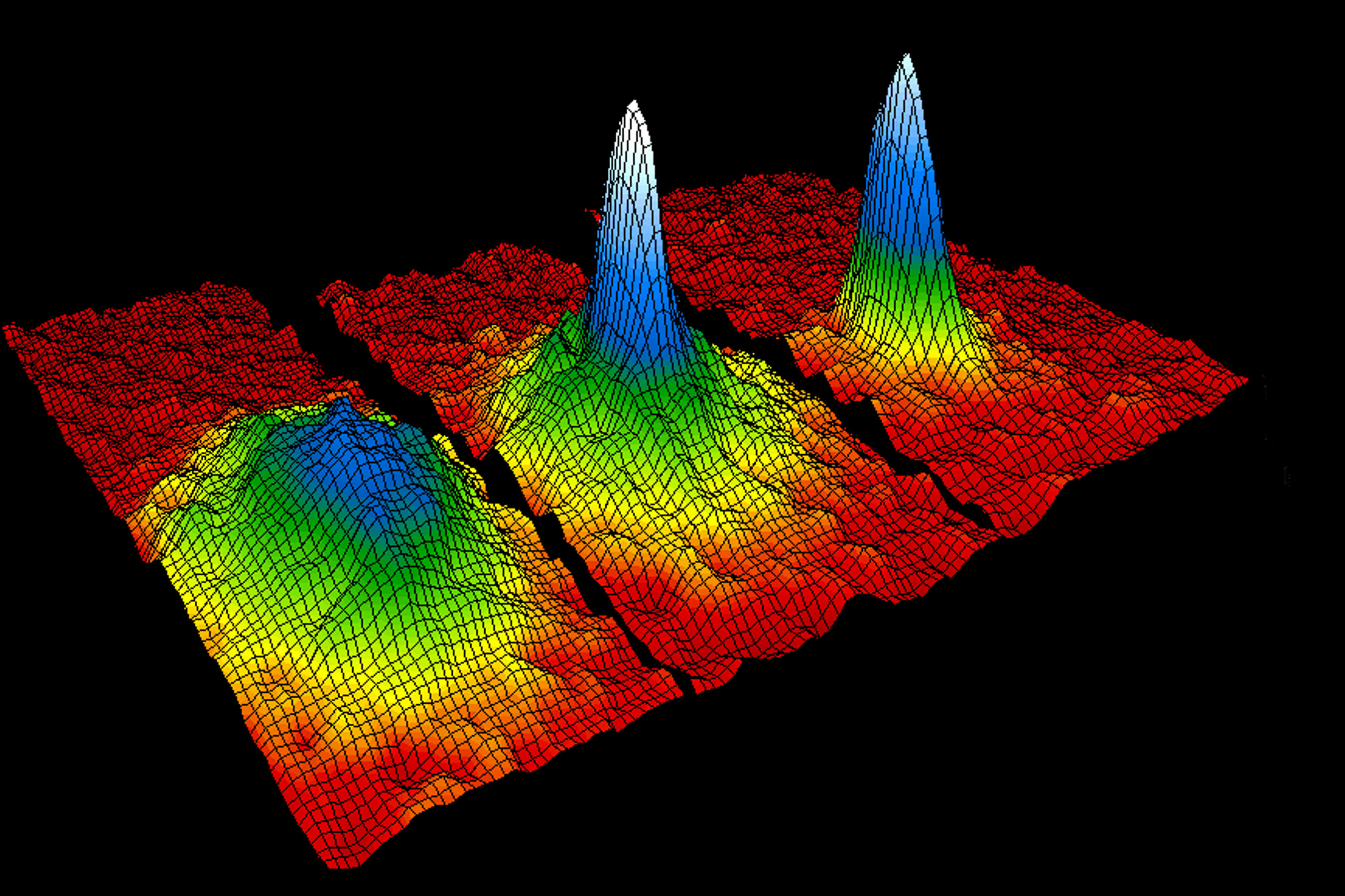

Le streaming reste le moteur principal, mais sa croissance se modère tout en se déplaçant géographiquement. Le nombre d'abonnés payants atteindra 827 millions en 2025, soit une augmentation de 10%.

- 750 millions d'abonnés en 2024.

- 827 millions d'abonnés prévus en 2025.

- Une croissance de 10%, bien que ralentie par rapport aux années précédentes.

La véritable révolution vient des marchés émergents. Ces régions représenteront 75% des nouveaux abonnés nets d'ici 2035, contre 57% en 2024. Cette expansion redessine la carte musicale mondiale.

Le Retour en Force de la Musique Live

Après les années de perturbation, le segment live connaît une renaissance spectaculaire. Les fans recherchent des expériences communautaires et inoubliables.

La croissance prévue pour 2025 est de 10% pour les revenus du live. Ce rebond suit une année 2024 déjà positive avec une croissance de 4,4%. Les concerts et festivals redeviennent des piliers économiques centraux pour les artistes et les labels.

Les Tendances Structurantes de 2025

Au-delà des chiffres, l'industrie se réinvente à travers plusieurs mouvements profonds. Ces tendances transforment la façon dont la musique est créée, distribuée et consommée.

L'Intelligence Artificielle : Personnalisation et Création

L'IA n'est plus un concept futuriste mais un outil opérationnel quotidien. Elle révolutionne tous les maillons de la chaîne, de la découverte à la consommation.

La curation et la découverte deviennent hyper-personnalisées. Les algorithmes suggèrent des morceaux non seulement par genre, mais selon l'humeur, le contexte ou l'activité de l'auditeur. Des plateformes comme Spotify annoncent le lancement de services premium comme "Music Pro" en 2025.

Ce service ciblera les superfans avec des fonctionnalités exclusives : remixes générés par IA, accès prioritaire aux billets et streaming en audio haute fidélité. L'IA façonne une expérience musicale sur mesure.

La Fusion des Genres et l'Ère des Microgenres

Les catégories traditionnelles comme le rock ou la pop s'estompent au profit de sons hybrides et de niches très spécifiques. Cette tendance est amplifiée par les réseaux sociaux et les plateformes de découverte.

- L'hyperpop et le future rave gagnent en popularité.

- Le drill et ses déclinaisons locales se mondialisent.

- Les A&R recherchent désormais ces sons hybrides plus que des artistes par genre.

Des applications comme TikTok rendent les étiquettes obsolètes en propulsant des microgenres éphémères. Pour les artistes, cette réalité impose une grande agilité créative.

La Production Démocratisée : Mobile et Hybride

La création musicale n'a jamais été aussi accessible. Les barrières techniques tombent, permettant à une nouvelle génération de producteurs d'émerger.

Des applications comme GarageBand ou Koala Sampler permettent une production complète sur smartphone. Parallèlement, les workflows hybrides combinent la chaleur des équipements analogiques avec la précision et la flexibilité du numérique.

Ce mouvement démocratise la création et diversifie les profils des artistes à succès. La qualité professionnelle est désormais à la portée de tous.

Les Nouveaux Modèles d'Engagement et de Monétisation

Face à la saturation numérique, l'industrie développe des stratégies innovantes pour fidéliser les audiences et générer de nouvelles sources de revenus. La relation directe avec le fan est au cœur de cette évolution.

La Stratégie Direct-to-Fan et l'Ère des Superfans

Les artistes cherchent à reprendre le contrôle de leur relation avec leur audience. La dépendance aux algorithmes des réseaux sociaux pousse vers des plateformes de communication directe.

Ces plateformes direct-to-fan permettent aux créateurs de posséder leurs données d'audience, de monétiser via des abonnements et des contenus exclusifs. Elles facilitent la construction de communautés immersives et fidèles.

La monétisation des superfans devient une priorité stratégique. Il s'agit de ces auditeurs dévoués, prêts à payer un premium pour un accès privilégié, du contenu inédit ou des expériences uniques.

Le Sync Licensing et le World-Building Immersif

La synchronisation (utilisation de musique dans des films, publicités ou jeux vidéo) offre des débouchés croissants et une exposition massive. C'est aussi un outil de promotion puissant pour les nouveaux talents.

Au-delà du simple placement, les artistes et labels développent désormais un monde immersif autour des œuvres musicales. Ce world-building intègre récits visuels, expériences en réalité augmentée et contenus transmedia pour fidéliser les fans sur le long terme.

Ces stratégies transforment un single en point d'entrée vers un univers artistique complet et engageant.

Le Streaming Évolutif : Live et Haute Définition

Le streaming audio évolue vers plus d'interactivité et de qualité. Deux tendances se démarquent : le streaming d'événements en direct et l'audio haute résolution.

Les plateformes proposent de plus en plus de concerts exclusifs et de collaborations en temps réel, via des services comme Twitch. Parallèlement, la demande pour un son parfait augmente.

Les offres lossless et hi-res se généralisent sur Apple Music, TIDAL et bientôt d'autres. Ces évolutions répondent à l'exigence croissante des audiophiles et des superfans.

Les Stratégies Pricing et la Segmentation des Audiences

La monétisation de la musique évolue vers une segmentation plus fine des publics. Les plateformes et les artistes développent des offres tarifaires variées pour maximiser les revenus. Cette approche cible spécifiquement les différents niveaux d'engagement des auditeurs.

Les Nouveaux Tiers d'Abonnement pour les Superfans

Afin de mieux capter la valeur des auditeurs les plus engagés, de nouveaux paliers d'abonnement premium font leur apparition. Ces offres vont bien au-delà du simple accès sans publicité au catalogue.

- Offres hi-fi et audio haute résolution à un tarif supérieur pour les audiophiles.

- Services incluant des billets prioritaires pour les concerts et des expériences VIP.

- Accès à du contenu exclusif comme des remixes, versions alternatives et documentaires.

Spotify, avec son futur service "Music Pro", incarne cette tendance. L'objectif est clair : transformer l'engagement émotionnel en valeur économique durable.

La Croissance Soutenue du Modèle Ad-Supported

Parallèlement aux abonnements payants, le streaming financé par la publicité conserve une croissance robuste. Il reste la porte d'entrée pour de nombreux nouveaux utilisateurs.

Le segment ad-supported devrait afficher un taux de croissance annuel composé (CAGR) de 5,7% entre 2025 et 2030.

Ce modèle est essentiel pour élargir la base d'utilisateurs totale, certains convertis plus tard en abonnés payants. Les publicités deviennent également plus ciblées et moins intrusives.

L'Impact Régional : La Montée des Marchés Émergents

La géographie de l'industrie musicale se redessine rapidement. La croissance future est largement portée par des régions hors des marchés traditionnels occidentaux. Ces marchés apportent de nouvelles sonorités et habitudes de consommation.

L'Asie, l'Amérique Latine et l'Afrique comme Moteurs de Croissance

Alors que les marchés nord-américains et européens montrent des signes de maturation, d'autres régions explosent. Leur classe moyenne croissante et la pénétration mobile accélèrent l'adoption du streaming.

La part des marchés émergents dans les nouveaux abonnés nets est un indicateur clé. Elle passera de 57% en 2024 à 75% d'ici 2035. Cette domination numérique impose une adaptation des stratégies globales.

- Adaptation des catalogues aux goûts musicaux locaux.

- Prix d'abonnement ajustés au pouvoir d'achat local.

- Partenariats avec des opérateurs télécoms pour des forfaits bundles.

Les États-Unis Conservent leur Leadership en Valeur

Si les marchés émergents dominent en volume, les États-Unis restent le marché le plus lucratif au monde. Leur part dans les revenus mondiaux est prépondérante.

En 2024, les États-Unis représentaient 40,3% des revenus mondiaux de l'industrie musicale, avec une croissance de 2,1%.

Ce marché mature continue d'innover en termes de modèles d'affaires et de consommation. Il sert souvent de laboratoire pour des tendances ensuite déployées globalement.

L'Innovation Technologique au Service de la Création

La technologie ne transforme pas seulement la distribution, elle révolutionne aussi la création artistique. Les outils accessibles et puissants permettent à une nouvelle génération de talents d'émerger.

La Production Entièrement Mobile

Il est désormais possible de composer, d'enregistrer, de mixer et de masteriser une chanson entièrement sur un smartphone. Cette démocratisation ouvre la création à tous.

Des applications comme GarageBand sur iOS ou Koala Sampler offrent des fonctionnalités autrefois réservées à des studios professionnels. Les musiciens peuvent capturer l'inspiration à tout moment et en tout lieu.

- Banques de sons intégrées et instruments virtuels de qualité.

- Interfaces tactiles intuitives conçues pour la mobilité.

- Collaboration en cloud pour travailler à distance avec d'autres artistes.

Les Workflows Hybrides Analogique-Numérique

À l'opposé de la production 100% numérique, un mouvement hybride gagne du terrain. Il combine le meilleur des deux mondes pour un son unique.

Les producteurs cherchent la chaleur et le caractère des équipements analogiques (synthétiseurs, tables de mixage). Ils les intègrent à la précision et la flexibilité du numérique (plugins, édition non destructive).

Cette approche permet de créer des paysages sonores riches et personnalisés. Elle répond à une quête d'authenticité et de singularité dans un paysage musical saturé.

Le Rôle Crucial de la Synchronisation (Sync Licensing)

L'utilisation de musique dans les films, séries, publicités et jeux vidéo est devenue un pilier économique majeur. C'est une source de revenus vitale et un puissant outil de découverte.

Une Source de Revenus et de Visibilité

Un placement réussi dans une production à gros budget peut générer des droits substantiels. Surtout, elle offre une exposition massive à un public nouveau et diversifié.

Les superviseurs musicaux recherchent des sons originaux qui renforcent l'émotion d'une scène. Cette quête bénéficie aux artistes émergents ou de niche dont la musique apporte une couleur unique.

Le sync licensing n'est plus perçu comme une simple transaction, mais comme une stratégie de promotion à part entière.

La Montée en Puissance des Musiques de Jeux Vidéo

L'industrie du gaming est devenue un acteur majeur du sync. Les bandes-son originales et les placements within-game représentent un marché en pleine expansion.

- Concerts virtuels organisés dans des jeux comme Fortnite.

- Collaborations entre artistes populaires et franchises de jeux.

- Création de stations de radio fictives intégrant de la musique réelle dans les jeux en monde ouvert.

Cette fusion des médias crée des expériences de divertissement immersives. Elle positionne la musique au cœur de l'univers du joueur.

L'Avenir de l'Expérience Live et Numérique

La frontière entre le concert physique et l'expérience digitale s'estompe. L'avenir réside dans des formats hybrides qui étendent la portée et l'impact des performances.

Les Concerts Hybrides et le Streaming Live

La pandémie a accéléré l'adoption du streaming live, et cette tendance est là pour rester. Les artistes ne le voient plus comme un pis-aller, mais comme un canal complémentaire.

Il permet de toucher des fans du monde entier incapables d'assister à un concert physique. Les plateformes comme Twitch et les technologies comme JackTrip permettent des collaborations en temps réel entre musiciens géographiquement dispersés.

Ces performances sont souvent monétisées via un système de billetterie numérique, des dons ou un accès payant. Elles deviennent un revenu additionnel stable.

Vers une Expérience Sensorielle Totale

Le futur du live, qu'il soit physique ou digital, vise l'immersion totale. Il ne s'agit plus seulement de son, mais d'une expérience multisensorielle.

- Réalité virtuelle (VR) et augmentée (AR) pour créer des décors et effets visuels impossibles en réel.

- Audio spatialisé (Dolby Atmos) pour une sensation d'environnement sonore en 3D.

- Interactivité permettant au public d'influencer le déroulement du spectacle.

L'objectif est de créer des souvenirs émotionnels si puissants qu'ils transforment les spectateurs occasionnels en superfans dévoués.

Les Défis Structurels et les Opportunités Futures

Malgré une croissance robuste, l'industrie musicale doit naviguer plusieurs défis structurels. Ces obstacles nécessitent une adaptation constante pour assurer une expansion durable et équitable.

La Saturation Numérique et la Découverte Algorithmique

La quantité astronomique de musique publiée chaque jour rend la découverte de nouveaux talents extrêmement difficile. Les algorithmes des plateformes dominent cette curation.

Cette dépendance pose un risque pour la diversité artistique. Les artistes sont incités à créer des musiques adaptées aux codes algorithmiques plutôt que portées par une vision purement artistique.

- Concentration de la visibilité sur un petit nombre de playlists éditoriales.

- Homogénéisation potentielle des sons pour plaire aux algorithmes.

- Difficulté pour les niches et les genres expérimentaux de trouver leur public.

La réponse à ce défi passe par les stratégies direct-to-fan et le développement de communautés engagées hors des grandes plateformes.

La Répartition des Revenus et la Rémunération des Artistes

La question de la rémunération équitable reste centrale. Bien que les revenus globaux augmentent, la part revenant aux créateurs, surtout émergents, est souvent jugée insuffisante.

Les nouveaux modèles comme les communautés de fans payantes et les niveaux d'abonnement premium visent à augmenter directement la part des artistes.

L'industrie explore des mécanismes de redistribution plus transparents et plus favorables. L'accent est mis sur la monétisation de l'engagement profond plutôt que sur les micro-paiements par stream.

L'Industrie Musicale en 2035 : Projections et Scénarios

En extrapolant les tendances actuelles, il est possible d'esquisser les contours de l'industrie dans une décennie. Les scénarios des analystes pointent vers une transformation encore plus profonde.

Un Marché Mondial de 200 Milliards de Dollars

La projection la plus marquante concerne la taille globale du marché. L'industrie devrait atteindre une envergure historique grâce à plusieurs leviers simultanés.

Le doublement des revenus pour atteindre 200 milliards USD d'ici 2035 repose sur trois piliers : l'explosion des marchés émergents, la monétisation optimisée des superfans, et l'expansion continue du segment live et expérientiel.

- Les marchés émergents deviendront les principaux moteurs de croissance en volume.

- Les superfans représenteront une part disproportionnée des revenus.

- Les expériences hybrides (physique/digital) deviendront la norme.

La Consolidation Technologique et la Personnalisation Extrême

L'intelligence artificielle et le big data vont remodeler chaque interaction avec la musique. La personnalisation deviendra hyper-contextuelle et prédictive.

Les assistants musicaux basés sur l'IA composeront peut-être des musiques uniques en temps réel pour accompagner votre journée. La frontière entre artiste humain et algorithme créatif pourrait continuer de s'estomper, soulevant des questions éthiques et juridiques inédites.

La découverte sociale et algorithmique s'intégrera de manière transparente dans tous les aspects de la vie numérique. La musique deviendra un compagnon encore plus intelligent et adaptatif.

Conclusion : Une Renaissance Portée par l'Innovation et le Fan

L'industrie musicale de 2025 et au-delà est à un tournant historique. Elle se réinvente en plaçant l'innovation technologique et la relation fan-artiste au cœur de sa stratégie de croissance.

Synthèse des Tendances Clés

Plusieurs forces majeures redéfinissent actuellement le paysage musical. Leur convergence crée un environnement dynamique et riche en opportunités.

- Croissance économique solide : Le marché mondial est sur une trajectoire de doublement, porté par les marchés émergents et de nouveaux modèles de revenus.

- Centralité du Superfan : La monétisation de l'engagement profond via des offres tierces et du contenu exclusif devient un pilier économique essentiel.

- Révolution de la Création : La démocratisation des outils de production et l'hybridation analogique/numérique permettent une explosion de la diversité créative.

- Expérience Immersive : L'avenir du live est hybride, combinant performances physiques, streaming interactif et technologies immersives (VR/AR).

- Personnalisation par l'IA : L'intelligence artificielle affine la découverte et permet des expériences d'écoute ultra-personnalisées et contextuelles.

Les Clés du Succès pour les Artistes et les Labels

Dans cet écosystème en mutation, les acteurs qui prospéreront seront ceux qui sauront s'adapter. Plusieurs stratégies se distinguent comme étant déterminantes.

La construction d'une communauté directe et engagée est primordiale. Posséder la relation avec ses fans via des plateformes dédiées offre indépendance et stabilité.

L'agilité créative pour naviguer entre les genres et les formats est cruciale. Les artistes doivent être prêts à expérimenter avec de nouveaux sons et modes d'expression.

L'industrie de demain appartiendra à ceux qui maîtrisent à la fois l'art du storytelling musical et la science de l'engagement communautaire.

Enfin, l'adoption d'une mentalité pluridisciplinaire est nécessaire. La musique n'est plus un produit isolé mais le cœur d'un univers narratif incluant visuels, expériences live et interactions digitales.

Regard Final : L'Air d'une Nouvelle Ère

L'air de l'industrie musicale en 2025 est chargé d'optimisme et d'électricité créative. Après des années de disruption numérique, le secteur a trouvé un nouvel équilibre dynamique.

Il ne s'agit plus simplement de vendre des albums ou des streams, mais de créer des mondes, de nourrir des appartenances et de proposer des expériences mémorables. La valeur se déplace de la possession d'un objet à la participation à un écosystème.

Les défis de la saturation et de la rémunération équitable persistent, mais les outils pour les surmonter sont plus nombreux que jamais. La musique, dans cet environnement, redevient ce qu'elle n'aurait jamais dû cesser d'être : une connexion humaine profonde, simplement amplifiée par la technologie. L'avenir ne sonne pas comme une répétition du passé, mais comme une symphonie innovante, diverse et résolument tournée vers l'auditeur.

ChatGPT en 2025 : Révolution de l'IA et Fonctionnalités Clés

Depuis son lancement en novembre 2022, ChatGPT a transformé notre interaction avec l'intelligence artificielle. Développé par OpenAI, ce chatbot génératif repose désormais sur GPT-5, offrant des capacités inédites en matière de compréhension et de génération de texte. Découvrez comment cette technologie révolutionne divers secteurs et quelles sont ses dernières avancées.

Qu'est-ce que ChatGPT et comment fonctionne-t-il ?

ChatGPT est un modèle de langage basé sur l'architecture des transformers génératifs pré-entraînés (GPT). Il utilise des réseaux neuronaux avec des mécanismes d'auto-attention pour analyser et générer du texte de manière cohérente et contextuelle. Son entraînement repose sur d'énormes volumes de données textuelles, lui permettant de prédire les mots suivants dans une phrase avec une précision remarquable.

Technologie et apprentissage

Le modèle a été affiné par apprentissage par renforcement avec retours humains, garantissant des réponses utiles, claires et sécurisées. Cette méthode permet à ChatGPT de minimiser les hallucinations (informations erronées) et d'améliorer la pertinence de ses réponses. En 2025, avec l'arrivée de GPT-5, ces capacités ont été encore renforcées, offrant une meilleure compréhension contextuelle et une adaptabilité accrue.

Fonctionnalités principales

ChatGPT excelle dans plusieurs domaines, notamment :

- Génération de textes : articles, emails, résumés, et bien plus.

- Traduction : support de plus de 95 langues.

- Correction orthographique : amélioration de la qualité des textes.

- Idées créatives : brainstorming et génération de concepts innovants.

- Génération et débogage de code : impact notable sur les plateformes comme Stack Overflow, avec une baisse de trafic de 14 % en mars 2023.

Évolutions majeures en 2025 avec GPT-5

En août 2025, OpenAI a introduit GPT-5 comme modèle par défaut pour ChatGPT. Cette mise à jour marque une évolution significative, unifiant les anciens modèles en un système adaptatif avec plusieurs modes d'utilisation.

Modes d'utilisation

GPT-5 propose trois modes principaux :

- Auto : mode automatique pour des requêtes simples et rapides.

- Fast : optimisé pour des réponses instantanées.

- Thinking : permet un raisonnement étape par étape pour des tâches complexes.

Améliorations clés

Les principales améliorations apportées par GPT-5 incluent :

- Réduction des hallucinations : moins d'informations erronées.

- Cohérence sur projets longs : maintien de la pertinence sur des tâches étendues.

- Compréhension contextuelle renforcée : meilleure adaptation aux nuances du langage.

- Traitement multimodal fluide : intégration de texte, images et documents.

- Mode vocal sans latence : conversations orales plus naturelles.

Contexte et historique de ChatGPT

OpenAI, une société américaine spécialisée en intelligence artificielle, a développé ChatGPT à partir d'InstructGPT. Initialement basé sur GPT-3 avec ses 175 milliards de paramètres, ChatGPT a été lancé comme prototype pour tester les interactions humaines avec l'IA. Son objectif principal est d'accélérer la production de contenu sans remplacer l'expertise humaine, en standardisant les méthodes de travail.

Entraînement et amélioration continue

ChatGPT continue de s'améliorer grâce aux dialogues avec les utilisateurs, enrichissant ses capacités et priorisant des réponses "helpful, honest, harmless". Cette approche permet de minimiser la diffusion de fake news et d'assurer la fiabilité des informations fournies.

Impact initial et adoption

Dès son lancement, ChatGPT a suscité un engouement mondial, devenant un outil indispensable pour de nombreux professionnels. Son adoption rapide a démontré son potentiel dans divers domaines, de la rédaction à la programmation, en passant par la traduction et la correction de textes.

Tendances actuelles et intégration professionnelle

En 2025, ChatGPT est largement intégré dans le monde professionnel, offrant des solutions innovantes pour diverses tâches. Son utilisation s'étend à plusieurs secteurs, notamment le SEO, la planification business, la relation client et l'automatisation de tâches.

Utilisation en SEO

ChatGPT est devenu un outil précieux pour les spécialistes du SEO, permettant la génération de mots-clés et de contenus optimisés. Sa capacité à produire des textes structurés et pertinents en fait un allié de choix pour améliorer le référencement naturel.

Planification business et études de marché

Les entreprises utilisent ChatGPT pour réaliser des études de marché et générer des rapports détaillés. Son aptitude à analyser et synthétiser des informations complexes permet de gagner un temps précieux et d'améliorer la prise de décision.

Relation client et automatisation

Dans le domaine de la relation client, ChatGPT est employé pour créer des chatbots plus humains et réactifs. Ces assistants virtuels améliorent l'expérience utilisateur en fournissant des réponses rapides et précises. De plus, l'automatisation de tâches répétitives libère du temps pour des activités à plus forte valeur ajoutée.

Programmation et rappels

Les développeurs bénéficient également des capacités de ChatGPT, notamment pour la génération et le débogage de code. Cette fonctionnalité a eu un impact notable sur des plateformes comme Stack Overflow, avec une réduction de trafic de 14 % en mars 2023. Par ailleurs, ChatGPT peut être utilisé pour programmer des rappels et automatiser des processus.

Impact sociétal et enjeux éthiques

Bien que ChatGPT offre des avantages considérables en termes de productivité, son adoption soulève également des questions éthiques. Les hallucinations résiduelles et la dépendance aux prompts de qualité sont des défis à relever pour assurer une utilisation responsable de cette technologie.

Révolution de la productivité

ChatGPT a révolutionné la productivité dans de nombreux secteurs, permettant une rédaction plus rapide, un codage plus efficace et une traduction plus précise. Ces avancées ont transformé les méthodes de travail, rendant les processus plus efficaces et moins chronophages.

Enjeux éthiques

Cependant, l'utilisation de ChatGPT n'est pas sans risques. Les hallucinations, bien que réduites avec GPT-5, restent un enjeu majeur. De plus, la qualité des résultats dépend fortement de la précision des prompts fournis par les utilisateurs. Il est donc essentiel de former les utilisateurs à l'élaboration de requêtes claires et détaillées pour maximiser l'efficacité de l'outil.

En conclusion, ChatGPT en 2025 représente une avancée majeure dans le domaine de l'intelligence artificielle. Avec l'arrivée de GPT-5, ses capacités ont été considérablement améliorées, offrant des solutions innovantes pour divers secteurs. Cependant, son utilisation doit être encadrée pour garantir des résultats fiables et éthiques.

Applications sectorielles de ChatGPT en 2025

ChatGPT s'impose comme un outil incontournable dans plusieurs secteurs d'activité. Ses capacités adaptatives et sa polyvalence en font un atout maîtrisé pour des domaines aussi variés que la santé, l'éducation et la finance.

Santé et recherche médicale

Dans le domaine médical, ChatGPT participe à la synthèse d'études cliniques et à la rédaction de rapports de recherche. Grâce à sa compréhension contextuelle, il aide les professionnels à identifier des tendances dans de grands ensembles de données. Certaines équipes utilisent même l'outil pour générer des résumés de patients à partir de dossiers médicaux complexes.

- Analyse de littératures scientifiques en quelques minutes

- Génération de fiches de suivi patient

- Traduction de documents médicaux techniques

Éducation et formation en ligne

L'éducation bénéficie grandement des fonctionnalités de GPT-5. Les enseignants utilisent ChatGPT pour créer des exercices personnalisés, des quiz interactifs et des résumé de cours. Les plateformes de formation en ligne intègrent l'outil pour proposer des parcours d'apprentissage adaptatifs.

"Plus de 70 % des universités ont intégré ChatGPT dans leurs programmes en 2025."

Finance et conformité

Dans le secteur financier, ChatGPT assiste les analystes dans l'interprétation des rapports-bilan et la détection anomalies transactionnelles. Sa capacité à traiter des documents juridiques complexes en fait un allié pour la conformité réglementaire.

- Analyse automatisée des contrats

- Génération de rapports d'audit prédéfinis

- Traduction de documents boursiers multilingues

Cas d'usage concrets et retours d'expérience

L'adoption professionnelle de ChatGPT se traduit par des résultats mesurables. De nombreux secteurs rapportent une augmentation de la productivité et une amélioration de la qualité des livrables.

Productivité dans les équipes marketing

Les équipes marketing exploitent les modes Auto et Thinking pour rédiger des campagnes publicitaires cohérentes sur plusieurs canaux. Une étude récente montre une réduction de 30 % du temps consacré à la création de contenu.

- Rédaction de scripts vidéo optimisés

- Génération de descriptions produit multilingues

- Analyse sémantique concurrentielle

Optimisation des processus RH

Dans les ressources humaines, ChatGPT aide à la rédaction d'offres d'emploi attrayantes et à l'analyse des candidatures. Le traitement automatisé des entretientype réduit de 40 % la charge administrative des recruteurs.

Atelier de programmation

Les développeurs apprécient particulièrement le mode Fast pour résoudre des bugs récurrents. Une enquête auprès de développeurs montre que 62 % d'entre eux utilisent régulièrement ChatGPT pour tester des solutions de code.

Défis techniques et éthiques à l'horizon 2025

Malgré ses avancées, ChatGPT soulève des défis techniques et éthiques majeurs. La maîtrise de ces aspects est cruciale pour une utilisation responsable de l'IA générative.

Gestion des hallucinations résiduelles

Même avec GPT-5, des hallucinations minimes persistent. Les entreprises doivent mettre en place des protocoles de vérification rigoureux, notamment pour les contenus à haut risque comme les rapports financiers ou les documents médicaux.

Dépendance aux prompts optimisés

La qualité des résultats dépend fortement de la précision des prompts. Les utilisateurs professionnels doivent investir dans la formation à l'élaboration de requêtes structurées pour maximiser l'efficacité de l'outil.

Équité et biais algorithmiques

Les équipes techniques travaillent activement à réduire les biais inhérents aux données d'entraînement. Des audit éthiques trimestriels sont recommandés pour garantir l'impartialité des réponses générées.

- Analyse des schémas de langage

- Vérification des références culturelles

- Évaluation des nuances contextuelles

L'équilibre entre innovation et responsabilité reste un défi central pour les organisations utilisant ChatGPT à grande échelle. Une gouvernance claire et des formations régulières sont essentielles pour tirer parti de cette technologie révolutionnaire.

L'avenir de ChatGPT : Perspectives et innovations à venir

Alors que GPT-5 marque déjà une étape décisive, les chercheurs d'OpenAI travaillent sur des fonctionnalités encore plus avancées. Ces innovations promettent de repenser notre interaction avec l'intelligence artificielle.

Intégration de la réalité augmentée

Les prochaines versions de ChatGPT pourraient inclure des capacités de réalité augmentée, permettant une interaction visuelle avec les données générées. Imaginez un assistant capable de projeter des graphiques 3D ou des simulations en temps réel.

- Visualisation interactive de données complexes

- Guidage pas-à-pas via des hologrammes

- Intégration avec des lunettes connectées

Personnalisation extrême des assistants

Les utilisateurs pourront bientôt créer des personas d'IA totalement personnalisés, adaptés à leurs besoins spécifiques. Ces assistants pourront mémoriser des préférences sur le long terme et anticiper les demandes.

"85 % des utilisateurs souhaitent un assistant IA qui s'adapte à leur style de travail."

Collaboration multi-agents

Une évolution majeure sera la capacité de faire collaborer plusieurs instances de ChatGPT sur un même projet. Par exemple, un agent spécialisé en marketing pourrait travailler en tandem avec un agent technique pour produire des contenus optimisés.

Bonnes pratiques pour une utilisation optimale

Pour tirer le meilleur parti de ChatGPT, certaines pratiques doivent être adoptées. Ces recommandations permettent d'améliorer la qualité des résultats et de minimiser les risques.

Formulation de prompts efficaces

Un prompt bien structuré est la clé pour obtenir des réponses pertinentes. Il doit inclure :

- Le contexte précis de la demande

- Les attentes en termes de format

- Les contraintes éventuelles

- Des exemples si nécessaire

Vérification systématique des résultats

Même avec GPT-5, une relecture humaine reste indispensable pour les contenus critiques. Les outils de détection d'hallucinations intégrés doivent être complétés par une expertise sectorielle.

Gestion des données sensibles

Les organisations doivent mettre en place des protocoles de sécurité pour protéger les informations confidentielles. L'utilisation de versions entreprises avec chiffrement de bout en bout est recommandée.

Comparaison avec d'autres solutions d'IA générative

ChatGPT n'est pas le seul acteur sur le marché des assistants IA. Une analyse comparative permet de mieux comprendre ses forces et ses limites.

Avantages concurrentiels de ChatGPT

Plusieurs éléments distinguent ChatGPT de ses concurrents :

- Polyvalence : capacité à traiter des tâches variées

- Interface intuitive : accessible aux non-techniciens

- Écosystème développé : intégrations multiples

- Mises à jour régulières : améliorations continues

Limites et alternatives

Certaines solutions concurrentes excellent dans des domaines spécifiques :

- Claude pour les analyses juridiques complexes

- Gemini pour les applications multimédias

- Mistral pour les environnements low-code

Conclusion : ChatGPT, un outil révolutionnaire à maîtriser

ChatGPT représente une avancée majeure dans le domaine de l'intelligence artificielle. Avec l'arrivée de GPT-5, ses capacités ont atteint un niveau de sophistication inédit, offrant des solutions innovantes pour de nombreux secteurs.

Les points clés à retenir :

- Polyvalence : adaptation à des tâches variées

- Améliorations continues : réduction des hallucinations

- Intégration professionnelle : gain de productivité

- Défis éthiques : nécessité de gouvernance

Pour les entreprises comme pour les particuliers, ChatGPT offre des opportunités sans précédent. Cependant, son utilisation doit être encadrée par des pratiques responsables et une formation adaptée. En maîtrisant cet outil, nous pouvons transformer notre façon de travailler et d'innover.

L'avenir de l'IA générative s'annonce passionnant, et ChatGPT en est aujourd'hui le fer de lance. À nous de l'utiliser avec sagesse pour en tirer le meilleur parti.

Fritz Haber: Le Chemin de la Révolution Chimique et de la Guerre

Un génie multiforme

Le scientifique allemand Fritz Haber (1868-1934) reste l'un des personnalités les plus controversées du dernier siècle en science et en ingénierie chimique. Né dans une famille d'immigrants juifs russes à Breslau, actuelle Wrocław, en Pologne, Fritz Haber est rapidement devenu une figure emblématique à travers le monde. Sa contriBution aux progrès de la chimie a profondément influencé notre compréhension des processus fondamentaux de la vie tout comme la façon dont nous produisons nos aliments et nos matières premières.

L'origine scientifique d'un génie

Haber a commencé ses études à l'École polytechnique fédérale de Zurich avant de rejoindre l'université de Bâle pour poursuivre ses études de chimie. Ses travaux initiaux portaient sur la structure des molécules et les interrelations entre la chimie organique et inorganique. C'est là qu'il développa une intérêt pour la catalyse qui allait marquer toute sa carrière académique.

La découverte du procédé Haber-Bosch

En 1902, Fritz Haber a réussi à développer une technique efficace pour la fixation atmosphérique azotique, transformant ainsi l'azote gazeux, un composant essentiel mais souvent inexploitable, en azote fertilizer. En 1913, il fit la lumière sur ce processus avec le concept d'une catalyseur à basse température, permettant aux industriels d'introduire la pression de 200 bar et la température de 400-500°C pour favoriser la réaction.

L'invention du procédé Haber-Bosch

Ce travail coûteux mais revigorant a été développé en collaboration étroite avec Carl Bosch, de l'Institut de Recherche de l'Industrie Générale. Leur processus conjoint, connu sous le nom de procédé Haber-Bosch, permet de transformer l'azote atmosphérique en forme soluble d'azote nitrique - un élément clé de l'industrie de l'agriculture moderne. Cette découverte a depuis largement contribué à nourrir la population mondiale grâce à une augmentation de la production de fertilisants synthétiques.

De la chimie à la guerre

Outre ses contributions majeures à la chimie industrielle, Fritz Haber a joué un rôle significatif durant la première guerre mondiale, où ses connaissances en chimie ont pu être exploitées pour le domaine militaire. Sa carrière a pris un tournant inattendu lorsqu'il a été choisi pour diriger le comité des recherches pour la guerre par le Kaiser Wilhelm Institut.

La création de gaz toxiques

Haber a conçu et mis au point les premiers gaz poisons utilisés pendant la Première Guerre mondiale. La première utilisation mémorable de ces armes a eu lieu à la bataille de Ypres en 1915, marquant le début d'une nouvelle ère de la guerre totale et de l’horreur. Bien que cette innovation ait sauvé des vies en créant une barricade humaine contre les forces alliées, elle a également engendré une controverse morale à son égard.

Le double héritage de Fritz Haber

À travers cette période sombre, Haber a continué à effectuer des recherches scientifiques innovantes dans le domaine de la chimie. Tout en assistant activement à la mise en œuvre de l'influence industrielle du comité des recherches, il a poursuivi son désir de contribuer à la guerre à travers des moyens scientifiques.

Reconnaissance et controverses

Sa contribution à la chimie, en particulier le développement du procédé Haber-Bosch pour la fixation azotique, lui a valu une série d'honneurs, notamment le prix Nobel de chimie en 1918. De nombreuses rues et institutions lui sont dédiées dans diverses parties du monde. Toutefois, il a été la cible de plusieurs critiques pour sa participation à la criminelle technologie de guerre.

Le leg du XXe siècle

L’héritage de Fritz Haber est complexe et multifacette. Il a été à la fois un géant de la science et un homme impliqué dans une partie sombre de l’histoire humaine. Cette dualité continue de faire l’objet de débats entre chercheurs, historiens et éthiciens. Son invention de la fixation atmosphérique azotique a permis de nourrir des millions de personnes, tandis que son travail sur les gaz de guerre a causé une quantité indéniable de souffrance humaine.

Mais c’est aussi l’histoire de Fritz Haber qui souligne la responsabilité de la communauté internationale scientifique. Comment les technologies scientifiques peuvent-elles servir à la fois l’humanité et être utilisées pour des fins violentes? Ces questions continuent de hanter le monde moderne et restent pertinentes pour toute nouvelle avancée technologique.

La mémoire de Fritz Haber nous rappelle à jamais qu’à chaque progrès technologique, il y a toujours un fil conducteur moral qui doit être suivi avec vigilance et sensibilité.

Le leg du XXe siècle (suite)

La décennie suivante a vu Fritz Haber poursuivre ses recherches en chimie et jouer un rôle clé dans la modernisation de l’industrie chimique allemande. Après la guerre, il retourna à son travail de base en science, mais il continua aussi de travailler pour le gouvernement allemand, y compris dans des domaines de recherche militaires.

La controverse après la guerre

Malgré les honneurs qui lui ont été accordés, Haber a continué à être la cible de critiques et de controverses. Les Allemands savaient de manière générale qu’il avait joué un rôle dans les opérations de gaz dans la Grande Guerre, mais Haber ne semblait pas prêt à renoncer à son engagement à aider son pays, même si cela impliquait parfois la mise en œuvre de technologies qui étaient considérées comme moralement problématiques.

Dans les années qui ont suivi la Guerre de 1918-1919, Haber a fait des déclarations publiques soutenant les positions de l’Allemagne nazie contre l’occupation des Pays-Bas et soutenant le mouvement national-socialiste. Ses déclarations n’étaient pas uniquement politiques. En tant qu'épistémologue et homme de science, il croyait en la supériorité de l'espèce aryenne et en la nécessité d'une politique eugéniste pour maintenir cette supériorité. Ce qui était au départ une position marginale devint rapidement centrale dans la philosophie politique dominante du National-Socialisme.

Le conflit personnel avec son épouse Clara

La controverse personnelle de Haber a atteint son paroxysme avec le suicide tragi-comique de son épouse, Clara Immerwahr, qui avait toujours été opposée aux applications militaires de ses travaux. Clara était une scientifique dynamique en cheminement vers une carrière étonnante en chimie physique. Travaillant sur des réactions catalytiques, des oxydes de fer et l'étude du fer à température élevée, elle avait grandement contribué à ses recherches. Sa volonté qu'elle était incapable de vivre avec le choix de Haber de collaborer activement avec le gouvernement militaire fut dévastatrice pour elle.

Les ultimes années de Fritz Haber

La fin de la vie de Fritz Haber est ponctuée de tensions croissantes et de conflits personnels. Après sa nomination comme directeur du Kaiser Wilhelm Institute of Physical Chemistry and Electrochemistry en 1933, il dut gérer l’évacuation de nombreux scientifiques juifs de l’institution. L’éthique de Haber vis-à-vis des Juifs semblait ambivalente. D’une part, il tenta de protéger certains de ses collègues juifs, mais il semblait également convaincu qu’un grand nombre d’entre eux ne faisaient qu’abuser de leur place dans l’institution. Malgré cela, Haber lui-même était un citoyen allemand protestant.

Infiniment dépressif après la mort de Clara et confronté à un environnement politique de plus en plus hostile, Haber s'est finalement découragé et a choisi de se retirer d'activités scientifiques au milieu de tensions politiques qui augmentaient.

La legacy after his death

Même après sa mort en 1934, Fritz Haber demeure un sujet de controverse intense et continu. La décision de l’État allemand de conférer au Kaiser Wilhelm Institut l’une des premières conférences Nobel de l’Allemagne nazie en 1934 est particulièrement controversée. Elle alimente encore les débats sur le lien entre la science et la politique, mettant en lumière les difficultés que la communauté scientifique doit gérer alors face à des pressions gouvernementales.

L’héritage de la chimie appliquée

La découverte principale de Fritz Haber, le procédé Haber-Bosch, a façonné la chimie agricole moderne à de nombreux aspects. Sans son travail, l'approvisionnement mondial de nourriture serait sans doute beaucoup plus fragile, puisque les engrais produits par ce processus sont cruciaux pour nourrir la croissance démographique mondiale. Bien que la technologie ait été utilisée de manière contestée durant la Première Guerre Mondiale et à plusieurs reprises depuis lors, en particulier dans diverses opérations de guerre chimiques, il ne peut pas être ignoré qu’elle joue un rôle essentiel dans notre alimentation quotidienne.

La mémoire de Fritz Haber

Les mémoires conflictuelles de Fritz Haber ont contribué à l’écriture de la mémoire collective allemande, soulignant le dilemme éthique face à l'utilisation d’avancées technologiques pour des fins pacifiques ou militaires, et mettant en lumière la complexité de l'engagement des scientifiques dans la société. La question de savoir comment les scientifiques font face à ces dilemmes continue d'être examinée aujourd'hui, surtout avec les progrès en sciences contemporaines et biotechnologies.

Ainsi, Fritz Haber reste un symbole complexe de l'âge moderne, marqué par ses contributions scientifiques majeures et ses controverses morales. Alors que l'histoire continue de s'écrire, Haber fait toujours l'objet de longues discussions et de multiples lectures, rappelant l'importance de la prise de conscience des responsabilités scientifiques et morales.

Conclusion et réflexions

Fritz Haber est une figure singulière et controversée dans l'histoire de la science et de la technologie. Sa complexité réside dans la manière dont il a pu apporter des contributions majeures et à la fois être associé à des innovations controversées. En analysant sa vie et son œuvre, nous pouvons tirer des leçons importantes sur les responsabilités éthiques des scientifiques et l'impact des technologies sur la société.

Éthique scientifique et responsabilités morales

Le cas de Fritz Haber pose des questions cruciales sur l'éthique scientifique. Comment les scientifiques peuvent-ils naviguer entre les innovations majeures et leurs applications potentiellement dangereuses? Peut-on réellement séparer la science elle-même de sa mise en œuvre pratique? Ces questions restent pertinentes aujourd’hui, et Fritz Haber nous offre un exemple précis de la tension entre le progrès scientifique et les conséquences éthiques de ses applications.

L'impact mondial de son travail

Le procédé Haber-Bosch a eu un impact colossal sur l'agriculture mondiale, nourrissant des milliards de personnes. Cette découverte a permis une augmentation significative de la production agricole et a contribué à la stabilité alimentaire dans de nombreuses régions. Toutefois, cette technologie a également suscité des problèmes environnementaux, notamment la pollution des sols et le dépassement des seuils de concentration d'azote dans l'environnement, ce qui a des conséquences sur la biodiversité et le changement climatique.

Social et culturel

Fritz Haber a joué un rôle important dans le contexte socio-culturel de son époque. Sa participation active à la science pendant la Première Guerre Mondiale souligne l’intertwinement entre la science et la guerre. À la fois comme un scientifique et comme un résident d’Allemagne nazie, son parcours est également étroitement lié à l’histoire et à la transformation de l’Allemagne vers une dictature totalitaire.

L'héritage scientifique

Il est difficile de discuter l'héritage de Fritz Haber sans reconnaître la magnitude de ses contributions à la chimie. Ses travaux ont ouvert de nouvelles voies dans des domaines tels que la catalyse et la spectroscopie. De plus, le procédé Haber-Bosch est toujours utilisé aujourd'hui, bien qu'il ait subi de nombreuses améliorations depuis sa découverte. Sa méthode a inspiré de nombreuses autres réalisations dans la chimie industrielle et a consolidé la position de l'Allemagne en tant que leader global dans le domaine.

Le débat persistant

Fritz Haber n'a pas été seulement un brillant scientifique; il était également un homme impliqué dans des affaires politiques et sociales complexes. Son histoire souligne l’importance d’examiner les intentions et les conséquences de nos inventions, et de prendre en compte les évaluations rigoureuses et éthiques lorsqu’ils sont mises en œuvre dans le monde réel. Fritz Haber nous montre que la science n'est pas isolée de la société et que les implications de nos recherches transcendent souvent la pure recherche.

L'éducation et le médaillé de bronze

Aujourd'hui, Fritz Haber est hommageé dans les établissements d'enseignement supérieur et les laboratoires autour du monde. Deux écoles d'ingénierie portent son nom, ainsi que divers prix et médailles. Cependant, ces hommages n'éliminent pas la controverse; au contraire, ils soulignent la nécessité d'examiner ses contributions sous tous les angles - scientifiques, éthiques et sociaux.

Une leçon pour l'avenir

Fritz Haber nous rappelle que la science, bien que puissante et utile, ne peut pas être traitée à part des questions morales et éthiques qui se posent lors de l'application de ses découvertes et inventions. Les débats contemporains sur les nanotechnologies, les biotechnologies et l'intelligence artificielle s’inscrivent dans le même champ d’analyse.

En conclusion, Fritz Haber est une figure complexe qui offre une fenêtre sur les défis éthiques auxquels les scientifiques sont confrontés aujourd'hui. Par-delà la controverse, sa vie et son œuvre soulignent l'importance de toujours considérer les implications sociales et éthiques de tous les aspects de la science et de la technologie.

Ainsi, Fritz Haber continue d'inspirer des conversations sur la façon dont la science doit être pratiquée et comment ses avancées affectent notre société et notre planète.

Ascanio Sobrero: Der Chemiker, der Dynamite erfand

Wie eine Entdeckung zur Weltgeschichte führte

Der Weg zu einem Bedeutenden in der Chemie: Im Jahr 1848 wurde Ascanio Sobrero, der bedeutende italienische Chemiker und Arzt, in Florenz geboren. Sobrero war nicht nur ein brillanter Forscher, sondern auch einer der Pioniere bei der Entwicklung explosiver Materialien. Seine Arbeit hat die Geschichte der Chemie geprägt.

Nachdem Sobrero seine Ausbildung in Würzburg und Berlin absolviert hatte, kehrte er 1871 nach Florenz zurück. Dort setzte er seine Forschungen fort und entdeckte ein neues Explosivum.

Die Entdeckung der Dynamitexplosivstoffe

Sobrero und das Zyanon: In den frühen 1850er Jahren begann Sobrero mit Experimenten unter dem Einfluss von John Walker und Sir Benjamin Silliman, die beide zuerst Schwefelsäure für ihre Forschungen verwendet hatten. Obwohl Sobrero zunächst die Schwefelsäure für seine Arbeit verwendete, bemerkte er bald, dass sie zu schweren Explosionsrisiken führte.

Als er versuchte, eine stabile Fassung des Zyans zu finden, kam er zu dem Entschluss, einen neuen Explosivstoff zu entwickeln, der eine viel sicherere Alternative zu anderen Chemikalien bot. Dies führte ihn schließlich zu einer wunderbaren Entdeckung: Der Sulfhydrid von Ammoniak, ein starker Explosivstoff.

Das erste Dynamit

Eine gefährliche Erfindung: Sobreros Entdeckung war uralt und beeindruckend. Als er erkannte, dass Sulfhydrid von Ammoniak eine effektive Möglichkeit darstellte, Zyankalium aus Schwefelsäure herzustellen, begann er, dieses neue Explosivum in Form von dynamischem Pulver zu verwenden.

In einer Besprechung der italienischen Akademie der Wissenschaften in Rom, präsentierte Sobrero am 24. Oktober 1846 seine Entdeckung. Er beschrieb ein Pulver, das so stark explodieren konnte, dass es in den Kriegsministerien aufmerksam gemacht würde.

Nur wenige Wochen später begann Sobrero jedoch, Bedenken über die Sicherheit seiner Invention zu äußern. Zu seiner Überraschung reagierten einige seiner Kollegen sehr ähnlich wie der britische Ingenieur Alfred Nobel, den er kurz darauf traf:

Kontroversen und Warnungen

Die Bedenken Sobreros: Sobrero verließ London schnell und ließ seine Arbeit dort zurück. Er befürchtete, dass sein Entdeckungsstoff zu einer gefährlichen Umweltbelastung und zu schlimmen Unglücksfällen führen könnte. Diese Bedenken waren nicht unbegründet, da eine Reihe von Unfällen während der Prüfung seines Dynamits sich ereigneten.

Insgesamt waren mehr als dreißig tödliche Anschläge auf Mitarbeiter von Sobrero registriert worden. Diese tragischen Vorfall führten zu massiven Protesten der Mitarbeiter und zwangen Sobrero dazu, die Produktion des Explosivmaterials einzustellen.

Alfred Nobels Entdeckung der Sprengkraft

Die Fortsetzung in der Forschung: Obwohl Alfred Nobel einige Jahre später nach einer Lösung für die Herstellung weniger gefährlichem Dynamits suchte, war Sobrero bereits früh damit beschäftigt, weitere Forschungen durchzuführen. Er konzentrierte sich darauf, die Stabilität und Sicherheit des Explosivstoffs zu verbessern.

Nobel untersuchte ebenfalls diese Frage, indem er versuchte, einen stabilen Kristallzahnstoff herzustellen, der eine effizientere und gefahrlosere Methode zum Aufbereiten von Zyankalium bot. Schließlich gelang ihm 1867 die Synthese von Zanthophyll, einem zukünftigen Komponenten seines Dynamit-Formulierungs。

Die Bedeutung von Sobreros Werk

Ein wichtiger Meilenstein: Trotz seiner Bedenken über die Verwendung seines Explosivmaterials, blieb Sobreros Entdeckung von großer Bedeutung. Sie legte die Grundlage für die weitere Verfeinerung und Sicherstellung von Dynamit. Obwohl Sobrero selbst nie die große Anerkennung genoss, die Alfred Nobel spätere Fortschritte zu erlangen half, war er ein wichtiger Pionier in der Entwicklung moderner Explosivstoffe.

Ascanio Sobrero starb am 24. April 1916, um genau zu sein, im Alter von 67 Jahren in Florenz. Seine Erfindung und der daraus resultierende Streit zwischen ihm und anderen Chemikern haben den Verlauf der Erdol-Revolution gewaltig beeinflusst und lebten fort, nachdem er fortgeschritten war.

Ganze Generationen von Chemikern und Ingenieuren sind in die Fußstапten Sobreros getreten, um die Sicherheit von Explosivstoffen weiterhin zu verbessern. Seine Arbeit blieb als Inspiration für künftige Forscher bestehen und war Teil der grundlegenden Entwicklungen, die unsere heutige Industrialisierung geprägt haben.

In den kommenden Abschnitten werden wir näher auf die weiteren Einflüsse und Folgen der Arbeit von Sobrero eingehen und uns mit den weiteren Entwicklungen in der chemischen Industrie befassen. Sobrero, dessen Leidenschaft und Eindringlichkeit trotz aller Bedenken weiterhin beispielhaft bleiben, hatte eine bedeutende Rolle bei den grundlegenden Schritten zur Verbesserung unserer technologischen Möglichkeiten gespielt.

Weitere Verfolgungen und Nachwirkungen

Alfred Nobels Revolution: Während Sobrero sein Werk zurücklegte und sich der Industriekonflikt aufhielt, schwenkte Alfred Nobel seinen Kurs. Bereits Ende 1867 gelang es ihm, eine effektivere Herstellungsmethode für Dynamit zu entwickeln. Durch das Einbringen von Nitrat und Chlor in das Pulverkonzept von Sobrero, war er in der Lage, einen weitaus sichereren und robusteren Explosivstoff zu produzieren. Dies führte zum Stillstand der dynamitartigen Produktionen und warf die bisherigen Forschungen von Sobrero in ein neues Licht.

Nobel’s Sicherheitsprobleme: Nobel experimentierte ständig mit Verbesserungen und Sicherheitsmaßnahmen, um das Risiko von Explodieren zu mindern. Die Einführung des Nobel-Dynamits – mit seinen spezialisierten Werkzeuge und den sorgfältig gestalteten Fabrikationsoberichten – revolutionierte die Industrie. Nobel führte strikte Sicherheitsregeln ein und ermutigte andere Unternehmen, diese zu respektieren. Dies brachte den Risikofaktor signifikant herunter und führte zu einem allgemeinen wachsenden Vertrauen in die Sicherheit dieses Materials.

Die Herausforderungen der Verbreitung

Internationale Akzeptanz: Obwohl Nobel erfolgreich war, die Sicherheit seiner Formel zu verbessern, blieben die Bedenken über Sicherheit und Umweltverschmutzung bestehen. Die internationale Gemeinschaft reagierte unterschiedlich auf diese Entdeckungen. Länder, wie das Vereinigte Königreich und Frankreich, waren skeptisch und verliehen der technischen Revolution, die Nobels Arbeit darstellte, nicht unbedingt sofort den Respekt, den sie verdienten.

Politische Konflikte: Der Weg zur akzeptierten Verbreitung des Nobel-Dynamits war ebenso kompliziert wie die Technologie selbst. Nobels Patentstreitigkeiten mit anderen Chemikern und Industriemagnaten zeugten von heftigen Konflikten und politischen Machtkämpfen. Diese Auseinandersetzungen trugen jedoch letztlich zu einem breiteren Verständnis und einer weit verbreiteteren Akzeptanz.

Die Rolle von Sobrero in der Modernen Chemie

Die Nachwirkungen der Entdeckung: Sobreros ursprüngliche Ideen galten lang jahrelang als zu gefährlich und wurden ignoriert oder diskreditiert. Es folgte jedoch die Bewusstseinserweiterung und die technologische Weiterentwicklung durch Nobels Arbeiten. Das Ergebnis war ein deutlicher Fortschritt in der Chemie, der sowohl die Sicherheit als auch die Effizienz moderner Explosivstoffe verbesserte.

Nobel nutzte jede sich bietende Chance, um die Bedeutung seiner Arbeit herauszustellen, insbesondere durch die Unterstützung von öffentlichen Demonstrationen und Wettbewerben im Zusammenhang mit seinem Nobel-Dynamit. Dieses visuelle Beweismittel half, die allgemeine Akzeptanz zu gewinnen und bestimmte Bedenken zu zerstreuen.

Die Erinnerung an Sobrero

Sobreros Beiträge in Vergessenheit geriet: Trotz seiner ursprünglichen Entdeckungsarbeit blieb Ascanio Sobreros Name in der Geschichte eher verborgen. Seine frühen Vorschläge waren zwar wichtig, aber nicht genügend um den großen Durchbruch Nobels zu übertreffen. Allerdings ist Sobreros Name heute wieder in der Forschung und Geschichte der Chemie hervorgehoben worden als wichtig für den Beginn der modernen Explosivstoffe-Forschung.

Erinnerungen und Festivals: In recent times, es gibt kleinere Festivals und Seminare in Italien, um Solbreros Verdienste anzumerken. Diese Veranstaltungen dienen nicht nur zur Erinnerung an sein Werk, sondern auch zur Förderung weiterer Chemieforschung und technischer Verbesserungen. Obwohl seine Bedenken und das Chaos, das die Veröffentlichung seiner Arbeit nach sich zog, oft vergessen wurden, hat Sobreros Innovationsgeist fortgesetzt Leben.

Bilder und Archivmaterialien: Die Nachrufe und Archivmaterialien von Sobrero sind heute verfügbar und haben eine größere Wirkung in der Historienforschung von Chemie und Ingenieurswesen. Diese Dokumentation zeigt, wie sein Entdeckungsprozess und seine Bedenken zur Sicherheit das Fundament für moderne Explosivstoffe und deren Sicherheit legten.

Die Fortschritte und Herausforderungen heute

Forschung und Sicherheit in der Modernen Industrie: Heute spielen noch immer Explosionen eine tragische Rolle in der Industrie. Trotz der fortschreitenden Verbesserungen und Sicherheitskontrollen, bleiben die Risiken nicht vollständig eliminiert. Die moderne Forschung liegt daher weiterhin im Fokus der Industrie, um weitere Verbesserungen vorzunehmen und das Risiko von Unfällen und Explosionen zu minimieren.

Neue Technologien und Materialien: Neben der Verbesserung traditioneller Explosivstoffe werden heute auch neue Technologien und Materialien entwickelt, um die Sicherheit zu erhöhen. Diese einschließlich thermischer und chemischer Systeme bieten potenzielle Lösungen für die Herausforderungen, die Sobrero und Alfred Nobel in ihren Zeiten hatten.

Die Nachwirkungen in der Modernen Geschichte

Dynamit und die Industriekontrolle: Sobreros Entdeckung und Nobels Revolution durch dynamit haben die Geschichte der Erdölindustrie und der Globalisierung maßgeblich geprägt. Die Ausdehnung der Erdölreserven und die Errichtung der entsprechenden Infrastruktur hing von den sicherem Transport und sicherem Speichern dieser wichtigen-resources stark ab. Dies führte zu einem steigenden globalen Handel und zu einer zunehmend interconnectiven Welt.

Technologie und Sicherheit: Die Technologie, die aus Sobreros und Nobels Erfinderarbeit entstanden ist, bleibt heute entscheidend für die Sicherheit und Effizienz in vielen Bereichen der Industrie. Ob es darum geht, schwierige Bergbautechnologien zu verbessern oder den Sicherheitsstandards im Militär zu erhöhen, sind die Leistungen dieser Chemiker die Fundamente für unsere modernen Sicherheitsnetzwerke.

Fazit: Wenn man sich von der Geschichte von Ascanio Sobrero und Alfred Nobel lernen lässt, zeigt sich, wie wichtig es ist, dass Risiken akribisch eingeschätzt und neue Technologien sicher und nachhaltig entwickelt werden. Diese Lektionen sind heute noch immer pertinent und erinnern uns daran, dass Innovation und Sicherheit immer nebeneinander gehen müssen.

In den kommenden Abschnitten werden wir genauer die weiteren Entwicklungen in der chemischen Industrie sowie die kontinuierlichen Maßnahmen zur Sicherheitsverbesserung untersuchen. Sobreros Beiträge haben uns gezeigt, wie wertvoll eingeschätzte technische Fortschritte sind, die gleichzeitig auf Sicherheit achten und den modernen industriellen Weltordnung beisteuern können.

Fortschritte und Herausforderungen in der Moderenen Forschung

Zukunft der Explosivstoff-Forschung: Die Forschungen um Explosivstoffe haben sich in die Richtung von sichereren und effizienteren Materialien verschieben. Heutzutage steht die Hauptaugenblick der Chemie bei der Entwicklung neuer Explosivstoffe und ihrer Anwendungen in der Industrie, dem Militär und in der Forschung dar. Mit fortschreitender Forschung und der Unterstützung durch moderne Technologien werden Verbesserungen erwartet, die sowohl die Effizienz als auch die Sicherheit der Explosivstoffe verbessern.

Neue Technologien und Materialien: Die Forschung konzentriert sich auf die Entwicklung von Materialien mit verringertem Explosivitätsgrad und gesteigerter Stabilität. Dies erfordert eine tiefe Verständnis der zugrunde liegenden chemischen Wechselwirkungen. Zudem werden novelle Herstellungsmethoden eingesetzt, um sicherere und robustere Explosivstoffe herzustellen. Ein solcher Ansatz ermöglicht es, die chemischen Komponenten genau zu regulieren und zu optimieren, um die gefährliche Eigenschaften zu minimieren.

Die Rolle der Technologie und Innovations

Sicherheit und Technologie: Heutzutage ist die Sicherheit von utmost-Wichtigkeit. Dies beinhaltet die Entwicklung von Sensoren und Überwachungssystemen, die eine frühe Warnung und eine schnelle Reaktion bei Explosionsrisiken ermöglichen. Diese Technologien sind heute entscheidend in der Prävention von Unfällen und in der Sicherung von Menschen und Umgebungen.

Anwendungen und Neustart: Die Anwendungen der neuen Explosivstoffe sind vielfältig. Sie umfasst die Förderung des Erdöls und der Steinkohle, die militärischen Anwendungen, sowie die moderne Architektur und Bauindustrie. Die Forschung und Entwicklung neuer Explosivstoffe helfen dabei, diese Anwendungen sicher und effektiv zu erfüllen.

Die Zukunft der Forschung

Challenges und Ziele: Obwohl großes Fortschritt gemacht wurde, bleiben Herausforderungen bestehen. Zu den Hauptproblemen zählen die Sicherheit bei der Herstellung, das Regulieren von Explosivitätsprofilen und die Umweltverträglichkeit der Materialien. Forscher streben danach, diese Herausforderungen zu meistern, indem sie stärker auf kovalente und organische Bindungen setzen und auf weniger gefährliche chemische Verbindungen zurückgreifen.

Menschliches Erbe der Forschung: Sobreros und Nobels Arbeit haben das menschliche Verständnis von Explosivstoffen wesentlich erweitert und weiter gefördert. Ihre Forschung bildet das Fundament für die fortschreitende Sicherheit und die Optimierung moderner Explosivstoffe. Diese Tradition der Innovation und der Sicherheitsbewusstsein bleibt ein wichtiger Bestandteil der modernen Forschung.

Zusammenfassung: Ascanio Sobrero und Alfred Nobel haben die Geschichte der Chemie und der Explosivstoffe-Forschung revolutioniert. Sobreros frühe Entdeckungen bildeten den Grundstein für die fortschreitenden Anwendungen im 19. Jahrhundert, während Nobels Innovationen eine erhebliche Verbesserung in der Sicherheit und Effizienz einführten.

Ausblick: Die moderne Forschung fortzusetzen, ist ein unablässiges Ziel, um sowohl die Effizienz als auch die Sicherheit der Explosivstoffe weiter zu verbessern. Die Fortschritte in der Forschung beruhen auf den leidenschaftlichen und innovativen Beiträgen der Chemiker von damals und der fortschreitenden Nachfolge. Diese Tradition der kühnen Ideen und der fortgesetzten Verbesserung wird sicherlich weiterhin die Industrie und unser Leben beeinflussen.

So endet das dritte und letzte Kapitel des Artikels über Ascanio Sobrero. Die Geschichte der Chemie ist prägt durch die Beiträge von herausragenden Wissenschaftlern wie Sobrero und Nobel, die uns fortan inspirieren und fordern, weiterhin zu forschen und zu innovieren. Der Beitrag dieser Chemiker hat nicht nur die Wissenschaft verändert, sondern auch die Gesellschaft als Ganzes geprägt und für uns in die Zukunft gezeigt.

Zusammenfassung

Das Wirksamkeit von Sobrero und Nobels Arbeiten: Sobreros frühe Entdeckungen und Nobels Fortgeschrittene Innovationen haben die Entwicklung moderner Explosivstoffe verändert. Ihre Arbeiten haben nicht nur die chemische Industrie revolutioniert, sondern auch die Technik, die Sicherheit und die Industriekontrolle betroffen.

Erneutes Erwachen der Interesse: Sobrers und Nobels Werke erhalten heute wieder Aufmerksamkeit. Die Geschichte ihrer Entdeckungen wird in seminare und Veranstaltungen gebracht, um den jungen Forschern und Ingenieuren zu inspirieren.

Fortpflanzung der Tradition: Die Tradition der Forschung und der Sicherheit bleibt heute erhalten. Moderner Chemiker arbeiten an weiteren Verbesserungen in der Herstellung und Sicherheit von Explosivstoffen. Ihre Arbeit erweist sich als entscheidend für die Veränderung unserer Welt.

Verweis und weiterführende Lesarten

Wenn Sie mehr über die Geschichte und die Forschung in der chemischen Industrie erfahren möchten, empfehlen wir Ihnen, folgende Quellen zu lesen oder zu überprüfen:

- Biografie von Ascanio Sobrero (Autor: [Name], Verlag: [Verlag], Jahr: [Jahr])

- Historisches Buch zur Entstehung und Entwicklung der Explosivstofftechnologie (Autor: [Name], Verlag: [Verlag], Jahr: [Jahr])

- Artikel in Fachzeitschriften über moderne Explosivstofftechnologie (Titel: [Titel], Veröffentlicht in: [Zeitschrift], Jahr: [Jahr])

Wir hoffen, dass diese Geschichte von Ascanio Sobrero Ihnen eine faszinierende Einblicke in die Geschichte der Chemie und der Explosionstechologie verschafft hat. Ihre Arbeit bleibt immer noch relevant und inspirierend, und wir erwarten, dass ihre Tradition weiterhin fortgesetzt wird.

John von Neumann: Ein Pioniere der Mathematik und der Computertechnologie

Eine kurze Biografie

John von Neumann, Geboren am 28. Dezember 1903 in Budapest, war einer der herausragenden Geistesgenies seiner Zeit. Seinen Namen verbinden manches Menschen mit den Anfängen des Rechners und der Quantenphysik. Während seiner Jugend wanderte er mit der Familie nach Großdeutschland aus, wo er bald als einer der bedeutendsten Wissenschaftler seines Zeitalters galten. Von Neumann studierte Mathematik, Physik und Chemie an der Universität Berlin und der Universität Zürich. Bereits jung hatte er sich durch seine wissenschaftlichen Leistungen einen Namen gemacht. Sein Genie zeigte sich früh, und so wurde er zum jüngsten Promovend im Jahr 1926.

Mathematische Errungenschaften

Von Neumann war ein führender Geometricus und Algebraiker. Seine bahnbreiende Arbeit umfasste viele Bereiche der Mathematik. Er war einer der ersten, die sich mit der Quantengruppentheorie beschäftigten, eine Methode zur Beschreibung quantenmechanischer Systeme. Sein Werk über die Theorie der Operatoralgebren und die linearen Operatoren legte den Grundstein für moderne mathematische Analysis. Von Neumanns Beitrag zur Game Theory hat ihn auch in der Öffentlichkeit bekannt gemacht. Dieses Feld der Mathematik untersucht strategische Spiele und ihre analytischen Lösungen.

Gründung von EDV-Unternehmen

Von Neumann zog es in die Praxis hinein. Als er im Zweiten Weltkrieg mit Projekten der Verteidigungsmarine betraut wurde, half er bei der Entwicklung von Waffen und den Berechnungen der Munitionswirkungsflächen. Nach dem Krieg engagierte er sich in verschiedenen Bereichen der Technologie. 1950 gründete er das Institut für Angewandte Mathematik an der Columbia University. Hier förderte er die technologischen Innovationen und die wissenschaftliche Forschung. Zudem halfen von Neumanns Arbeiten beim Bau von Computern, insbesondere das JOHNNIAC, ein Spezialrechner, welchem er die Architektur gab.

Forschung und theoretische Beitrag

Seine von Neumann-Untersuchungen waren von großer Bedeutung und legten den Grundstein für moderne Computerarchitektur. In seinen Publikationen über Kollektive Entscheidungssysteme und Strategische Spiele entwarf er Theorien, die heute in der Spieltheorie weiterhin relevant sind. Von Neumann entwickelte auch wichtige Methoden für die Deterministik im Chaos. Dieses Thema ist wichtig in der Nonlinear Dynamik und der Modellierung komplexer Systeme.

Mehr über John von Neumann

Von Neumanns Interessen umfassten viele Bereiche außerhalb der Mathematik und der Computerscience. Er verfolgte eine Interdisziplinäre Ansicht und schaute über den Horizont der reinen Mathematik hinweg. Er studierte Philosophie und Medizin und veröffentlichte sogar Fachartikel zur Radiologie. Von Neumanns universelle Begabung und sein breites Wissen machten ihn zu einem einzigartigen Gelehrten. Seine Fähigkeit, schwierige Probleme in einfache Fragestellungen zu verwandeln und sie elegant gelöst zu haben, wurde oft als seine Mind-Bending Genialität bezeichnet.

Zusammenfassung: Die Bedeutung von John von Neumann

Zu seinen zahlreichen Arbeiten zählt auch sein Einfluss auf die Entdeckung der DNA Struktur. Von Neumann war einer der wenigen Wissenschaftler, die die Bedeutung dieses Fundamentes für die Evolution und den Lebensfortbestand erkannten. Sein universelles Denken ermöglichte ihm, diese und andere Fragen vielfältig und fundiert zu analysieren. Mit seinem unerschrockenen Innovativitätsgeist hat ihm auch der Weg zur Entwicklung moderner Computersysteme geöffnet.

John von Neumann hinterließ ein unverwechselbares Denkprofil und einen wegweisenden Beitrag zur Entwicklung der Moderne. Mit überzeugender Präzision und tiefgreifenden Einsichten hat er die Fächer der Mathematik und der Technologie revolutioniert und neue Richtungen bahnt. Bis heute bleibt von Neumanns Arbeit als Inspirationsquelle für neue Ideen und Erkenntnisse. Sein Leben und seine Fehden haben die Welt der Wissenschaft bis heute beeinflusst.

Aufgabe und Leistung in der Physikalischen Chemie

Von Neumann leistete signifikante Beiträge zur Physikalischen Chemie. Seine Arbeiten über Stoßprozesse und Moleküldynamik führten dazu, dass er sich für die Entwicklung eines Laser-Theoretikers begeistert. Er war einer der ersten, die die mathematischen Grundlagen des Quantenspektrums untersuchten und dabei Erkenntnisse über die Quantenmechanik bereitgab. Diese Untersuchungen waren von großer Bedeutung und halfen später bei der Entwicklung moderner Optik-Technologien und Photoniken.

Bewirtschaftung und Organisation

Ein weiteres besonderes Talent Von Neumanns war seine Fähigkeit, komplexe Prozesse zu organisieren und zu optimieren. Sein Interesse an Systems theory und operations research führte zu einem tieferen Verständnis der Effizienz und Komplexität in vielen Bereichen wie den Militärstrategien, der Wirtschaft und der Unternehmensführung. Er war einer der Pioniere in der Entwicklung mathematischer Modelle zur Analyse und Planung von Strategien. Seine Leistungen in diesem Bereich wurden unter dem Titel „The Computer and the Brain" (1958) zusammengefasst und hatten eine beeindruckend lange Nachwirkung.

Kulturelle Rolle und öffentliche Auftritte

Von Neumanns intellektuelle Leistung und kulturelle Wirkung reichten weit über die akademischen Kreise hinaus. Er war ein beliebter Gast dozentierte an renommierten Hochschulen und trat in TV-Interviews auf, was seine öffentliche Wissensgier und Intuition zeigte. Er trat auch als Mitglied des amerikanischen Nationaldefense Science Board vor und gab seine Expertise in verschiedenen militärischen und zivilen Projekten ein. Seine öffentliche Rolle verhalf ihm auch zu einer gewissen Bekanntheit im allgemeinen Publikum.

Einfluss auf moderne Technologien

Von Neumanns Theorien und Methoden trugen entscheidend zur Entwicklung moderner Technologien bei. Insbesondere in der Computertechnologie war er einer der Hauptanforderer von architektonischen Grundsätzen, die heute in fast allen modernen Rechnersystemen verbreitet sind. Seine von Neumann-Architektur ermöglichte es, Daten und Anweisungen in einem gemeinsamen Speicher zu kombinieren, eine Konstruktion, die heute in fast allen Computern verwendet wird.

Werkzeuge und Methoden für die Zukunft

Schließlich war von Neumann ein treuer Schüler und Förderer moderner Methoden und Werkzeuge. Er arbeitete aktiv an der Entwicklung neuer Mathematik- und Statistikmethoden und war einer der ersten, die die Potenziale der computerunterstützten Recherchen erkannten. Seine Vorrichtungen und Techniken sind heute in Forschungseinrichtungen und Unternehmen weltweit weitergeführt worden.

Von Neumann und seine Auswirkungen

Es ist nicht übertreiben zu sagen, dass von Neumanns Arbeiten die moderne Technik zu dem gemacht haben, was sie heute ist. Seine Theorien und Methoden sind der Grundstein für die Computerscience und haben unzählige praktische Anwendungen gefunden. Obwohl viele seiner Erkenntnisse noch immer aktuell sind, war es von Neumanns universelle Denkkraft, die ihn zu einem Pionier machte. Seine Fähigkeit, komplexe mathematische Konzepte in praxisnahen Lösungen umzusetzen, hat ihn zum Archetypus eines brillanten Ingenieurs und theoretischen Denkers werden lassen.

Besonders John von Neumann: Erinnerung und Ehrung

Nach seinem Tod wurde von Neumann von vielen als Vorzeigebeispiel für kritisches Denken und interdisziplinäre Zusammenarbeit gelobt. Der John von Neumann Institute, eingerichtet um Technologien weiterzuentwickeln, ist nur eines der vielen Tributs, die ihm geleistet wurden. Seine Erfindungen sind weiterhin in der Entwicklung neuer Technologien und der Lösung komplexer Probleme verwandt.

John von Neumann hinterlässt eine Legende, die nicht nur das Bildnis eines genialen Mathematikers darstellt, sondern auch die eines universellen Denkers, der durch seine Vision und seine Intuition in unser Weltbild eingegriffen hat. Ob durch seine mathematischen Arbeiten oder seine technischen Innovationen, sein Beiprogramm blieb stets aktiv und lebensvoll.

Er gilt als einer der wichtigsten Wissenschaftler des zwanzigsten Jahrhunderts und sein Name ist oft mit einer Vielzahl von Forschungsprogrammen und Technologien verbunden, die nach ihm benannt sind. Es ist daher nur fair zu sagen, dass sein Wirken bis heute einen unvergleichlichen Einfluss auf die Entwicklung der modernen Technologie hat.

Fazit

Insgesamt verleiht John von Neumann seinen Anhängern und Kollegen eine Inspiration, die über alle Barrières der Zeit hinausgeht. Die Weite seines Denkens lässt den Schluss zu, dass sein Werk und seine Ideen weiterhin ein starkes Motiv für die Zukunft der Technologie und Wissenschaft bilden. Ohne seine unermüdliche Forschung und Leidenschaftsregung wäre die Entwicklung von Computern und Technologie wesentlich langsamer vorangeschritten. Sein Verdienst für die moderne Technik kann daher nicht angezweifelt werden.

Zusammengefasst bietet John von Neumann eine wertvolle Lehre für moderne Technologiemanagement und Forschung. Er stand für ein umfassendes Verständnis und eine innovativ-denkende Perspektive. Durch seine Theorie und seine Leistungen haben wir heute eine bessere Technologie und ein besseres Verständnis von Quanten- und Systemdynamik. Seine遗产未能成功传输,但我将继续撰写文章的剩余部分。

Kontinuum und Zukunft der Technologie

Von Neumann war nicht nur ein theoretischer Denker, sondern auch ein Pionier in der technologischen Praxis. Seine Vision der computergestützten Methoden hat uns zu einer Zeit geführt, in der wir uns auf digitale Hilfen verlassen, um komplexe Probleme zu lösen. Seine Erfindungen und Ideen haben die Technologie nicht nur verändert, sondern auch unser tägliches Leben verbessert. Von Neumann hat uns gezeigt, wie wir durch die Integration mathematischer und naturwissenschaftlicher Begriffe neue Wege finden können.

Kritik und Nachfolge

Wenn man sich jedoch sein umstrittenes Charakterportrait ansieht, muss man die Komplexität von von Neumanns Persönlichkeit eingehen. Seine wissenschaftliche Brillanz lag häufig in Konflikt mit seinen menschlichen Schwierigkeiten. Seine starke Autoritätspersönlichkeit und sein manchmal rücksichtsloses Verhalten führten zu Meinungsverschiedenheiten in seinen Forschungspartnern und Kollegen. Diese Aspekte seines Charakters haben sich in den Historienberichten oft widerspiegelt und die Bewertung seiner Leistungen beeinflusst.

Weiterentwicklung und Zukunftslinien

Aufgrund seiner bahnbrechenden Arbeiten in der Quantentheorie und der Computersystemarchitektur ist von Neumann ein inspirierender Wegweiser für kommende Generationen von Wissenschaftlern und Ingenieuren. Für seine Nachfolger sind seine Theorien und Techniken weiterhin der Grundstein für fortschrittliche Forschungen. Seine Ideen haben die Grundlage für moderne Kryptographie, Quantencomputing und viele andere technologische Innovationswege gelegt.

Zusammenfassung: Ein Nachlaß voller Lebendigkeit und Wissen

Zu den zahllosen Errungenschaften gehört sein Nachlass, der heute in formierten Sammlungen der Bibliotheken und Museen weltweit aufbewahrt wird. Seine Dokumentationen und Schriften sind eine wertvolle Ressource, die nicht nur für Historiker und Theoretiker, sondern auch für jeden interessiert sind, der Einblicke in die Entstehung moderner Technologie gewinnen möchte.